在信息产业发展与技术发展过程中 , 过往的安全性问题主要来自于大型软件设计的一个漏洞或者缺陷 , 或者这个缺陷的造成往往被利用了 , 对系统进行攻击产生一些安全问题 。 这个是相对来说容易克服的 , 一旦发现漏洞后 , 把漏洞补上即可解决 。

而发展到人工智能技术时则出现一个全新的安全问题 , 其不是来自于设计时有漏洞 , 而是来源于算法本身的不安全性 。 这个问题是非常难以解决的 , 必须对算法本身做一个彻底的改变 。

8月3日 , 中国科学院院士、清华大学人工智能研究院名誉院长张钹在RealAI主办的人工智能产业治理论坛上作了《人工智能产业治理与创新发展》的报告 , 提出发展第三代人工智能的思路 , 以及如何通过技术创新 , 解决人工智能算法的不安全性问题 。

张钹表示 , 对人工智能的治理有两个含义:一是防止人工智能技术被误用 , 就是无意识的误用 , 因为人工智能算法本身带来不安全问题 , 是很难被预先发现 。 所以 , 有时候在使用过程中间会出现很多错误 , 如果我们在使用的过程中不注意到这个问题会产生无意识地错用 , 造成严重后果 。 第二类问题是有意识(故意)地滥用人工智能技术 , 就是利用人工智能算法的不安全性 , 去造成对人工智能系统的恶意攻击或者滥用 , 这个必须要通过法律法规来解决 , 加以制止 。

张钹此次演讲主要聚焦于算法本身的不安全性问题 , 以及解决之道 。

文章图片

人工智能60年的发展历程可大致划分为两代 。 第一代人工智能主要基于知识库和推理机 , 通过推理模型来模拟人类的理性智能行为 , 如推理、规划、决策等 。 其在计算机内建立了知识库和推理机制并由此对人类的推理和思考行为进行模拟 。 这一代的人工智能一个最有代表性的成果就是国际象棋程序IBM的深蓝 , 其于1997年5月打败了当时的世界冠军卡斯帕罗夫 。

文章图片

张钹曾经一次讲演的ppt

但第一代人工智能十分严重的缺陷在于完全依赖专家的知识 , 一是将知识变成机器可理解执行的内容是十分费时费力的 , 另一方面是还有大量知识很难表达 。 因此第一代人工智能的应用范围非常有限 。

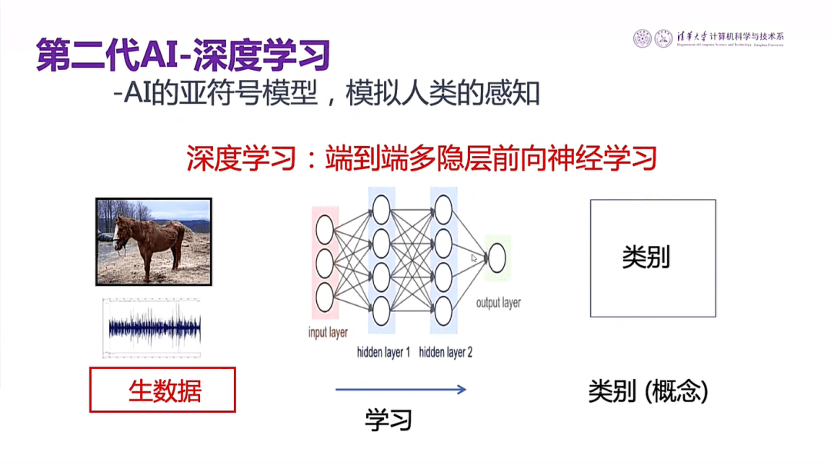

第二代人工智能则使用当下常听到的深度学习方法 , 即通过深度神经网络的模型模拟人类的感知 , 如视觉、听觉、触觉等 。 比如想让计算机识别出马 , 就先收集大量有关动物的图片 , 并把图片分成两类 。 一类作为训练图片 , 训练计算机识别马和其他动物 , 通过多层次神经网络学习 。 另一部分图片(没有学习过的图片)作为检测图片 。 如果90%识别对了 , 识别率即90% , 误识率为10% 。 这种办法不需要领域知识 , 同时由于神经网络规模很大 , 可以处理大量数据 。 在给定图像(语音)库下 , 该方法可以达到甚至超过人类的识别水平 。

文章图片

张钹认为算法的不安全性正是第二代人工智能引起的 。 第二代人工智能使用数据驱动的方法 , 在数据样本比较多的情况下 , 识别率很高 。 但一个非常本质的问题是 , 算法会非常脆弱 , 张钹在现场以一个图像识别案例进行了讲解 。

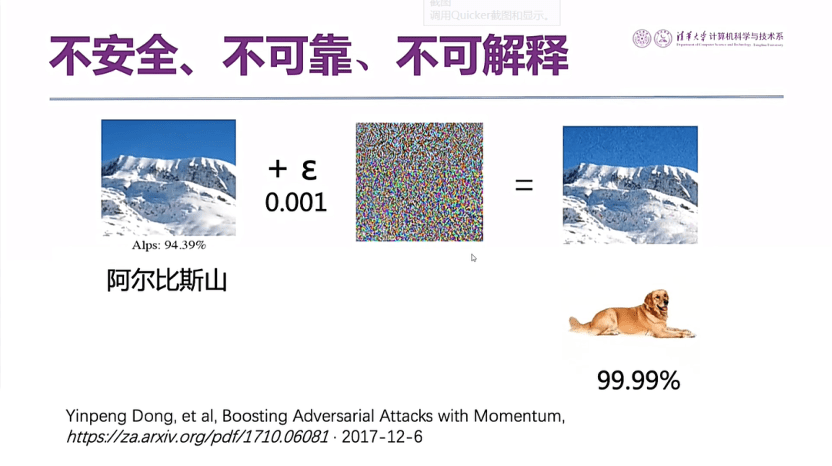

文章图片

张钹首先展示了一幅雪山的图像 , 对于这个图像 , 人类和计算机看起来都是雪山 , 但在雪山图上加上一点噪声 , 人看起来依然是雪山 , 但计算机系统有99.99%的把握认为其是狗 。 张钹认为 , 这个案例很清楚显示出算法的脆弱及易欺骗性 。

文章图片

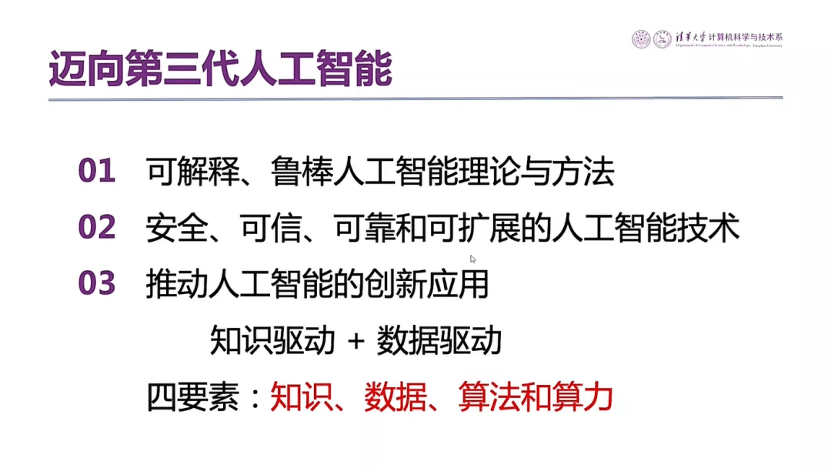

第三代人工智能需要克服第二代算法的不安全 , 不可解释 , 鲁棒性差等问题 。 张钹提出 , 发展第三代人工智能 , 最主要就是建立可解释的鲁棒人工智能理论 , 将知识驱动和数据驱动结合起来 , 充分发挥知识、数据、算法和算力四要素的作用 。

文章图片

第一代人工智能把语义处理(原来符号、知识的处理)放在离散的符号空间内完成 , 第二代人工智能我们把数据放在连续向量空间里来处理 , 这两个空间相互隔离 。 张钹在现场介绍了三空间的混合模型 , 通过这个模型 , 把这两个离散空间的模型跟连续空间的模型打通 , 在原来数据驱动基础上把相关的知识放到向量空间来处理 。

在这个思路下有两种方法 。 范式一是把所有处理都放在一个连续空间里作为向量进行处理 。 原来的深度学习方法 , 即使用非常局部的特征来区分鸟与其他动物 , 是很容易受到攻击的 。 当下的解决方式是尽可能通过各种各样的途径加上用概率或向量的方法表达的知识 。 常用的一种方式是在训练时使用对抗样本 , 即告知机器 , 该样本尽管在某些局部特征上与鸟相同 , 但不是鸟 。 但这种办法只是治标 , 即只对这种对抗样本有识别能力 , 对抗样本换成另外一种形式失去效用 。

范式二是无监督学习的方法 。 无监督学习的内容是建立周围常见物体的模型 , 比如人类的学习方式 , 其在生命早期就建立了狗和猫的模型 , 而且很容易通过举一反三建立起马的模型 。

在计算机中就是通过无监督学习或预训练产生很多马的模型 。 但问题在于建立一个物体的模型 , 特别是像马这样的非刚体模型 , 会有很多种的变形 , 这不仅仅是视觉的不同 , 而是比如像躺下的马与跑起来的马就是完全不同的模型 , 于是建立什么样的模型是需要探讨的问题 。

这两条路都非常艰巨 , 张钹认为 , 发展第三代人工智能是一项非常长期的任务 , 人工智能的安全和治理也是长期任务 , 这个安全问题是算法本身的不安全性引起的 , 要彻底解决还有很长的路要走 。

【向量|张钹院士:解决AI安全问题,把知识驱动和数据驱动结合起来】张钹最后总结道 , 解决人工智能安全性问题必须两手抓 。 一手抓治理 , 第二手抓创新发展 , 要克服人工智能算法本身的不安全性 , 这两者都是长期的任务 。

推荐阅读

- 探测|国内电力气象领域首个“院士工作站”落户上海

- 新药|朱兆云院士:把科研成果转化为对病人最直接的帮助

- 老人|“为你们贴心的服务点赞!”96岁院士接种新冠疫苗加强针

- 月球|院士曾称2030年登月有望!航天局确认研发新一代载人火箭、重型火箭

- 国之|瞭望 | 为国之重器装上“千里眼”“顺风耳”——专访中国工程院院士段宝岩

- 模式|樊建平院士:中国要有自己科技自立自强的模式,而不是紧跟西方

- 风险|中科院院士王建宇:商业航天很火但风险也比较大

- 空间|中国科学院院士王建宇:空间互联网是商业航天的重要切入点

- 中国|信心满满!院士专家看好光明合成生物产业发展

- 团队|深圳研究团队发明可快速修复活体材料,院士高度评价