机器之心报道

编辑:杜伟

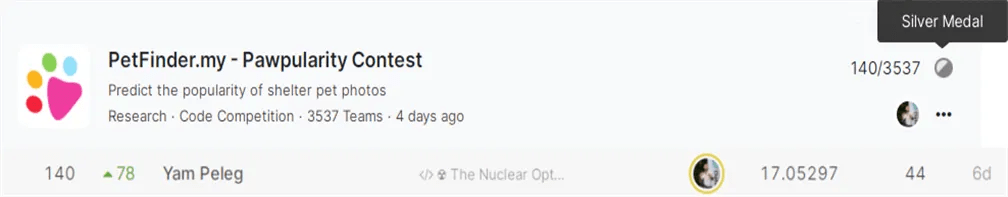

可谓是「无心插柳柳成荫」 。在 Kaggle 的世界 , 软件开发者、金融模式和行为研究公司 Deep trading 的创始人 Yam Peleg 称得上一位「大神」 。 目前 , 他在 Notebooks Grandmaster 中排名第 11 , 在 Discussion Grandmaster 中排名第 5 。

最近 , 他干的一件事在 reddit 上引发了网友热议:他训练了 2021 年的每一个 SOTA 模型 , 并在最近的一项 Kaggle 图像分类比赛中意外斩获了一枚银牌 。 这项 Kaggle 比赛名为「Pawpularity Contest」 , 这是一个典型的多模态回归问题 , 根据宠物图片来预测它们的可爱程度 。

文章图片

图源:https://www.kaggle.com/c/petfinder-pawpularity-score

他的思路是这样的:训练每个 SOTA 模型 , 使用 100 亿参数的集合的集合(ensemble of ensembles)来「核武攻击」(Nuke)Kaggle 比赛的排行榜 。

对于这一策略(trick)的命名 ——「Nuke option」 , 网友表示非常喜欢 , 并将在其他比赛中用这一命名 。

文章图片

另一位网友称赞道 , 「在 Kaggle 环境中完成所有事情真了不起 。 」

文章图片

方案解读

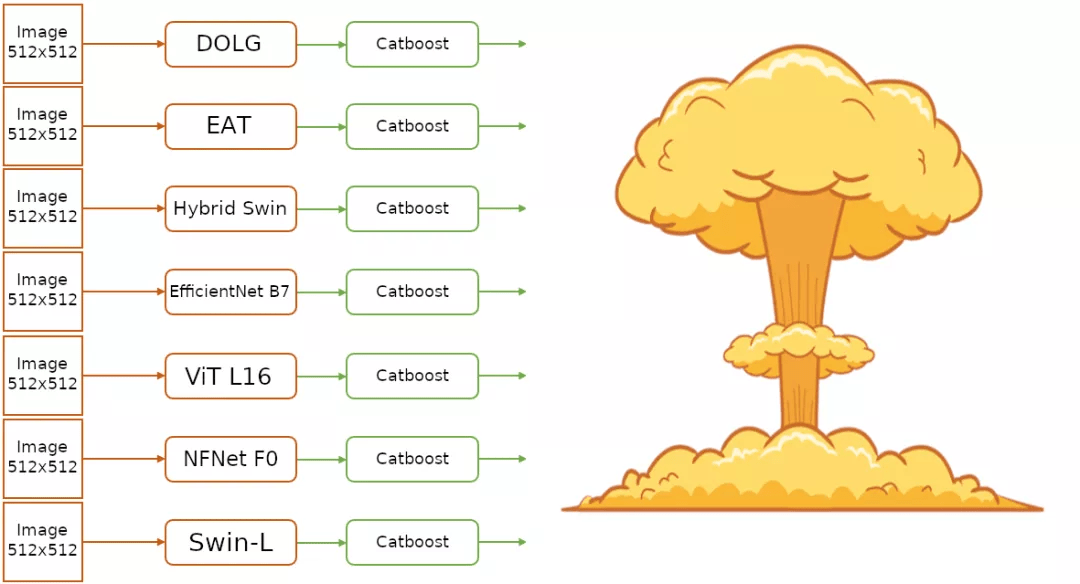

根据 Yam Peleg 的 Notebook 介绍 , 他训练的模型包括如下:

- EfficientNet

- NFNet

- ViT

- Swin Transformer

- Deep Orthogonal Fusion of Local and Global Features(DOLG)

- Hybrid Swin Transformer

- External Attention Transformer(EAT)

文章图片

【Yam|训练2021年每个SOTA模型,他的「核武」策略意外收获Kaggle银牌】实现步骤

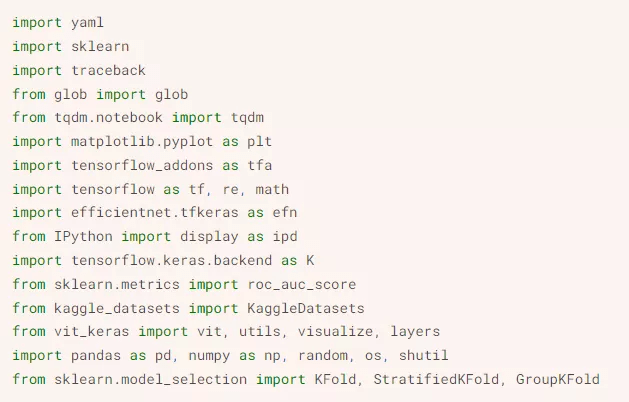

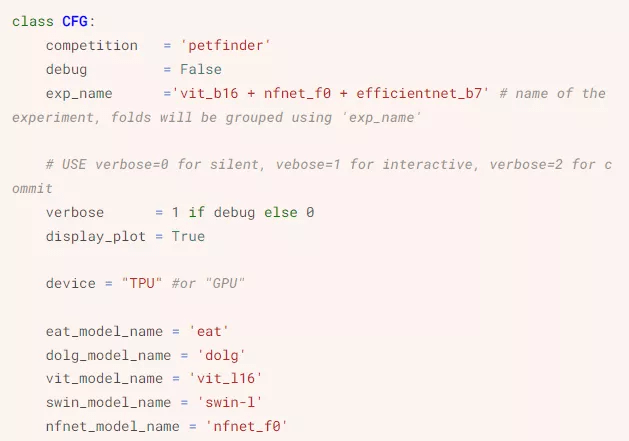

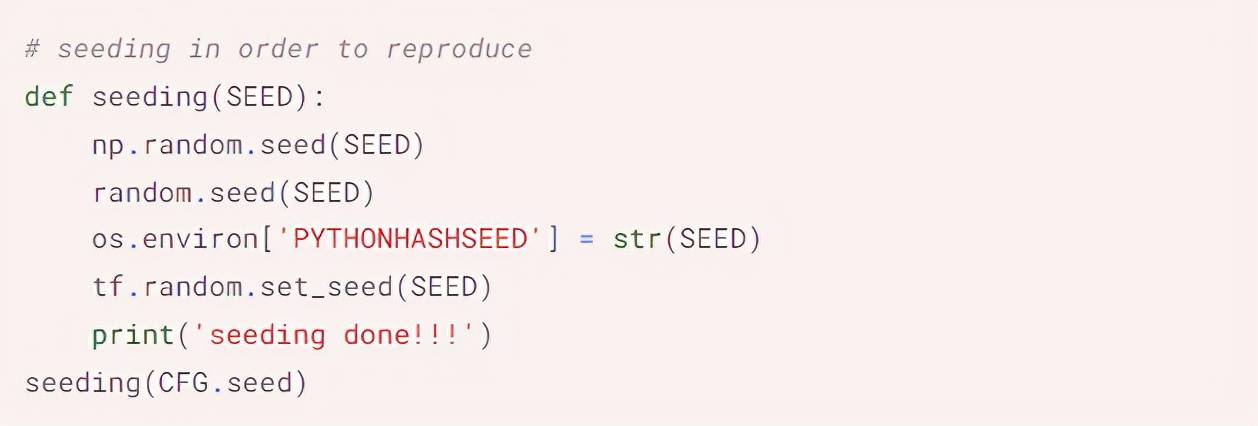

训练这些 SOTA 模型之前 , Yam Peleg 首先导入库:

文章图片

接着安装其他配置 , 完成数据填充(seeding):

文章图片

文章图片

配置部分截图

然后是 TPU 配置、加载元数据、CV 的分层 K 折回归(Stratified KFold for Regression)、增强(Augmentations)等步骤 。 数据 pipeline 如下所示:

- 读取原始文件 , 然后解码到 tf.Tensor

- 按需求重新调整图像大小

- 将数据类型变为 float32

- 缓存数据以提升速度

- 使用增强来降低过拟合 , 并使模型更稳健

- 将数据分割为 batch

文章图片

完整排行榜:https://www.kaggle.com/c/petfinder-pawpularity-score/leaderboard

参考链接:

https://www.kaggle.com/yamqwe/the-nuclear-option-train

https://www.reddit.com/r/MachineLearning/comments/s6spou/p_i_trained_every_single_sota_from_2021_and/

推荐阅读

- MLP-Mixer|CV之后,纯MLP架构又来搞NLP了,性能媲美预训练大模型

- 市场|2021年4季中国手机出货第二之争:三咨询公司都没给小米

- 硬件|Canalys:2021年全球电动汽车销量增长109%,中国大陆占一半

- 信息|安恒信息入选工信部2021年工业互联网试点示范项目名单

- 最新消息|格力电器:拟实施2021年中期分红 每10股派发股利10元

- 全年|2021年贵州大数据领域各项指标超额完成

- 解决方案|联想智慧训练解决方案现身《杨扬探冬奥》

- Google|谷歌2021年向安全研究人员颁发了870万美元的漏洞报告奖励金

- 吉林|吉林8地上榜!2021年度国家卫生城镇名单公布

- 空间站|[朝闻天下]《中国航天科技活动蓝皮书(2021年)》发布 我国载人空间站今年将完成建造