算法|算法推荐终于可关闭,中国规定开世界先河

3月1日起 , 国家网信办等四部门联合发布的《互联网信息服务算法推荐管理规定》正式施行 。 “向用户提供便捷的关闭算法推荐服务的选项”等规定 , 贴近用户实际需求 , 而且在全球范围内开启对具体算法加以监管的先河 , 因此广受关注 。 本文分析了相关规定的来龙去脉 , 以及未来可能的发展 。

文 观察者网专栏作者 熊节

马酷洞察创始人/总编

手机上的App会“读心术”早已不是秘密了 。 很多人有过这样的体验:刚和朋友聊天说到什么想买什么 , 转眼就在某App里看见了这件商品;刚浏览了几条某个主题的新闻 , 突然某App里就全是关于这件事的回答 。

长期来 , 许多网民对这种情况感到不满 , 甚至有点恐惧 。

如今 , 一个开关“千呼万唤始出来” , 在许多常用App的“设置”页 , 您应该能找到“关闭个性化推荐”之类的选项 。

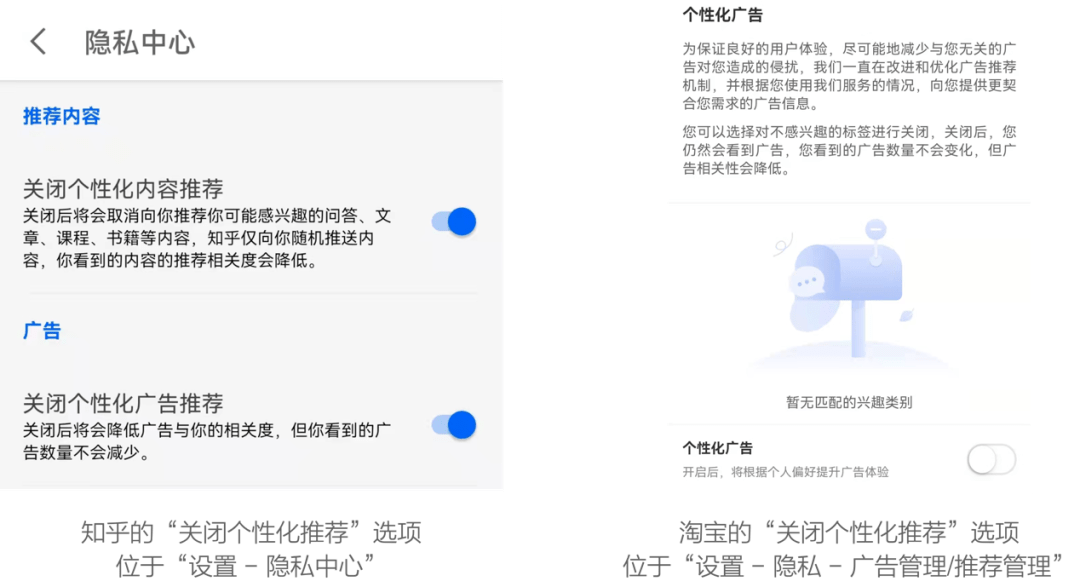

笔者找到了“知乎”和“淘宝”的相关开关并亲测:

文章图片

为何各个常见的App悄悄给出了关闭个性化推荐的选项?原因是今年1月4日正式公布的 《互联网信息服务算法推荐管理规定》(下文简称《规定》)中有这么一条:

第十七条 算法推荐服务提供者应当向用户提供不针对其个人特征的选项 , 或者向用户提供便捷的关闭算法推荐服务的选项 。 用户选择关闭算法推荐服务的 , 算法推荐服务提供者应当立即停止提供相关服务 。

这份由国家互联网信息办公室、工业和信息化部、公安部、国家市场监督管理总局联合发布的《规定》将于今年3月1日正式起施行 。

据笔者所知 , 这是全世界第一个对算法推荐行为加以具体约束的法案 。

欧洲的《数字市场法案》(DMA)中也有“不允许利用数据优势向用户投放指向性广告 , 除非获得用户明确许可”的约定 , 但DMA去年11月才获得欧洲议会内部市场委员会通过 , 与欧洲各国政府的谈判还未启动 , 完成立法仍有一段距离 。

而中国各大互联网企业已经在以实际行动迎接《规定》的落地 。

算法推荐的潜在危害

2006年 , 哈佛大学凯斯·桑斯坦教授在《信息乌托邦》一书中提出 , 人类社会存在一种 “信息茧房”现象 。 他认为 , 在信息传播中人们自身的信息需求并非全方位的 , 只会注意选择自己想要的、能使自己愉悦的信息 , 久而久之接触的信息就越来越局限 , 就像蚕吐出来的丝一样 , 细细密密地把自己包裹起来 , 最终将自己桎梏在“信息茧房”内 , 失去接触和了解不同观念的机会 。

算法推荐则有可能强化信息茧房效应:你越是对某种事物感兴趣、倾向于某种观念 , 算法就会越是给你推荐关于这种事物、支持这种观念的材料 , 让你不断强化自己的兴趣和倾向 。 而且 , 算法推荐还可能被有目的性地引导人群 , 从而影响公众观念 , 甚至影响政治决策 。 因此 , 美国数学家凯西·奥尼尔在《算法霸权》一书中将推荐算法称作“数学大杀器”(weapons of math destruction) 。 在过去几年中 , 这件“大杀器”已经在现实世界中多次产生效果 。

就在美国大选前几个月 , 英国的剑桥分析(Cambridge Analytica)公司使用来自脸书的用户数据操纵了英国脱欧(Brexit)公投 , 令脱欧派意外获胜——与特朗普意外当选如出一辙 。

在正式用于影响英美政局之前 , 类似的手段已经在多个发展中国家做过实验 。 2010年 , 在特立尼达和多巴哥 , 一场起源于脸书的“Do So”运动让大批非洲裔选民拒绝投票 , 从而使印度裔主导的联合民族大会(UNC)在大选中受益 。 2015年 , 部分尼日利亚用户在脸书上看到暴力血腥、仇视穆斯林的视频短片 , 其目的是恐吓选民、操纵选举 。算法推荐一旦被滥用 , 真的可以成为“大杀器” 。

即使不是被故意滥用 ,算法推荐也可能暗含社会的偏见和歧视 。 去年10月 , 推特的推荐算法被发现“无意中放大了右翼团体内容的传播”:政治右翼当选官员发布的推文在算法上被放大的程度超过政治左翼;右翼媒体比左翼媒体的影响力更大 。

更早之前 , 职场社交网站领英的搜索算法(也可以看作一种形式的推荐算法:根据搜索关键词推荐“最匹配”的内容) 被发现存在性别歧视 , 男性求职者会被放在更高的位置 。 谷歌的广告平台AdSense被发现存在种族偏见 , 如果搜索关键词看起来像是黑人的名字 , AdSense就会有更大概率推荐犯罪记录查询相关的广告 。

因为算法推荐有这些潜在危害的风险 , 欧美一些研究者很早就提出对推荐算法加以管制 。 本次《规定》中要求的算法机制机理审核、科技伦理审查、允许用户关闭算法推荐等措施 , 在国外都早有人提过建议 。 然而国际互联网大厂从未将这些建议落地 , 还经常辩称“基于深度学习的算法无法被审核” 。 为了帮助读者理解《规定》的重要意义 , 笔者将简要介绍算法推荐背后的技术原理 。

算法推荐的技术原理

各种形式的算法推荐 , 包括《规定》中列举的“生成合成、个性化推送、排序精选、检索过滤、调度决策”等形式 , 当下主流的实现方式都是采用机器学习(machine learning) , 背后的原理都是基于贝叶斯统计(Bayesian statistics)方法的预测——听起来很高深 , 其实通过一个简单的例子很容易就能理解 。

假设你丢一个以前没用过的骰子 , 你认为有多大概率丢出6点?当然 , 在没有任何额外信息的情况下 , 你的预测是“1/6” 。 然后 , 你连续丢了20把 , 每把都是6点 , 这时候你认为下一把继续丢出6点的概率是多大?经典概率论说 , 每次丢骰子都是一个独立随机事件 , 过去丢出的点数不影响未来丢出的点数 , 所以你的预测仍然应该是“1/6” 。 但很明显正常人不会这么想 。

“这个骰子连丢了20把6点”这项信息很明显会影响对未来的决策(例如可能说明这个骰子被灌了铅) , 因此你会预测下一把有很大概率还是会丢出6点 。 简化地说 , 贝叶斯统计就是“基于过去已经发生过的事件预测未来将要发生的事件” 。 各种算法推荐都是在进行这样的预测:

知乎的 个性化推送就是预测用户可能喜欢看什么问题和回答;

百度的 检索过滤就是预测用户可能对哪些搜索结果感兴趣;

淘宝的 排序精选就是预测用户可能购买哪些商品 。

这些预测所基于的“过去已经发生过的事件”则是与用户相关的、非常宽广的数据集 , 不仅包含“用户看过/赞过/收藏过哪些回答”这种直接的用户行为 , 还包含大量用户本身的属性信息:年龄、性别、地域、教育程度、职业、上网设备、买过什么东西、发过什么言论、住多大房子、家里几口人、喜欢张信哲、反感蔡徐坤……这些信息都会被用于预测用户的偏好 。

每一项类似这样的属性信息也被称为“特征”(feature) , 对于一个普通用户 , 互联网公司通常拥有数千、数万项特征信息 。 其中一些特征信息来自该公司本身的业务 , 更多的特征信息来自其他平台 , 三大运营商、微博、腾讯、阿里、手机制造商等企业都会SDK(软件开发包)的方式与其他互联网应用共享用户个人特征信息 。

文章图片

知乎与第三方共享个人信息的清单(部分)

在所有这些特征信息中 , 给定一项具体的预测 , 有些特征与这项预测的相关度较高 , 有些特征的相关度则较低 。 如果能从预测的结果回溯到哪些特征产生了重要的影响 , 我们就可以说这种算法“具备可被审核性”(auditable) 。 例如最简单、最基础的机器学习算法线性回归(linear regression) , 其原理就是根据过去的事件给每项特征打一个权重分数 , 然后根据这些权重分数预测未来的事件 。 从一个线性回归的预测模型中 , 可以直观地看到每项特征的在预测中的权重 , 因此线性回归是特别容易审核的一种算法 。

当然 , 最简单、最基础的算法 , 也就存在预测能力不够强的问题 。 形象地说 , 只用简单的线性回归 , 无法把特征值里隐含的信息全都榨取出来 , 所以预测效果不见得特别好 。 于是科学家和工程师们想了很多办法来压榨特征值里的信息 。 一种办法叫“特征工程”(feature engineering) , 说白了就是从已知的特征值推导出新的特征值 , 例如根据用户的手机型号、购物清单给用户打上“购买力强”或者“时尚潮人”的新标签 , 这就是一种简单的特征工程 。

另一种压榨特征值的办法是把起初的特征信息视为一“层”输入 , 然后用各种数学方法把输入层变换成新的信息节点 , 从而形成一个多层的“网络” 。 这个变换的过程可以重复进行 , 变换的层数越多 , 就说这个网络越“深”——这就是“深度学习”(deep learning)这个词的由来 。

尽管科学家经常用“神经元”、“神经网络”来类比这些数学变换的结果 , 但很多时候 , 经过这些变换得到的信息节点几乎没有现实世界中的含义 , 纯粹是一种数学工具的产物 。 所以业界有一种说法:深度学习就像炼金术(国内也称“炼丹”) , 把数据丢进神经网络 , 不知道什么原因就炼出结果了——如果结果不理想 , 就再加几层神经网络 。

我国《规定》的意义和疑虑

正因为业界对算法推荐、对深度学习技术的依赖 , 此次的《规定》才显得尤为重要 。 笔者认为 , 《规定》的公布 , 一方面迫使互联网企业约束自身行为 , 要用算法推荐技术为善 , 坚持主流价值导向、积极传播正能量 , 而不能制造信息茧房、诱导用户沉迷;另一方面迫使互联网企业加强内部能力建设 , 建立算法审核能力 , 主动选择并优化可被理解、可被审核的推荐算法 , 而不能搞唯技术论、过度依赖“炼金术”式的推荐算法 。

不过 , 毕竟此次的《规定》是一个开世界先河的新事物 , 在其实施过程中 , 笔者还是有一些具体的疑虑 。

首先 ,算法机制机理审核和科技伦理审查如何落实 , 对于监管机构可能是一个新的挑战 。 虽然《规定》要求“算法推荐服务提供者应当定期审核、评估、验证算法机制机理、模型、数据和应用结果” , 但这项要求是否落到实处 , 互联网企业是否真的进行了审核、评估和验证 , 算法结果是否合乎要求 , 其中可能有很大模糊空间 。 毕竟算法推荐审核不像违法不良信息审核 , 只要发现违法不良信息立即就能知道审核过程有问题 , 而算法推荐审核的效果是在长期、大范围的统计意义上表现出来的 , 如何核实审核是否确实落地 , 本身可能就是一个技术难题 。

其次 , 说明提供算法推荐服务的情况和允许用户关闭个性化推荐的选项 , 虽然各主要互联网企业已经实现了这些功能 ,但很难说是“以显著方式”告知用户 。 笔者作为IT专业人士 , 又是有意寻找 , 仍然花了一番功夫才找到几大App分别把“关闭算法推荐”的选项藏在哪里 。

当然从互联网企业的角度 , 他们肯定希望把这个功能藏在大多数用户找不到的地方 , 毕竟绝大多数用户找不着的功能就等于不存在的功能 。 那么从监管立场 , 为了避免“用户关闭算法推荐服务”的权利变成一句空话 , 是否应该考虑像GDPR那样 , 要求用户“明确许可”之后才能提供个性化推荐?

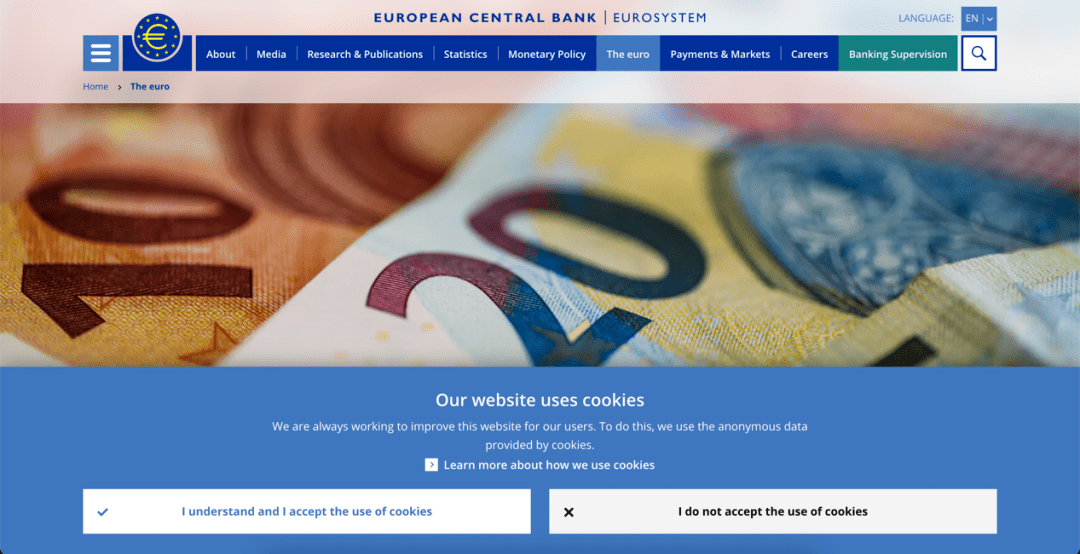

文章图片

GDPR要求网站必须获得用户明确许可后才能通过Cookie记录用户信息 , 迫使网站以真正显著的方式征求用户许可

最后 , 在《规定》的监管下 , 互联网企业虽然不能强行提供个性化推荐, 却仍有可能以“消极怠工”的方式迫使用户开启(或者不能关闭)个性化推荐 。

以知乎为例 , 一旦在隐私中心中勾选“关闭个性化推荐”选项 , 那些信息茧房式的推荐信息倒是没了 , 但App里出现的信息量也急剧减少 。 笔者大致统计一下 , 关闭个性化推荐之后 , 知乎App的“精选”页每天出现的新条目不超过3条 , 很多天以前的回答还在不断出现 , 甚至多次出现第一页里出现两条重复信息的情况 , 而访问量最大的“知乎热榜”的内容却从未被推送到“精选”页面 。 偌大一个知乎 , 关掉个性化推荐之后就没有内容可以向用户推荐了吗?恐怕还是打算用削减内容量的办法软磨硬泡用户不要关掉个性化推荐吧 。 这类消极怠工的办法 , 相信互联网企业还能想出很多 。 监管机构应当如何发现、如何应对这些小伎俩 , 对《规定》的落实也是个新的挑战 。

尽管有这些现实的疑虑 , 此次的《规定》毕竟开启了对互联网具体算法加以监管的先河 。 过去互联网技术长期被政府和公众视为神秘的黑盒 , 只能从外部可见的结果加以监管 , 给资本和技术人员留下了太多搞小动作的空间 。 希望《规定》成为打开黑盒的第一步 , 与后续的其他监管政策和落地措施一道 , 揭开互联网技术神秘的面纱 , 把那些藏在盒子里的把戏都曝露在阳光下 , 接受合理的监督管理 。 同时也希望相关监管机构尽快建立起足够的技术能力 , 真正把这些监管措施落到实处 。

【算法|算法推荐终于可关闭,中国规定开世界先河】来源|观察者网

推荐阅读

- 最新消息|工信部信息通信管理局召开行政指导会 规范App推荐下载行为

- 信息内容|禁恶意炒作滥用算法,“弹窗推送”将有规可依

- 用户权益|谨防算法成“算计”

- js|新书推荐|SSM + Spring Boot + Vue.js 3全栈开发从入门到实战

- ARMMali-G|发哥终于成了?天玑8100工程机测试曝光:865的功耗,888的性能

- 推荐人|油慧云智慧加油站系统功能升级三级会员推荐积分机制

- 利器|好物推荐 | 四款教学利器助力新学期创意课堂

- 信息|把好算法“方向盘”,信息供给少点“投其所好”

- 相关部门|防止“算法”变“算计”

- 工作日|互联网信息服务算法备案系统上线,已有部分算法提供者备案