流量|20 个 GPU 可承载相当于全球互联网流量、Grace CPU 超级芯片现世,英伟达这届 GTC 发布了什么?

整理 | 苏宓

出品 | CSDN(ID:CSDNnews)

技术的极限在哪里?

想必科技圈给出回答大概率是没有!

这不 , 在 GTC 2022 Keynote 上 , 身着黑色夹克「战袍」的黄仁勋挂帅 , 英伟达带着采用台积电 4nm 工艺建造、拥有 800 亿个晶体管的 H100 GPU , 基于最新 Arm v9 架构的 Grace CPU , 以及具有元宇宙属性的 Omniverse 和自动驾驶平台 Hyperion 9 等软硬件再次刷新了自己乃至全行业的记录 。

文章图片

20 个 H100 GPU 可维持相当于整个世界的互联网流量?

英伟达 , 一家你可以称之为“芯片霸主” , 也可以叫做是一家人工智能计算以及元宇宙大玩家的公司 。

在其最擅长的 GPU 领域中 , 英伟达宣布 Hopper? 架构的下一代加速计算平台到来 , 它的性能比上一代产品跃升了一个数量级 , 大力推动了下一波人工智能数据中心的发展 。

这款新架构以美国计算机科学家先驱 Grace Hopper 的名字命名 , 替代两年前推出的 NVIDIA Ampere 架构 。

除此之外 , 英伟达还发布了其首款基于 Hopper 的 GPU——英伟达 H100 。

文章图片

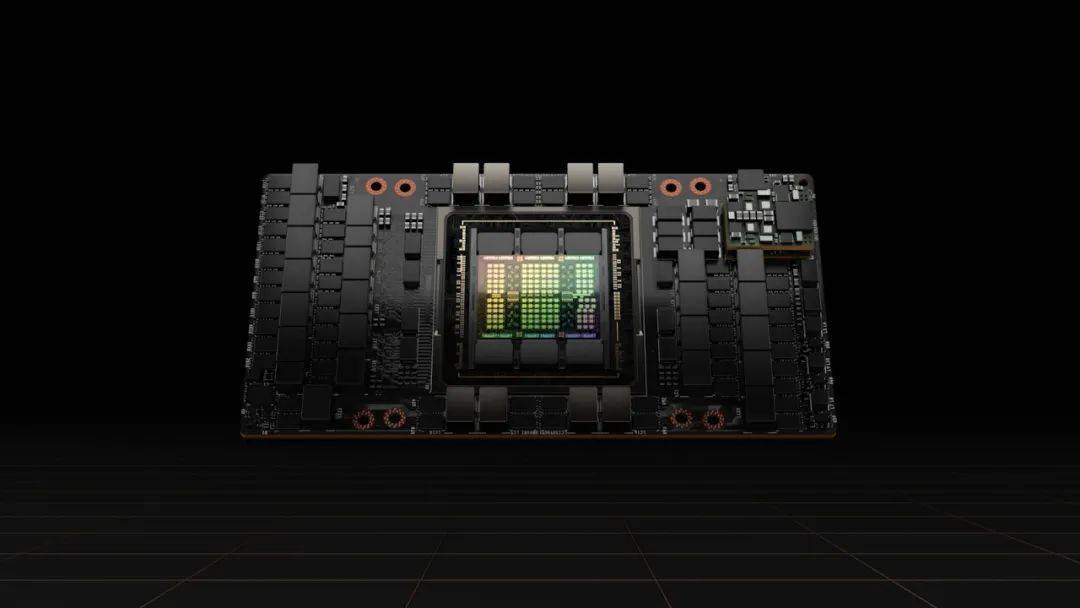

作为 A100 的替代者 , 在设计方面 , 与之前网传 5nm 工艺制造有所偏差 , 这款 H100 采用了当前最先进的台积电 4nm 工艺、拥有 800 亿个晶体管 , 可以加快 AI、HPC、内存带宽、互连和通信的发展 , 甚至能够实现每秒近 5 兆字节的外部连接 。

在性能方面 , H100 采用了自然语言处理的标准模型 , 即新的 Transformer Engine 。 H100 加速器可以将这些网络的速度提高到上一代的 6 倍而不损失精度 。

此外 , H100 也是第一个支持 PCIe Gen5 的 GPU , 也是第一个利用 HBM3 的GPU , 实现了 3TB/s 的内存带宽 。 20 个 H100 GPU 可以维持相当于整个世界的互联网流量 , 使客户有可能提供先进的推荐系统和大型语言模型实时运行数据推理 。

除了以上 , H100 还在技术上实现了以下突破:

- 实现第二代安全多实例GPU 。 上一代产品中 , 英伟达的多实例 GPU 技术可将一个 GPU 划分为七个较小的、完全隔离的实例 , 以处理不同类型的工作 。 通过在云环境中为每个 GPU 实例提供安全的多租户配置 , Hopper 架构将 MIG 功能比上一代扩展了 7 倍 。

- 保密计算 。 H100 是世界上第一个具有保密计算能力的加速器 , 可以在处理 AI 模型和客户数据时保护它们 。 客户还可以将保密计算应用于医疗保健和金融服务等隐私敏感行业的联邦学习 , 以及共享云基础设施上 。

- 支持第四代 NVLink 技术 。 为了加速最大的人工智能模型 , 英伟达将 NVLink 与新的外部 NVLink Switch 相结合 , 将 NVLink 作为扩展网络扩展到服务器之外 , 与使用 NVIDIA HDR Quantum InfiniBand 的上一代相比 , 最多可以连接多达 256 个 H100 GPU , 带宽也高出了 9 倍 。

- 新的 DPX 指令对动态编程进行了加速 , 该指令被广泛用于各种算法 , 包括路线优化和基因组学 。 与 CPU 相比 , 动态编程的速度提高了 40 倍 , 与上一代 GPU 相比提高了 7 倍 。 这包括 Floyd-Warshall 算法 , 为动态仓库环境中的自主机器人车队寻找最佳路线 , 以及 Smith-Waterman 算法 , 用于 DNA 和蛋白质分类和折叠的序列对齐 。

值得注意的是 , 英伟达还基于 H100 发布了系列产品 。

“人工智能从根本上改变了软件的功能和生产方式 。 用人工智能彻底改变他们的行业的公司意识到他们的人工智能基础设施的重要性 , ”黄仁勋如是说道 , “我们新的 DGX H100 系统将为企业 AI 工厂提供动力 , 将数据提炼成我们最有价值的资源——智能 。 ”

基于 Hopper 架构的 H100 , 英伟达推出了 第四代 DGX? 系统 DGX H100 。

DGX H100拥有 8 颗 H100 GPU , 可以在新的 FP8 精度下提供 32 petaflops的 AI 性能 , 提供的规模可以满足大型语言模型、推荐系统、医疗保健研究和气候科学的大规模计算需求 。

DGX H100 系统中的每个 GPU 都由第四代 NVLink 连接 , 提供 900GB/s 的连接速度 , 比上一代多 1.5 倍 。 NVSwitch? 使 H100 的所有八个 GPU 都能通过 NVLink 连接 。

英伟达表示 , 它还可以使用其 NVLink 技术连接多达 32 个 DGX(总共包含 256 个 H100 GPU) , 从而创建一个“DGX Pod” 。

「DGX POD 的带宽是每秒 768 terbyte , 作为对比 , 目前整个互联网的带宽是每秒 100 terbyte , 」黄仁勋解释道 。

而多个 DGX Pod 连接在一起可以创建 DGS Superpods , 黄仁勋将其称之为“现代 AI 工厂” 。

在这一方面 , 英伟达还开发了一款名为 Eos 的全新超级计算机 , 它将配备 18 个 DGX Pod 。 在 AI 处理能力上 , 它将是当前世界上最强大的超级计算机 Fugaku 的四倍 。

预计 Eos 将在未来几个月内上线 , 并将成为世界上最快的 AI 计算机 。

两个 CPU 组成的超级芯片——Grace CPU Superchip

在 CPU 领域 , 黄仁勋在主题演讲上正式分享了英伟达第一款为数据中心设计的 Arm CPU 芯片——Grace CPU Superchip 。

文章图片

之所以将其称之为超级芯片 , 黄仁勋表示 , 该芯片将使英伟达芯片的性能和能效提高一倍 。

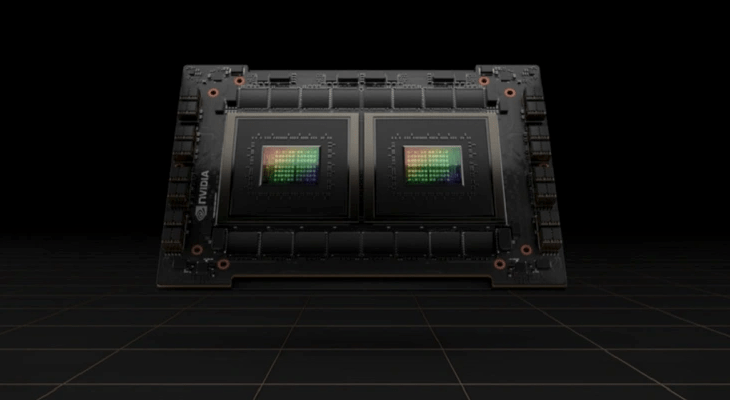

不过 , 本质上来看 , 这款超级芯片是两个 CPU 的合体 , 其内部有两个 CPU 芯片组成 , 通过 NVLink-C2C(这是一种新的高速、低延迟、芯片到芯片互连)互连技术融合在一起 。

英伟达表示 , Grace CPU 超级芯片旨在提供最佳的效能表现 , 其单一 CPU 搭载 144 个 Arm Neoverse 核心 , 并在 SPECrate2017_int_base 基准测试中获得 740 分预估效能 。

这与目前随 DGX A100 出货的双 CPU 相比 , 效能表现要高出 1.5 倍以上 , 这是英伟达实验室中用同一类编译器预估的结果 。

Grace CPU 超级芯片的 LPDDR5x 内存子系统提供的带宽是传统 DDR5 设计的两倍 , 达到每秒 1 兆字节 , 同时功耗大大降低 , 整个 CPU 包括内存的功耗只有 500 瓦 。

英伟达表示 , Grace CPU 超级芯片将在要求最严格的 HPC、AI、数据分析、科学计算和超大规模计算应用中表现出色 , 具有最高的性能、内存带宽、能源效率和可配置性 , 且将在 2023 年初发货 。

首款 Omniverse 计算系统 OVX

【流量|20 个 GPU 可承载相当于全球互联网流量、Grace CPU 超级芯片现世,英伟达这届 GTC 发布了什么?】作为元宇宙领域的大玩家 , 英伟达在今年 GTC 开发者大会上推出了一种新的工业数字孪生计算系统——OVX 。

OVX 创建目的是在 Omniverse 中运行数字孪生模拟 , Omniverse 是英伟达发布的“一个实时物理精确的世界模拟和 3D 设计协作平台” 。

“正如我们为 AI 提供 DGX , 我们现在为 Omniverse 提供 OVX” , 黄仁勋如是说道 。

OVX 是第一款 Omniverse 计算系统 , 由八个 Nvidia A40 GPU、三个 Nvidia ConnectX-6 Dx 200-Gbps NIC、双 Intel Ice Lake 8362 CPU、1TB 系统内存和 16TB NVMe 存储组成 。

当与 Spectrum-3 交换结构连接时 , OVX 计算系统可以从 8 个 OVX 服务器的单个 pod 扩展到 32 个 OVX 服务器的 SuperPOD。 还可以部署多个 SuperPODS 以满足更大的模拟需求 。

据英伟达官方表示 , “OVX 将使设计师、工程师和规划人员能够构建物理上精确的建筑物数字孪生 , 或创建大规模、真实的模拟环境 , 并在物理和虚拟世界之间实现精确的时间同步 。

黄仁勋也在演讲中指出 , 由于工业系统的复杂性 , “Omniverse 软件和计算机需要具有可扩展性、低延迟和支持精确的时间” , 并且由于数据中心在尽可能短的时间内处理数据 , 而不是在准确的时间 , 因此英伟达想用 OVX 创建一个“同步数据中心” 。

当前第一代 OVX 系统已经在英伟达内部以及一些早期客户中部署 , 第二代系统目前正在开发中 , 它将受益于英伟达今日新推出的 Spectrum-4 以太网平台 。

Spectrum-4 是一种每秒 51.2 Tbps、1000 亿晶体管的以太网交换机 , 可实现纳秒级计时精度 。

除此之外 , 在 Omniverse层面 , 英伟达还发布了 Omniverse Cloud 新品 , 这是一项旨在促进创意人员和工程师之间实时 3D 设计协作的云服务 。

Omniverse Cloud 据说可以消除由于需要多个设计师在各种不同的工具和不同的位置一起工作而产生的复杂性 。

“我们希望 Omniverse 能够接触到数以千万计的设计师、创造者、机器人专家和人工智能研究人员中的每一位 , ” 黄仁勋说道 。

自动驾驶DRIVE Hyperion 9

自动驾驶 , 一个近年来各大科技巨头「兵刃相见」的领域 , 谁都知道这是一块香饽饽 , 但是拿得下拿不下都得凭借真本事 。

和苹果想要将软硬件生态全部握在自己手中的造车愿景不同 , 英伟达在自动驾驶领域目标很明确 , 就是一步一步构建完全自动驾驶方案 。

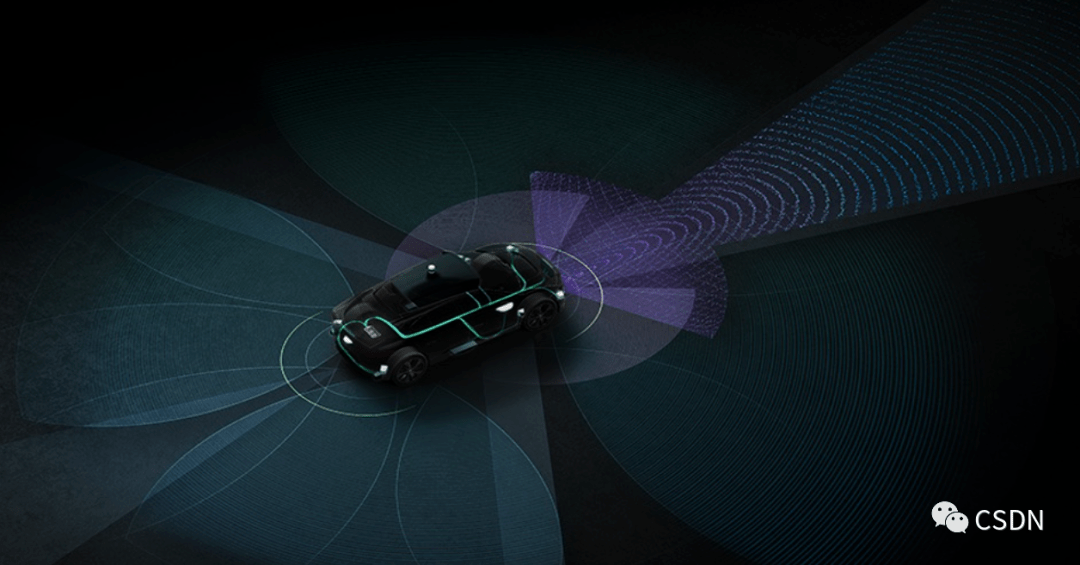

继 2019 年发布面向自动驾驶的 Orin 芯片并于本月正式投产销售之后 , 这次英伟达发布了用软件定自动驾驶的下一代平台—— DRIVE Hyperion 9 。

文章图片

据官方介绍 , DRIVE Hyperion 9 平台采用了开放式、模块化设计 , 包含了计算机架构、传感器组以及完整的 NVIDIA DRIVE 司机和礼宾服务应用程序 , 也方便开发者在开发时各取所需 。

同时 , 英伟达在 DRIVE Hyperion 9 架构的计算中加入了冗余功能 。 另外 , 采用了 2021 年发布的 DRIVE Atlan 车规系统芯片 , 其性能是基于 Orin 芯片的两倍以上 。 在详细参数层面 , DRIVE Hyperion 9 架构包括用于自动驾驶和自主驾驶的 14 个摄像头、9 个雷达、3 个激光雷达和 20 个超声波 , 以及用于内部乘员感应的 3 个摄像头和 1 个雷达 。

英伟达还将 DRIVE Hyperion 比作车辆的神经系统 ,DRIVE Atlan 作为大脑 , 英伟达这一代系统的规模从 NCAP 到 3 级驾驶和 4 级停车 , 具有先进的 AI 驾驶舱功能 。

英伟达计划 DRIVE Hyperion 9 将于 2026 年量产车辆 , 同时可编程架构建立在多台 DRIVE Atlan计算机上 , 以实现智能驾驶和车内功能 。

参考资料:

https://nvidianews.nvidia.com/news/nvidia-announces-hopper-architecture-the-next-generation-of-accelerated-computing

https://blogs.nvidia.com/blog/2022/03/22/drive-hyperion-9-atlan/

https://venturebeat.com/2022/03/22/nvidia-introduces-arm-based-grace-cpu-superchip/

END

? 小米首款汽车预计2024年量产;英伟达发布首款基于Hopper架构GPU;Java 18 正式发布|极客头条

?近7成开发者无开源收入、最想操作系统开源、Java最受欢迎 | 揭晓中国开源开发者现状

?苹果被罚3.1635亿元 , 因不愿开放第三方支付!

—点这里 ↓↓↓记得关注标星哦~—

一键三连 「分享」「点赞」「在看」

成就一亿技术人

推荐阅读

- 系列|折叠手机何处去?下个月vivo的X Fold将给出答案

- 合成|从4K到16K仅用一张图像训练,首个单样本超高分辨率图像合成框架

- 数字货币|Yuga Labs筹集了4.5亿美元 致力打造一个NFT元宇宙

- nVIDIA|NVIDIA阉割H100 GPU图形功能:1.8万核心砍到512核心

- 视点·观察|各大App允许用户一键关闭“个性化推荐”后,还会有“大数据杀熟”吗?

- 市场|【独家】欧美起家的一加手机,今年将进入2800个中国县城

- Microsoft|微软和NVIDIA合作:将云端加密扩展到GPU上

- 用户个人信息|长度堪比论文,APP用户协议怪象怎么破

- 场景|贵州将打造200个5G应用场景

- 乱象|整改最新进展!豆瓣解散“古玩杂货摊”等15个问题小组