正如波特兰州立大学计算机科学教授梅拉妮·米歇尔在《AI 3.0:思考人类的指南》一书中所说的那样 , 当下的人工智能技术对你可能一直在使用的许多服务都起到了核心作用 , 有些甚至你都没有意识到 , 如语音转录、GPS导航和出行规划、垃圾邮件过滤、语言翻译、信用卡欺诈警报、书籍和音乐推荐、计算机病毒防护以及建筑物能源利用优化等 。

但在人工智能为我们的生活带来各种便利之余 , 人们也难免产生担忧和质疑:让人工智能来接管那些枯燥无聊、令人疲倦、有辱人格或者极其危险又工资低廉的工作真的能够造福社会吗?人工智能的研究与开发应在多大程度上受到监管?又应该由谁来监管?人们倾向于应该针对人工智能领域制定监管和道德规范 , 但尚未达成普遍共识的地方在于:是应该立即将重点放在能够解释人工智能系统推理过程的算法方面 , 还是关于数据的隐私方面 , 或是人工智能系统对恶意攻击的鲁棒性(指在异常和危险情况下系统生存的能力)方面 , 又或是关于人工智能系统的偏见以及关于超级智能潜在的风险方面?

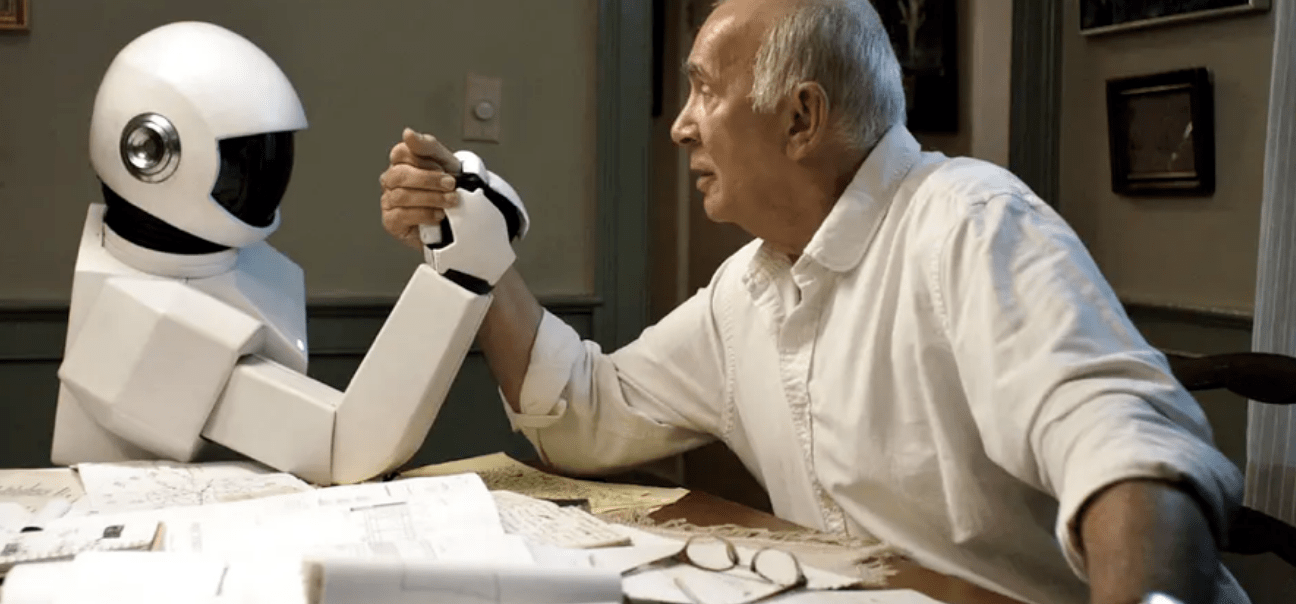

文章图片

电影《机器人与弗兰克》(2012)剧照 。

对于即将到来的人工智能时代 , 人们的态度截然不同:有人认为人工智能实际上能够消除全球贫困 , 大规模减少疾病 , 并为地球上绝大多数人提供更好的教育 。 有人则对未来有一种相当悲观的预测:大批的工作被自动化技术接管导致的人类失业;由于人工智能监视而造成的对公民的隐私和权利的侵犯;不道德的自动化武器;由不透明和不可信的计算机程序做出的未经审查的决策;种族和性别偏见被放大;大众媒体被操纵;网络犯罪增多等 。

那么 , 我们到底如何才能创造出一个真正能靠自己进行学习的人工智能系统——一个更值得信赖的系统 , 一个和人类一样 , 可以对其所面临的情况进行推理并对未来进行规划的系统呢?

以下内容经出版社授权节选自《AI 3.0:思考人类的指南》 , 标题为摘编者所取 。

原文作者丨[美]梅拉妮·米歇尔

摘编丨安也

《AI 3.0:思考人类的指南》 , [美]梅拉妮·米歇尔著 , 王飞跃、李玉珂、王晓、张慧译 , 湛庐文化丨四川科学技术出版社 , 2021年2月 。

在考虑人工智能在我们社会中的作用时 , 我们很容易把注意力集中在不利的一面 , 但是 , 要知道 , 人工智能系统已经为社会带来了巨大好处 , 并且它们有潜力发挥更大的作用 。 当下的人工智能技术对你可能一直在使用的许多服务都起到了核心作用 , 有些甚至你都没有意识到 , 如语音转录、GPS导航和出行规划、垃圾邮件过滤、语言翻译、信用卡欺诈警报、书籍和音乐推荐、计算机病毒防护以及建筑物能源利用优化等 。

如果你是摄影师、电影制作人、艺术家或音乐家 , 你可能正在使用人工智能系统来协助开展创作 , 例如用以帮助摄影师编辑照片、协助作曲家编曲的计算机程序 。 如果你是学生 , 你可能会从适合你自己学习风格的“智能教学系统”中受益 。 如果你是科学家 , 你很有可能已经使用了许多可用的人工智能工具中的一种来帮助你分析数据 。

如果你是视力存在障碍的人 , 你可能会使用智能手机的计算机视觉应用程序来阅读手写的或印刷的文字 , 例如标牌、餐馆菜单或钞票上的文字 。 如果你是听力受损人士 , 如今你可以在YouTube上看到非常精准的字幕 , 在某些情况下 , 你甚至可以在一次演讲中获得实时的语音转录 。 这些只是当前人工智能工具正在改善人们生活的几个例子 , 许多其他的人工智能技术仍处于研究阶段 , 但也正渐渐成为主流 。

在不久的将来 , 人工智能相关应用可能会在医疗保健领域得到广泛普及 。 我们将看到人工智能系统帮助医生诊断疾病并提出治疗建议、研发新的药物、监控家中老年人的健康和安全 。 科学建模和数据分析也将越来越依赖人工智能工具 , 例如 , 改善气候变化、人口增长和人口结构、生态和食品科学以及在22世纪我们的社会即将面临的其他重大问题的模型 。 对于DeepMind的联合创始人戴米斯·哈萨比斯来说 , 人工智能最重要的潜在好处是:

我们可能不得不清醒地认识到 , 由于这些问题可能太过复杂 , 即便由地球上最聪明的人来努力解决这些问题 , 单独的人类个体和科学家在有生之年都很难有足够的时间来取得足够的创新和进步……我的信念是 , 我们需要一些帮助 , 而我认为人工智能就是这一问题的解决方案 。我们都曾听说过 , 人工智能将会接手那些人类所讨厌的工作 , 如那些枯燥无聊、令人疲倦、有辱人格或者极其危险又工资低廉的工作 。 如果这种情况真的发生了 , 那将会真正有利于增加人类社会福祉 。 随后我将讨论这个问题的另一面:人工智能夺走了太多人类的工作 。 尽管还有许多工作超出了机器人目前的能力 , 但机器人已经被广泛地用于琐碎和重复的工厂任务了 , 随着人工智能的发展 , 越来越多的这类工作可能会被自动化的机器人取代 。 未来人工智能应用的具体实例包括:自动驾驶卡车和出租车 , 用于收割水果、扑灭大火、扫除地雷和清理环境等 。 除此之外 , 机器人可能会在太空探索中发挥出比目前更大的作用 。

让人工智能来接管这些工作真的能够造福社会吗?我们可以回顾一下科技的发展历史 , 来从中得到一些启发 。 以下是人类曾经从事过但在很久以前就已经实现自动化了的一些工作的示例:洗衣工、人力车夫、电梯操作员和计算员 。 大多数人会认同:在以上这些例子中 , 使用机器代替人类做这些工作 , 确实让生活变得更美好了 。 有人可能会争辩说 , 如今的人工智能只是简单地延续了人类的进步路线 , 将那些必要的但却没人想做的工作逐渐实现自动化 , 从而改善人类的生活 。

01

人工智能大权衡:

我们是该拥抱 , 还是谨慎?

吴恩达曾乐观地宣称:“人工智能是新‘电能’ 。 ”他进一步解释道:“正如100年前电能几乎改变了所有行业一样 , 今天我真的很难想到有哪个行业在未来几年内是不会被人工智能改变的 。 ”有一个很有吸引力的类比:很快人工智能就会如电能一样 , 尽管看不到 , 但对电子设备来说却非常必要 。 电能与人工智能的一个主要的区别在于 , 电能在被广泛商业化之前就已经被充分认识 , 我们非常了解电能的功用 , 而对于如今许多人工智能系统的情况 , 我们却没有足够的认识 。

文章图片

电影《机器人与弗兰克》(2012)剧照 。

这将带来所谓的人工智能大权衡(great AI trade-off) 。 我们是应该拥抱人工智能系统 , 利用其能力来改善我们的生活 , 甚至帮助拯救生命 , 并且允许这些系统被更加广泛地使用呢 , 还是考虑当下人工智能存在难以预见的错误、易受偏见影响、易被黑客攻击以及缺少透明度等特点 , 应该更谨慎地使用人工智能来制定决策?对不同的人工智能应用 , 人类需要在多大程度上参与其中?为充分信任人工智能并使其自主工作 , 我们应该对人工智能系统提出哪些要求?尽管人工智能应用的部署越来越多 , 并且以之为基础的未来应用(如自动驾驶汽车)刚诞生就得到了吹捧 , 但这些问题仍在激烈讨论中 。

皮尤研究中心(Pew Research Center)的一项研究表明:人们在这些问题上普遍缺乏共识。 2018年 , 皮尤的分析师征集了近千名相关人士的意见 , 其中包括技术先驱、创新者、研发人员、商业和政策领袖及活动家等 , 并要求他们回答如下问题:

你是否会认为 , 到2030年 , 先进的人工智能和相关技术系统很有可能会增强人类能力并为人类赋能?也就是说 , 那时 , 大多数人在大多数时候会比今天生活得更好?还是说 , 先进的人工智能和相关技术系统很有可能会削减人类的自治权和代理权 , 使得那时大多数人的状况并不会比当前更好呢?受访者分为了两派:63%的人认为2030年人工智能的进步将使人类的状况变得更好 , 而 37%的人则不这么认为 。 有人认为人工智能实际上能够消除全球贫困 , 大规模减少疾病 , 并为地球上绝大多数人提供更好的教育 。 有人则对未来有一种相当悲观的预测:大批的工作被自动化技术接管导致的人类失业;由于人工智能监视而造成的对公民的隐私和权利的侵犯;不道德的自动化武器;由不透明和不可信的计算机程序做出的未经审查的决策;种族和性别偏见被放大;大众媒体被操纵;网络犯罪增多等 。 一位受访者将未来的世界描述为:“真实 , 但与人类无关 。 ”

机器智能引发了一系列棘手的伦理道德问题 , 与人工智能和大数据伦理相关的讨论已经可以写满好几本书了 。 为了说明这些问题的复杂性 , 我将对一个在当前已经引起人们大量关注的案例展开深入探讨:人脸识别 。

02

谁来监管?人脸识别的伦理困境

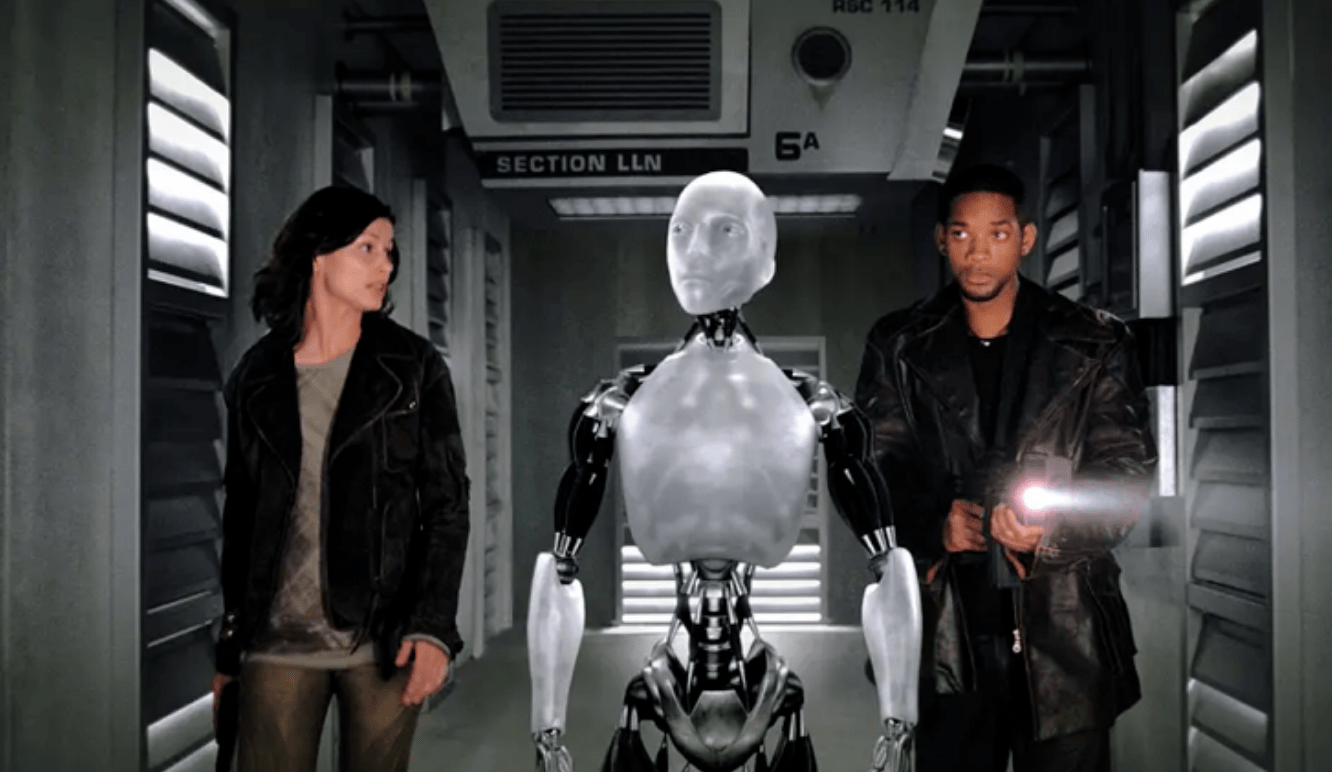

文章图片

电影《我 , 机器人》(2004)剧照 。

人脸识别是使用文字来标注图像或视频中的人脸的任务 。 例如 , Facebook将人脸识别算法应用到上传至其网站的每张照片上 , 尝试检测照片中的人脸并将其与已知的用户(至少是那些未禁用此项功能的用户)进行匹配 。 如果你在Facebook的平台上 , 并且某人发布了一张包含你的脸的照片 , 系统可能会询问你 , 是否要在照片中标记自己 。 Facebook人脸识别算法的准确性令人惊叹 , 但同时也令人害怕 。 不出所料 , 这种准确性源自对深度卷积神经网络的使用 。 该软件不仅可以对图像中位于中心位置的正脸进行人脸识别 , 而且可以对人群中的某一个人的脸进行识别 。

人脸识别技术有许多潜在的好处 , 比如 , 帮助人们从照片集中检索图像;使视力受损的用户能够识别他们所遇到的人;通过扫描照片和视频中的人脸定位失踪儿童或逃犯 , 以及检测身份盗用等 。 我们也很容易想得到会有许多人认为这种应用程序具有侵犯性或威胁性 。 例如 , 亚马逊向警方推销了它的人脸识别系统(使用了一个奇怪的听起来像是反乌托邦式的名称“Rekognition”) , 该系统可以将安保相机拍摄的视频与一个已知罪犯或嫌疑人的数据库进行比对 , 但许多人为该系统可能造成的隐私侵犯问题感到担忧 。

隐私问题是人脸识别技术应用中一个显而易见的问题 。 即便我不使用Facebook或任何其他具有人脸识别功能的社交媒体平台 , 我的照片也可能会在未经我允许的情况下被标记并随后在网上被自动识别 , 想一想提供收费人脸识别服务的FaceFirst公司 。 据《新科学家》(New Scientist)杂志报道:“Face First正在面向零售商推出一套系统 , 据称这套系统可以通过识别每次购物的高价值客户来进行促销 , 而当多次被投诉的顾客进入任何一家门店时 , 该系统就会发出警报 。 ”还有许多其他公司提供类似的服务 。

失去隐私并不是唯一的风险 , 人们对于人脸识别还有一个更大的担忧 , 那就是可靠性:人脸识别系统会犯错 。 如果你的脸被错误匹配 , 你可能会被禁止进入一家商店、 搭乘一架航班 ,或被错误地指控为一名罪犯 。

更重要的是 , 目前的人脸识别系统已经被证明对有色人种进行识别时明显比对白人的识别错误率更高 。 强烈反对使用人脸识别技术来对公民权利进行执法的美国公民自由联盟 , 用 535名国会议员的照片对亚马逊人脸识别产品Rekognition系统进行了测试(使用其默认设置) , 将这些议员的照片与因刑事指控而被捕的人员数据库进行了比较 , 他们发现 , 该系统错误地将535名国会议员中的28人与犯罪数据库中的人员匹配上了 。 在非洲裔美国人议员中 , 照片的识别错误率更是高达21%(非洲裔美国人只占美国国会议员的9%) 。

美国公民自由联盟的测试和其他研究结果显示出了人脸识别系统的不可靠性和偏见的附加后果 , 因此 , 许多高科技公司宣布他们反对将人脸识别用于执法和监管 。 举例来说 , 人脸识别公司Kairos的首席执行官布莱恩·布拉肯(Brian Brackeen)就在一篇广为流传的文章中写道:

用于对嫌疑人身份进行识别的人脸识别技术 , 对有色人种造成了负面的影响 。 这是一个不容否认的事实……我和我的公司已经开始相信 , 将商业人脸识别系统应用在任何形式的执法或政府监管中都是错误的 , 它为道德败坏者的明知故犯打开了大门……我们应该追求一个未授权政府对公民进行分类、跟踪和控制的世界 。在微软公司网站上的一篇博客文章中 , 其总裁兼首席法律顾问布拉德·史密斯(Brad Smith)呼吁国会规范人脸识别系统的使用:

人脸识别技术引发了一些与保障隐私和言论自由等基本人权有关的核心问题 , 这些问题增加了制造这些产品的科技公司的责任 。 我们认为 , 更加周密的政府监管 , 以及围绕其可接受的用途制定规范是必需的 , 而这将需要公共部门和私人机构共同采取行动 。谷歌紧随其后 , 宣布其不会通过人工智能云平台提供通用的人脸识别服务 , 直到他们能够确保这一技术的使用符合谷歌的原则和价值观 , 并能够避免滥用和有害的后果 。 这些公司的反应令人欣慰 , 但这又带来了另一个令人困扰的问题:人工智能的研究与开发应在多大程度上受到监管?又应该由谁来监管?

03

人工智能可以自我监管吗?

考虑到人工智能技术的风险 , 包括我在内的许多人工智能从业者 , 都赞成人工智能技术应该受到某种监管 , 但是监管不应该仅仅掌握在人工智能研究人员和相关公司的手里 。 围绕人工智能的问题 , 比如可信度、可解释性、偏见、易受攻击性和使用过程中出现的道德问题 , 与技术问题一样 , 都是牵涉社会和政治方面的问题 。 于是 , 围绕这些问题的讨论有必要接纳持有不同观点和具有不同背景的人们 。 简单地将监管的职责交给人工智能从业者 , 就像将其完全交给政府机构一样 , 都是不明智的 。

有一个案例可以体现制定此类法规所面临的复杂性 , 欧盟议会在2018年颁布了一项关于人工智能的法规 , 有些人称之为“解释权” 。 这项法规要求 , 在“自动决策制定”的情况下 , 任何一个影响欧盟公民的决策都需要提供其中所涉及的与逻辑有关的有意义信息 , 并且这些信息需要使用清晰明了的语言 , 以简洁、透明、易懂和易于访问的形式来沟通和传达 , 这打开了有关解释问题的闸门 。 什么叫“有意义”或“与逻辑有关”的信息?这一法规是否禁止在制定对公民有所影响的决策时使用难以解释的深度学习方法?例如在贷款和人脸识别等方面 。 这种不确定性无疑将确保政策制定者和律师在很长一段时间内仍有取酬就业的机会 。

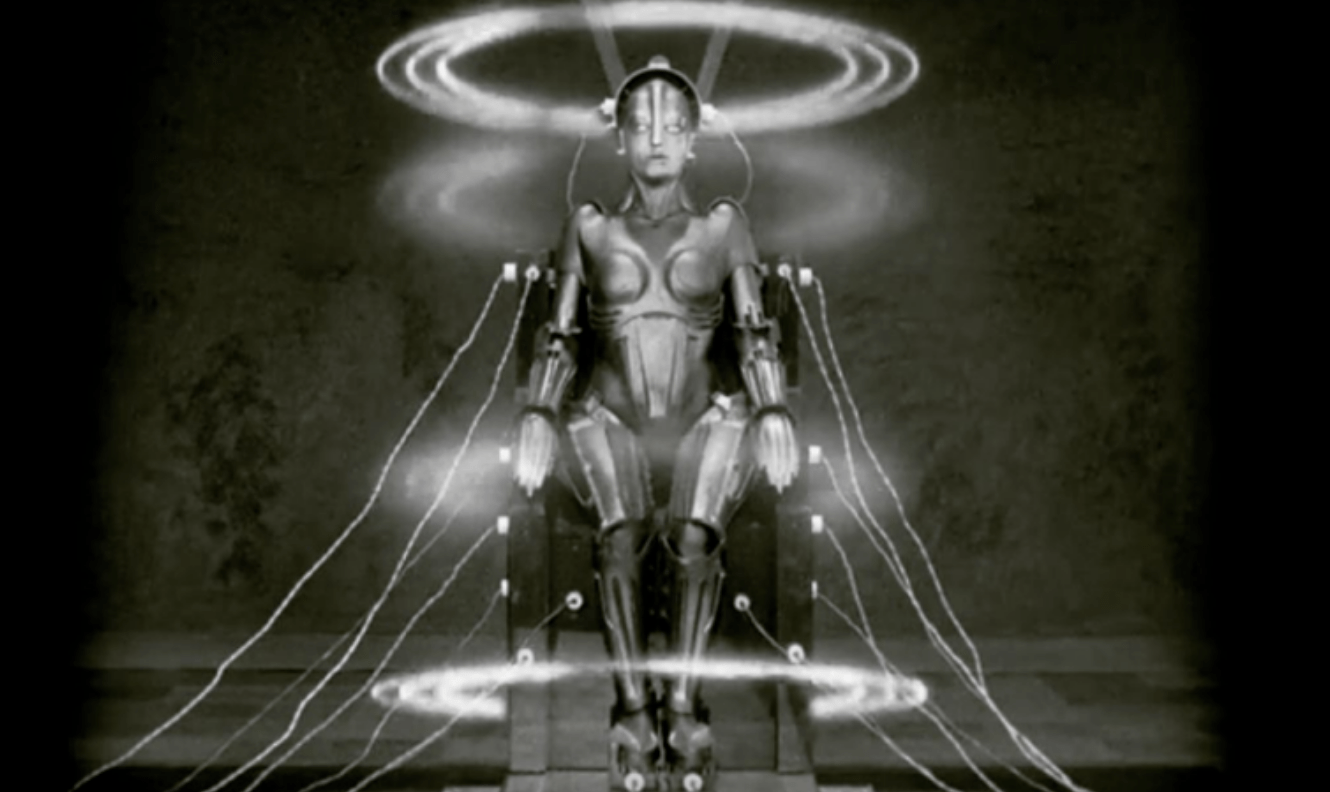

文章图片

表现主义科幻默片电影《大都会》(1927)》剧照 。

我认为对人工智能的监管应该参照其他领域的技术监管 , 尤其是那些在生物和医学领域的技术 , 例如基因工程 。 在这些领域 , 像质量保证、技术的风险和收益分析这样的监管是通过政府机构、公司、非营利性组织和大学之间的合作而产生的 。 此外 , 现在已经建立了生物伦理学和医学伦理学领域 , 这些领域对技术的研发和应用方面的决策具有相当大的影响 。 人工智能领域的研究及其应用非常需要深思熟虑的考量和一定的道德基础 。

这个基础已经开始形成 。 在美国 , 各州政府正在研究制定相关法规 , 例如用于人脸识别或自动驾驶汽车的法规 。 更重要的是 , 创建人工智能系统的大学和公司也需要进行自我监管 。

许多非营利性的智库已经出现 , 并填补了这一空缺 , 这些智库通常由担忧人工智能的富有的科技公司企业家资助 。 这些组织 , 如“人类未来研究所”(Future of Humanity Institute)、“未来生命研究所”(Future of Life Institute)和“存在风险研究中心”(Centre for the Study of Existential Risk)经常举办研讨会、赞助研究 , 以及就人工智能的安全与道德问题这一主题编著教育材料 , 并给出一些政策建议 。 一个名为“人工智能合作伙伴关系”(Partnership on AI)的伞状组织一直在努力将这类团体聚集在一起 , 打造一个讨论人工智能及其对人类和社会的影响的开放平台 。

文章图片

电影《她》(2013)剧照 。

目前存在的一个障碍是:该领域在制定监管和道德规范的优先事项方面 , 尚未达成普遍共识 。 是应该立即将重点放在能够解释人工智能系统推理过程的算法方面 , 还是关于数据的隐私方面 , 或是人工智能系统对恶意攻击的鲁棒性方面 , 又或是关于人工智能系统的偏见以及关于超级智能潜在的风险方面?我个人的观点是 , 人们对超级智能可能带来的风险给予了太多关注 , 而对于深度学习缺乏可靠性和透明性 , 及其易受攻击性的关注则远远不够 。

04

需要把处理伦理道德问题的能力 ,

赋予机器吗?

到目前为止 , 我的讨论集中于人类如何使用人工智能的道德问题 , 但是还有一个重要的问题:机器本身是否能够拥有自己的道德意识 , 并且足够完备以使它们能够独立做出道德决策而无须人类监管?如果我们要给予人脸识别系统、无人驾驶汽车、老年护理机器人甚至机器人士兵决策自主权 , 难道我们不需要把人类所拥有的处理伦理道德问题的能力赋予这些机器吗?

自从人们开始思考人工智能 , 就开始了关于“机器道德”问题的思考 。 也许 , 关于机器道德的最著名的讨论来自艾萨克·阿西莫夫(Isaac Asimov)的科幻小说 , 他在小说中提出了著名的“机器人三定律”:

第一定律:机器人不得伤害人类个体 , 或者对人类个体将遭受的危 险袖手旁观;这些定律已非常知名 , 但实际上 , 阿西莫夫提出机器人三定律的目的是证明这套 定律会不可避免地失败 。 阿西莫夫在 1942 年首次提出这些定律时讲述了一个名为 “逃跑”的故事:如果一个机器人遵循第二定律向危险物质移动 , 这时第三定律将会生效 , 机器人随即远离该物质;此时第二定律又重新开始生效 。 于是 , 机器人将被困 在一个无尽的循环中 , 最终对机器人的人类主人造成了灾难性的后果 。 阿西莫夫的故 事通常集中讨论把伦理规则编程置入机器人后可能引发的意外后果 。 阿西莫夫是有先 见之明的:正如我们所看到的 , 不完整的规则和意外所引发的问题已经妨碍了所有基 于规则的人工智能方法 , 道德推理也不例外 。

第二定律:机器人必须服从人类给予它的命令 , 当该命令与第一定 律冲突时例外; 第三定律:机器人在不违反第一、第二定律的情况下 , 要尽可能地 保护自己 。

科幻小说家亚瑟·克拉克(Arthur C. Clarke)在其 1968 年出版的《2001:太空漫游》中描写了一个类似的情节 。 人工智能计算机 HAL 被编程为始终对人类保持诚实 , 但同时又要对人类宇航员隐瞒他们的太空任务的真实目的 。 与阿西莫夫的笨拙的机器人不同 , HAL饱受这种认知失调的心理痛苦的折磨:“他意识到隐瞒真相与保持忠诚之间的这种冲突正在慢慢地破坏他的心智 。 ”结果是 , 这种计算机“神经症”使 HAL变成了一名杀手 。

文章图片

电影《2001:太空漫游》(1968)剧照 。

影射到现实生活中的机器道德 , 数学家诺伯特·维纳早在1960年就指出:“我们最好非常确信 , 给机器置入的目标正是我们真正想要的目标 。 ”维纳的评论捕捉到了人工智能中所谓的价值一致性问题:人工智能程序员面临的挑战是 , 如何确保人工智能系统的价值观与人类保持一致 。 可是 , 人类的价值观又是什么?假设存在社会共享的普世价值有任何意义吗?

欢迎来到道德哲学的101课, 我们将从每个道德哲学系学生最喜欢的思想实验——电车难题开始 。 假设你正在沿着一组轨道驾驶一辆加速行驶的有轨电车 , 就在正前方 , 你看到有5名工人站在轨道中间 , 你踩刹车却发现它们不起作用 。 幸运的是 , 有一条通向右边的轨道支线 , 你可以把电车开到支线上 , 以免撞到那5名工人 , 但不幸的是 , 在支线轨道中间也站着1名工人 。 这时候 , 你面临一个两难的选择:如果你什么都不做 , 电车就会直接撞到5名工人身上;如果你把电车开向右边 , 电车就会撞死1名工人 。 从道德上讲 , 你应该怎么做?

电车难题一直是20世纪大学道德课的一节主要内容 。 多数人认为 , 从道德上来说更可取的做法是:司机把电车开到支线上 , 杀死1名工人 , 救下另外5名工人 。

后来 , 哲学家们发现:对本质上相同的困境选取一个不同的框架 , 就会导致人们给出相反的答案 。 事实证明 , 人类在关于道德困境的推理中 , 对困境的呈现方式是非常敏感的 。 最近 , 电车难题又作为媒体对自动驾驶汽车的报道的一部分而出现了 。 如何对一辆自动驾驶汽车进行编程使其能够处理这些问题 , 已经成为人工智能伦理讨论的一个中心议题 。 许多人工智能伦理思想家指出:电车问题本身 , 即驾驶员只有两个可怕的选择 , 是一个高度人为设计的场景 , 而在现实世界中 , 驾驶员永远不会遇到这样的场景;但是 , 电车问题已经成为我们应该如何为自动驾驶汽车编程 , 以让它们自己做出符合道德的决策这一问题的象征 。

文章图片

电影《巨人:福宾计划》(1976)剧照 。

2016年 , 3位研究人员在数百人中进行了调研 , 给定类似电车问题的自动驾驶汽车可能面临的场景 , 并询问他们对不同行为的道德观念 。 最终 , 76%的参与者回答 , 自动驾驶汽车牺牲1名乘客比杀死10名行人 , 从道德上来说更可取 。 可是 , 当被问及是否会购买这样一辆被编程为会为了救下更多行人而选择牺牲其乘客的汽车时 , 绝大多数参与调查者的回答是否定的 。

研究人员称:“我们发现在6项亚马逊土耳其机器人参与的研究中 , 参与者认同这种效益主义的自动驾驶汽车 , 即牺牲乘客以获取更大利益的自动驾驶汽车 , 并希望其他人会购买它们 , 但他们自己更愿意乘坐那些不惜一切代价保护乘客的自动驾驶汽车 。 ”心理学家乔书亚·格林(Joshua Greene)在他对这项研究的评论中指出:“在将我们的价值观置入机器之前 , 我们必须弄清楚如何让我们的价值观清晰且一致 。 ”这似乎比我们想象的要更难 。

一些人工智能伦理研究人员建议我们放弃直接对机器的道德规则进行编程的尝试 , 让机器通过观察人类的行为自行学习符合道德的价值观;然而 , 这种自学方法也存在我在上一章中所介绍的机器学习会面临的所有问题 。

在我看来 , 在赋予计算机“道德智能”方面的进展不能与其他类型智能的进展分开 , 真正的挑战是创造出能够真正理解它们所面临的场景的机器 。 正如阿西莫夫的故事所阐明的:除非机器人能够理解不同场景下伤害的内涵 , 否则它无法可靠地执行避免伤害人类的命令 。 对道德进行推理要求人们认识到原因和结果的关系 , 想象可能的不同未来 , 了解其他人的信念和目标 , 并预测一个人处在各种情况下会采取的各种行动的可能结果 。 换句话说 , 可信任的道德理性的一个先决条件是通用的常识 , 而这 , 正如我们所见 , 即使在当今最好的人工智能系统中也是缺失的 。

到目前为止 , 我们已经看到 , 在庞大的数据集上训练的DNN如何在特定任务上与人类的视觉能力相媲美;我们也看到了这些网络的一些弱点 , 包括它们对大量人类标记数据的依赖 , 以及它们以非人类的方式失败的倾向 。 我们如何才能创造出一个真正能靠自己进行学习的人工智能系统——一个更值得信赖的系统 , 一个和人类一样 , 可以对其所面临的情况进行推理并对未来进行规划的系统?

作者|[美]梅拉妮·米歇尔

摘编|安也

编辑|西西

【梅拉妮·米歇尔|刷脸泛滥,人工智能需要处理伦理道德问题的能力吗?】导语部分校对|刘军

推荐阅读

- 珍妮弗·马瑟|假如明天人类突然消失,哪些动物能进化替代?

- 墨水|美媒揭秘:法国王后玛丽·安托瓦妮特的密信

- 赵爽妮|金川县开展纪念“一二.九”爱国学生运动歌咏比赛

- 人物|比尔·盖茨分享大女儿詹妮弗与纳耶尔·纳萨尔婚礼上的照片

- 保冬妮|《小小科学家》系列绘本输出英语版

- 人物|流行天后布兰妮回应删Instagram账号:别担心 只是休息下庆祝自己订婚

- realme|小米十周年,上有苹果,下有realme

- Apple|据报道苹果公司正在竞标由詹妮弗·劳伦斯担任好莱坞经纪人的电影

- 妮卡|为什么盯着一个字看久了就不认识它了?

- 莫妮卡|传索尼6月底举办体验会 多款新作公布,首次一窥PSVR2