MLP-Mixer|44种模型、1200种子网,RobustART评测CNN、Transformer、MLP-Mixer谁最鲁棒?( 四 )

文章图片

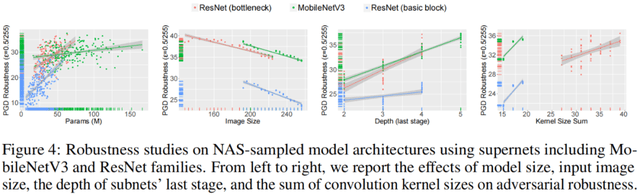

可以看出模型大小、卷积核大小、模型最后一个 stage 的深度对于对抗鲁棒性有着正向的影响 , 而输入图片的大小则对对抗鲁棒性有负面的影响 。

3.2 训练技巧对于鲁棒性的影响

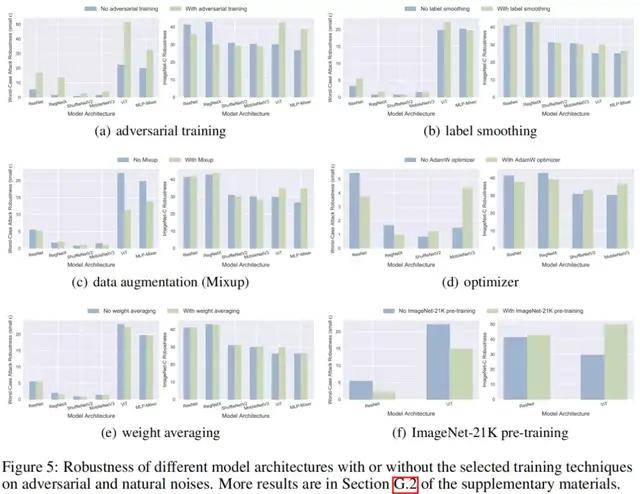

该研究针对 10 余种特定的训练技巧 , 选取部分模型来评估有 / 无这些技巧对于模型的鲁棒性影响 , 部分结果如下图所示:

文章图片

从实验结果可以得出较多有意义的结论 , 如:

- 对抗训练:对于 CNNs , 对抗训练提升了模型的对抗鲁棒性 , 然而降低了 Clean 数据集上的泛化性以及对于自然噪音和系统噪音的鲁棒性;该研究还首次发现了对于 ViTs 和 MLP-Mixer , 对抗训练显著提升了 Clean 数据集上的泛化性以及对于所有三种噪音的鲁棒性 , 这对于对抗训练在真实场景中的实际应用有重大意义 。

- ImageNet-21K 预训练:该技巧提升了模型对于自然噪音的鲁棒性 , 却降低了对于对抗噪音和系统噪音的鲁棒性 。

- 数据增强:该技巧降低了模型在对抗噪音上的鲁棒性 , 并在大多数情况下提升了模型对于自然噪音的鲁棒性 。

- AdamW 优化器:相比于基础的 SGD 优化器 , 该技巧略微降低了 ResNet、RegNetX 等大型模型的鲁棒性 , 却明显提升了 MobileNetV3 和 ShuffleNetV2 等轻量化模型在 Clean 数据集上的泛化性以及对于所有三种噪音的鲁棒性 。

推荐阅读

- 模型|2022前展望大模型的未来,周志华、唐杰、杨红霞这些大咖怎么看?

- 模型|经逆向工程,Transformer「翻译」成数学框架 | 25位学者撰文

- 化纤|JXK STUDIO 虎年肥猫 1/6仿真动物模型手办可爱摆件

- 模型|达摩院2022十大科技趋势发布:人工智能将催生科研新范式

- 模型|李彦宏:中国迎来AI黄金十年,集度汽车机器人明年亮相,智能交通10年内解决拥堵

- 模型|神经辐射场去掉「神经」,训练速度提升100多倍,3D效果质量不减

- 模型|英伟达:美团机器学习平台使用NVIDIA T4 GPU

- 错误|有了这个工具,不执行代码就可以找PyTorch模型错误

- the|美国大学模型预测:全美未来两月或激增1.4亿确诊

- Samsung|三星Galaxy S22系列模型照片出现 S Pen颜色确认