文章图片

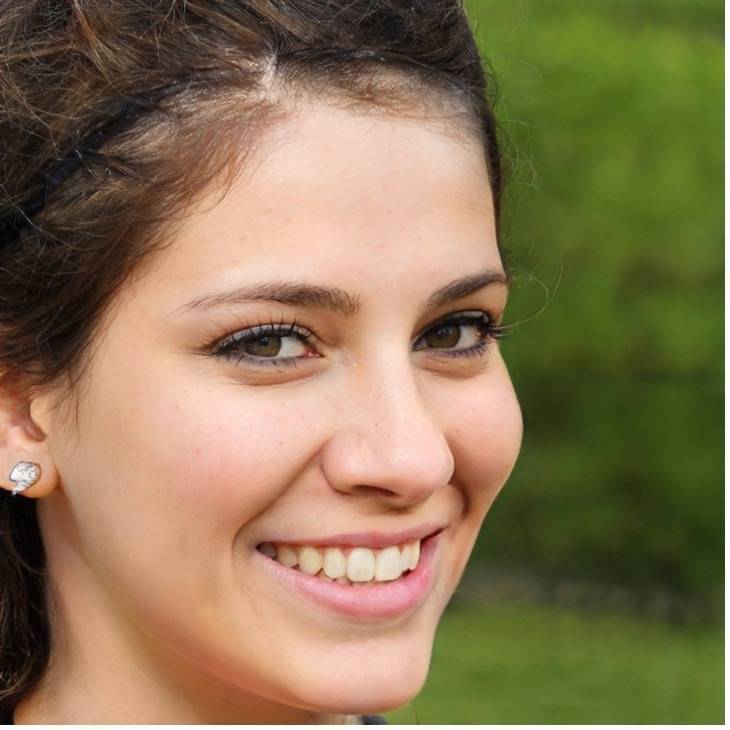

看到这张照片 , 你是否觉得这就是一张真实的人脸照片?

事实上 , 这是一个名为“此人不存在”的网站生成的合成人脸照片(this-person-does-not-exist.com) 。

“我们对AI合成人脸照片真实感的评估表明 , 合成引擎已经走过了‘恐怖谷’ , 能够创造出跟真实人脸难以区分且更受人信赖的人脸 。 ”2月14日 , 一篇发表在《美国国家科学院院刊》(PNAS)的论文在摘要中表示 。

“恐怖谷效应”于1970年由森昌弘提出 , 是一个关于人类对机器人和非人类物体感觉的假设 。

“恐怖谷效应”称 , 由于机器人与人类在外表、动作上相似 , 所以人类亦会对机器人产生正面的情感;而当机器人与人类的相似程度达到一个特定程度的时候 , 人类对他们的反应便会突然变得极其负面和反感 , 哪怕机器人与人类只有一点点的差别 , 都会显得非常显眼刺目 , 从而觉得整个机器人非常僵硬恐怖 。 在合成人脸照片的情景中 , “恐怖谷”效应往往来自于合成人眼中空洞的表情所引发的不安感 。

文章图片

而一旦机器人和人类的相似度继续上升 , 相当于普通人之间的相似度时 , 人类对其的情感反应会再度回到正面 , 产生人类与人类之间的移情 。

【人脸|走出恐怖谷:AI已能合成难辨真假的人脸照片,还更被信任】

文章图片

越来越令人信服的图像正在将观者拉出“恐怖谷” , 进入由Deepfake(深度伪造)构建的欺骗世界 。 在加州大学伯克利分校教授Hany Farid和兰开斯特大学博士生Sophie Nightingale的《AI合成的人脸与真实人脸没有区别且更被信赖》研究中 , 参与实验的人被要求区分神经网络StyleGAN2合成人脸和真实人脸 , 以及这些人脸唤起的信任程度 。

这项研究由三个实验构成 。 在第一个实验中 , 315名参与者从128张面孔(从一组800张面孔中提取)分类为真实面孔或合成面孔 , 准确率为48% 。

在第二个实验中 , 219名新参与者被培训如何识别真实人脸与合成人脸 , 然后与第一个实验一样对128张人脸进行分类 。 尽管进行了训练 , 最后准确率也只是提高到了59% 。

继而 , 研究人员决定探索可信度的感知是否可以帮助人们识别人造图像 , “人脸提供了丰富的信息来源 , 只需几毫秒的时间就足以对个人特征(例如可信度)进行隐含推断 。 我们想知道合成面孔是否会激活相同的可信度判断 , 如果不是 , 那么对可信度的感知可能有助于区分真实面孔和合成面孔 。 ”

第三项实验 , 223名参与者对128张面孔的可信度进行评分 , 这些面孔取自同一组800张面孔 , 评分范围为1(非常不可信)到7(非常可信) 。 最后 , 合成面孔的平均评分比真实面孔的平均评分高7.7% , 具有统计学意义 。

整个实验结果表明 , 合成的人脸照片与真实人脸几乎无法区分 , 甚至被认为更值得信赖 。 这样的结果也在研究者的意料之外 , Nightingale表示 , “我们最初认为合成面孔不如真实面孔可信 。 ”

这个生成人脸照片的StyleGAN是Nvidia于2018年开发的一种神经网络 。 GAN由2个相互竞争的神经网络组成 , 其中一个称为生成器 , 不断生成一些东西 , 另一个称为鉴别器 , 不断尝试确定结果是真实的还是由第一个生成的 。 生成器以随机像素开始练习 。 随着鉴别器的反馈 , 它逐渐产生了越来越逼真的人脸 。 最终 , 鉴别器无法区分真脸和假脸 , 训练就结束了 。

创建不存在的人脸照片实际上是GAN的一个副产品 , 其原本的主要目标是训练人工智能识别假脸和一般人脸 , Nvidia需要通过自动识别人脸并对其应用其他渲染算法来提高其显卡性能 。 然而 , 由于StyleGAN代码是公开的 , Uber的一名工程师就利用它创建了一个随机人脸生成器 。

对于Deepfake(深度伪造)技术的恶意使用已经在现实中有了诸多体现 , 比如美国大选中的虚假宣传活动 , 为勒索而创造的虚假色情内容等等 。 自Deepfake技术出现以来 , 鉴别出深度伪造和进一步欺骗鉴别之间已经变成了一场“军备竞赛” 。

现在这项对Deepfake进展的研究使人更加担心其被滥用 , “任何人都可以在没有Photoshop或 CGI专业知识的情况下创建合成内容 , ”Nightingale表示 。

美国南加州大学视觉智能和多媒体分析实验室主任Wael Abd-Almageed在接受《科学美国人》采访时表示 , “另一个担忧是 , 这些发现会让人觉得深度伪造将变得完全无法检测到 , 科学家们可能会放弃尝试开发针对深度伪造的对策 。 ”

两位研究者也提出了应对措施 , 如将强大的水印合并到图像和视频合成网络中 , 这将为可靠识别提供有效机制 。

论文中写道 , 也许最有害的是 , 在任何图像和视频都可以伪造的数字世界中 , 任何不受欢迎的记录的真实性都可能受到质疑 。 “所以 , 我们鼓励推进技术发展的人们考虑风险是否大于收益 , 而不仅仅从技术角度考虑其是否可能实现 。 ”

推荐阅读

- 虚拟|bilibili 直播新规:上线开播前要进行人脸认证

- the|美国得州起诉Meta人脸识别侵犯隐私 寻求数千亿美元罚款

- 安全|俄罗斯法院周四以恐怖主义罪判处三名西伯利亚青少年有期徒刑和缓刑

- 新浪科技|瑞幸走出“生死局”,借谷爱凌重塑形象? | 冬奥·品牌

- 视点·观察|瑞幸走出“生死局”,借谷爱凌重塑形象?

- Intel|PC Gamer致信Intel:你是我们走出显卡危机的唯一出路

- 身份|使用人脸替换等深度合成服务 拟需进行真实身份信息认证

- 人脸|国家网信办:拟规定人脸替换等深度合成内容应显著标识

- 界面新闻|国家网信办拟规定:人脸生成、人脸替换等深度合成信息内容须进行显著标识

- 北京青年报|直播带货亟须 走出“顶流迷信”