整理 | 祝涛

出品 | CSDN(ID:CSDNnews)

12月16日上午消息 , 苹果公司在其网站上更新了其儿童安全功能的相关信息 , 删除了所有关于8月宣布的儿童性虐待材料(CSAM)检测功能 。 不过 , 尽管网站描述发生了变化 , 但该公司表示 , 这项功能的计划仍在进行中 。

文章图片

舆论压力下推迟

今年8月 , 苹果公司宣布一系列儿童保护政策:

- 第一个功能是iCloud Photos CSAM检测功能:这个功能允许检测用户iCloud上的照片是否涉及儿童性虐待并将其报告给苹果审核员 , 审核员可以将报告转交给执法部门 。

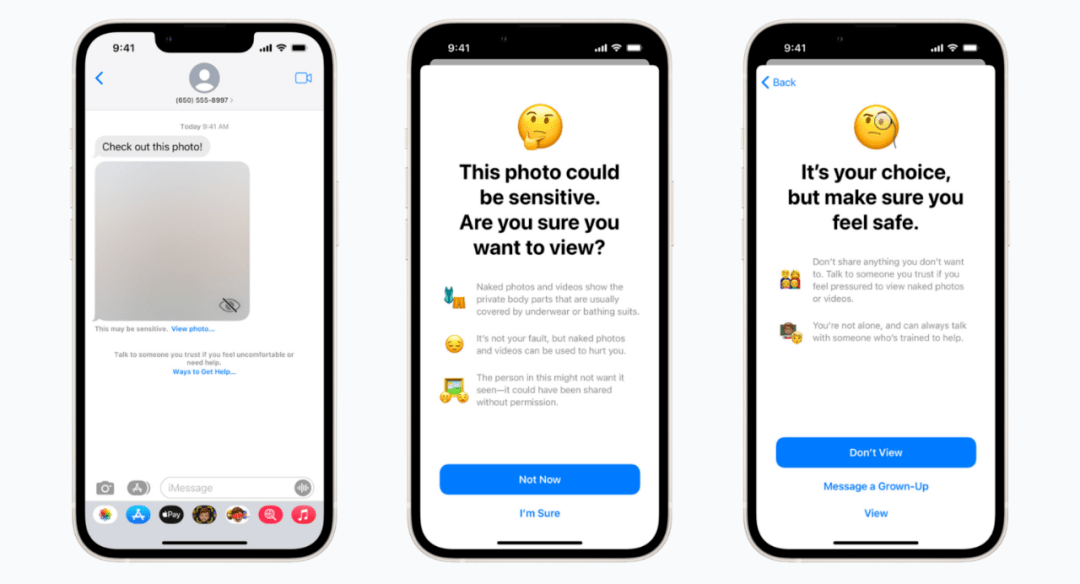

- 第二个功能是信息通信安全功能:当孩子收到色情图片时 , 图片会作模糊化处理 , 当检测到他们要查看的图像涉及CSAM时 , 会发出警告消息提醒孩子和家长 。

- 第三个功能是Siri和搜索干预功能:通过提供额外资源来帮助儿童和父母保持网上安全 , 如果在不安全时候可通过Siri和搜索获得帮助指导 。 例如 , 询问Siri如何报告儿童性虐待内容或剥削童工 , 以及发现这些情况后如何向有关部门汇报 。

面对世界各地90多个政策和权利团体的抗议 , 今年9月 , 苹果不得不叫停了CSAM计划 。 该公司在其儿童安全网页上的一份声明中表示:“此前 , 我们宣布了一些新增功能的计划 , 旨在保护儿童免受侵害 , 并限制儿童性侵内容的传播 。 根据用户、宣传团体、研究人员和其他人的反馈 , 我们决定在未来几个月花额外的时间收集意见 , 并在这些儿童安全功能正式上线之前做出改进 。 ”

只是推迟 , 不会放弃

MacRumors发现 , 大约在12月10日至12月13日之间 , 相关方案的资料已从苹果官网上移除 。 不过 , 尽管网站上的资料发生了变化 , 但该公司表示 , 这项功能的计划并没有改变 , 只是暂时性的推迟 。

CSAM检测功能还没有具体的发布日期 , 其他儿童保护功能都已发布 , 几天前 , 苹果推出iOS15.2 , 正式启用了儿童安全保护措施「信息通信安全功能」 , 用来自动判断接收或发送是否为色情图片 。 苹果表示这项功能主要是利用机器学习技术来分析照片 , 确认iMessages接收或发送照片是否包含色情图片 , 所有分析全部都在装置内进行 , 苹果无法得知 , 该功能将率先在美国地区推出 。

推荐阅读

- 解决方案|【干货】反渗透设备结垢原因及解决方案

- 解决方案|三菱重工AirFlex:全屋恒温,暖意守护安全工作

- 解决方案|蓝思科技:两智能制造项目入选工信部示范工厂揭榜单位和优秀解决方案榜单

- 上海|上海供水热线与城投水务官网合并上线,一站式服务更便民

- 产品|国内首家提供EMI解决方案及产品供应商签约,提供EMI IC、PMIC等产品

- 解决方案|德国又一州“去微软化”失败,将继续使用 Microsoft Teams

- 误删除|日本惠普公司闯大祸,京都大学超算系统 77TB 重要数据被误删

- Apple|韩国要求苹果和Google删除"玩游戏赚钱"的游戏类别

- 流程|HMS Core电商与游戏行业解决方案,全流程赋能开发者创新

- 方案|百度:到2030年将推动交通减碳7000万吨