选自arXiv

作者:Andrea Banino等

机器之心编译

编辑:陈萍、杜伟

来自 DeepMind 的研究者提出了用于强化学习的 CoBERL 智能体 , 它结合了新的对比损失以及混合 LSTM-transformer 架构 , 可以提高处理数据效率 。 实验表明 , CoBERL 在整个 Atari 套件、一组控制任务和具有挑战性的 3D 环境中可以不断提高性能 。近些年 , 多智能体强化学习取得了突破性进展 , 例如 DeepMind 开发的 AlphaStar 在星际争霸 II 中击败了职业星际玩家 , 超过了 99.8% 的人类玩家;OpenAI Five 在 DOTA2 中多次击败世界冠军队伍 , 是首个在电子竞技比赛中击败冠军的人工智能系统 。 然而 , 许多强化学习(RL)智能体需要大量的实验才能解决任务 。

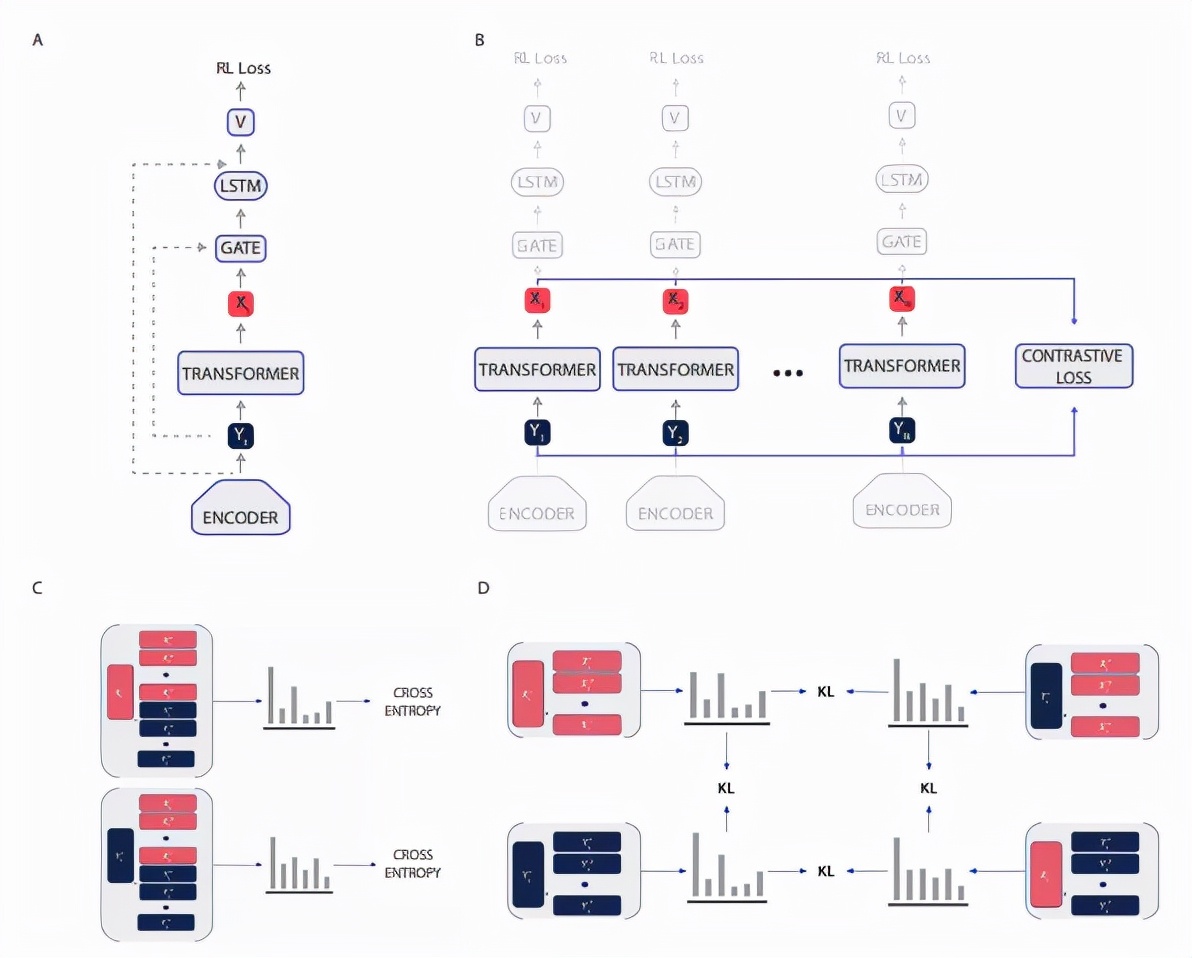

最近 , DeepMind 的研究者提出了 CoBERL(Contrastive BERT for RL)智能体 , 它结合了新的对比损失和混合 LSTM-transformer 架构 , 以提高处理数据效率 。 CoBERL 使得从更广泛领域使用像素级信息进行高效、稳健学习成为可能 。

具体地 , 研究者使用双向掩码预测 , 并且结合最近的对比方法泛化 , 来学习 RL 中 transformer 更好的表征 , 而这一过程不需要手动进行数据扩充 。 实验表明 , CoBERL 在整个 Atari 套件、一组控制任务和具有挑战性的 3D 环境中可以不断提高性能 。

文章图片

论文地址:https://arxiv.org/pdf/2107.05431.pdf

【架构|综合LSTM、transformer优势,DeepMind强化学习智能体提高数据效率】方法介绍

为了解决深度强化学习中的数据效率问题 , 研究者对目前的研究提出了两种修改:

- 首先提出了一种新的表征学习目标 , 旨在通过增强掩码输入预测中的自注意力一致性来学习更好的表征;

- 其次提出了一种架构改进 , 该架构可以结合 LSTM 以及 transformer 的优势 。

文章图片

CoBERL 整体架构图 。

表征学习

研究者将 BERT 与对比学习结合起来 。 基于 BERT 方法 , 该研究将 transformer 的双向处理机制与掩码预测设置相结合 。 双向处理机制一方面允许智能体根据时间环境来了解特定状态的上下文 。 另一方面 , 位于掩码位置处的预测输入通过降低预测后续时间步长的概率来缓解相关输入问题 。

研究者还使用了对比学习 , 虽然许多对比损失(例如 SimCLR)依赖于数据扩充来创建可以进行比较的数据分组 , 但该研究不需要利用这些手工数据扩充来构造代理任务 。

相反地 , 该研究依赖输入数据的顺序性质来创建对比学习所需的相似和不同点的必要分组 , 不需要仅依赖图像观测的数据增强(如裁剪和像素变化) 。 对于对比损失 , 研究者使用了 RELIC , 该损失同样适应于时间域;他们通过对齐 GTrXL transformer 输入和输出创建数据分组 , 并且使用 RELIC 作为 KL 正则化改进所用方法的性能 , 例如 SimCLR 在图像分类领域以及 Atari 在 RL 领域性能都得到提高 。

推荐阅读

- 选型|数据架构选型必读:2021上半年数据库产品技术解析

- Tencent|原生版微信上架统信UOS应用商店:适配X86、ARM、LoongArch架构

- 飞腾|原生版微信登陆统信UOS应用商店,已适配X86/ARM/LoongArch架构

- 趋势|[转]从“智能湖仓”升级看数据平台架构未来方向

- 架构|ROG 预热新款魔霸游戏本,依旧采用大下巴设计

- 综合|千村万乡驭风:国家电投上海能科小(微)风机破局分散式风电

- 综合|佳都科技:获“CPSE安博会头部企业”等5项大奖

- 技术|2025年数字商业的AI综合渗透率约至30%,影谱科技位列数字商业内容首位

- 监测|我国再添一枚资源监测利器

- 综合|自贡室外巡逻机器人