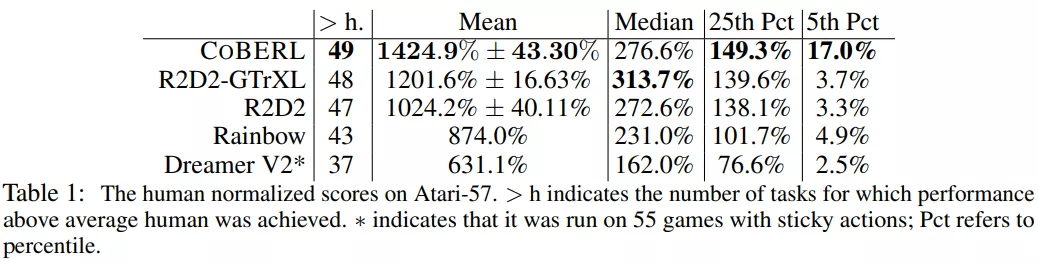

架构|综合LSTM、transformer优势,DeepMind强化学习智能体提高数据效率( 三 )

文章图片

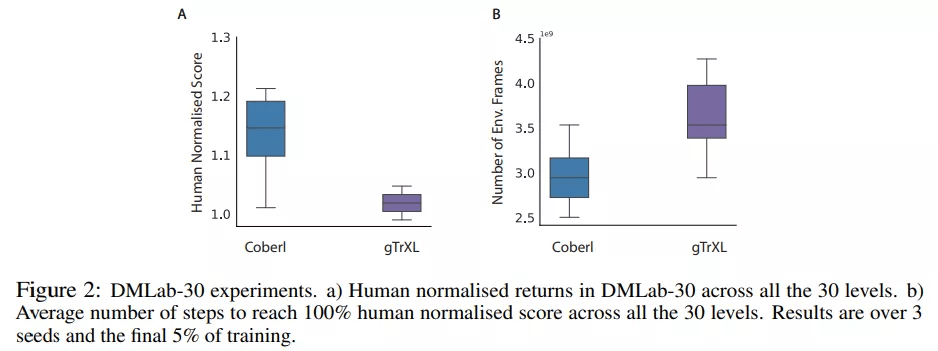

为了在具有挑战性的 3D 环境中测试 CoBERL , 该研究在 DmLab30 中运行 , 如下图 2 所示:

文章图片

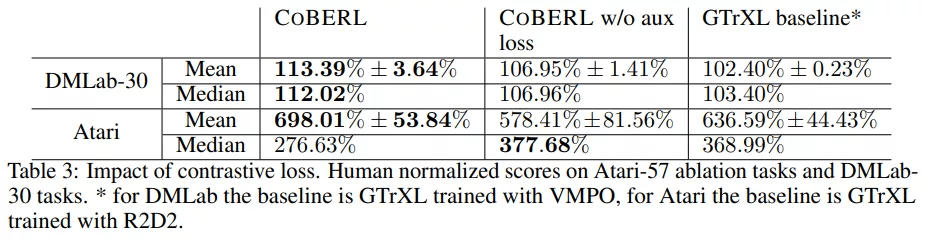

下表 3 的结果表明与没有对比损失的 CoBERL 相比 , 对比损失可以显著提高 Atari 和 DMLab-30 的性能 。 此外 , 在 DmLab-30 这样具有挑战性的环境中 , 没有额外损失的 CoBERL 仍然优于基线方法 。

文章图片

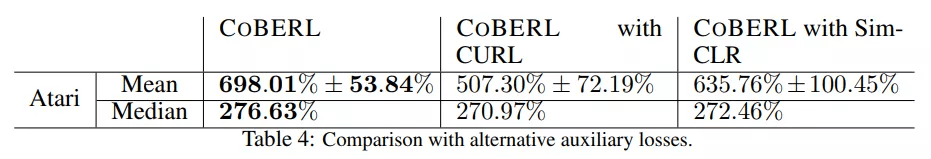

下表 4 为该研究提出的对比损失与 SimCLR、CURL 之间的比较:结果表明该对比损失虽然比 SimCLR、CURL 简单 , 但性能更好 。

文章图片

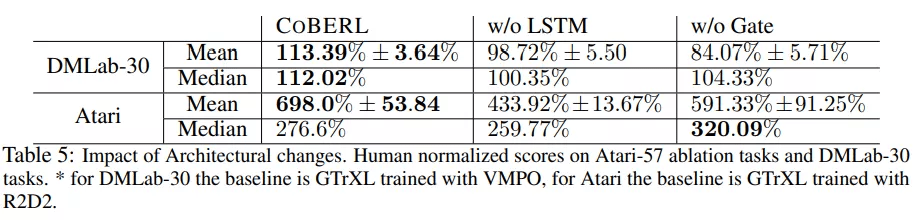

下表 5 为从 CoBERL 中删除 LSTM 的效果(如 w/o LSTM 一列) , 以及移除门控及其相关的跳跃连接(如 w/o Gate 一列) 。 在这两种情况下 CoBERL 的性能都要差很多 , 这表明 CoBERL 需要这两个组件(LSTM 和 Gate) 。

文章图片

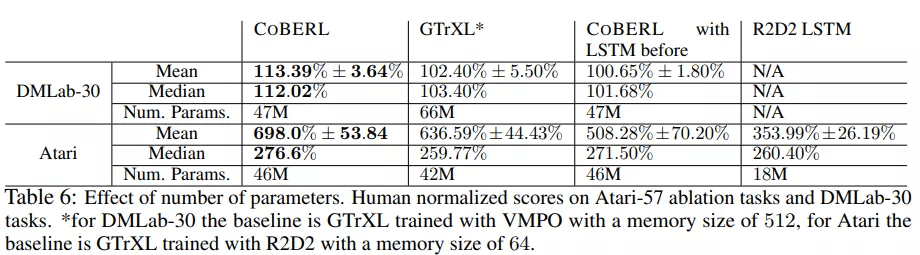

下表 6 根据参数的数量对模型进行了比较 。 对于 Atari , CoBERL 在 R2D2(GTrXL) 基线上添加的参数数量有限;然而 , CoBERL 仍然在性能上产生了显着的提升 。 该研究还试图将 LSTM 移到 transformer 模块之前 , 在这种情况下 , 对比损失表征取自 LSTM 之前 。

文章图片

推荐阅读

- 选型|数据架构选型必读:2021上半年数据库产品技术解析

- Tencent|原生版微信上架统信UOS应用商店:适配X86、ARM、LoongArch架构

- 飞腾|原生版微信登陆统信UOS应用商店,已适配X86/ARM/LoongArch架构

- 趋势|[转]从“智能湖仓”升级看数据平台架构未来方向

- 架构|ROG 预热新款魔霸游戏本,依旧采用大下巴设计

- 综合|千村万乡驭风:国家电投上海能科小(微)风机破局分散式风电

- 综合|佳都科技:获“CPSE安博会头部企业”等5项大奖

- 技术|2025年数字商业的AI综合渗透率约至30%,影谱科技位列数字商业内容首位

- 监测|我国再添一枚资源监测利器

- 综合|自贡室外巡逻机器人