机器之心专栏

作者:吴礼蔚、程善伯

来自火山翻译团队的研究者通过研究发现 , 不同语言标签对多语言 Zero-shot 翻译的巨大影响 , 并在数据相差很大的三个不同的数据集上进行了实验 , 验证了不同语言标签对多语言 Zero-shot 翻译确实存在巨大影响 , 并且表明 T-ENC 在 Zero-shot 上优于其他语言标签 。现今的多语言翻译模型 , 大多是在一个以英语为中心的数据集上训练一个统一的模型 , 并通过添加语言标签的方式来告诉模型应该翻译到哪一种语言 。 这种模型在预测的时候能够直接在一个非英语的句子上添加另一个非英语的语言标签来直接翻译 , 从而达到即使在训练时没有见过源语言和目标语言的情况下 , 也能实现模型翻译 , 这就是所谓的 zero-shot 多语言翻译 。

添加语言标签的方式有很多种 , 来自火山翻译团队的研究者通过实验研究发现 , 虽然不同的语言标签对监督方向的效果几乎没有影响 , 但是对 zero-shot 的效果却有着非常大的影响 。 这个现象在多个数据集上得到了验证 , 其中 IWSLT17 上相差 14.02 个 BLEU , Euporal 上相差 24.24 个 BLEU , TED talks 上相差 8.78 个 BLEU 。 目前该研究已被 the findings of ACL 2021 接收 。

文章图片

论文地址:https://arxiv.org/abs/2106.07930

研究背景和动机

在多语言翻译中 , 有许多添加语言标签的方法 , 并且一般都认为不同的语言标签的添加方法对模型的性能没有影响 , 然而之前没有研究者系统性地研究语言标签对翻译模型是否有影响 。 这篇文章比较了四种常见的语言标签的添加方法 。

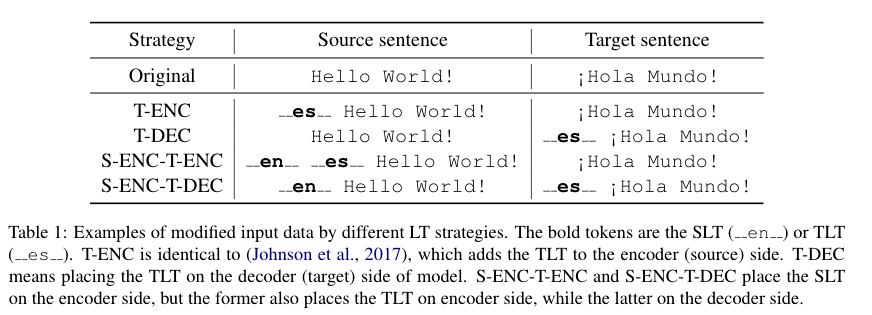

表 1 四种不同的的语言标签

文章图片

如表 1 所示 , 这四种方法会将源语言标签和目标语言标签按照不同的方法加到源句首或者目标句首 。

表 2 数据集详情

文章图片

如表 2 所示 , 这篇文章选择了 IWSLT17 , Euporal 和 TED talks 三个数据集 , 这三个数据集在语言数量和数据集大小上都有比较大的差异 。 这篇文章在这三个数据集上基于上述四种不同的语言标签训练了配置完全一样的多语言翻译模型 。

实验结果

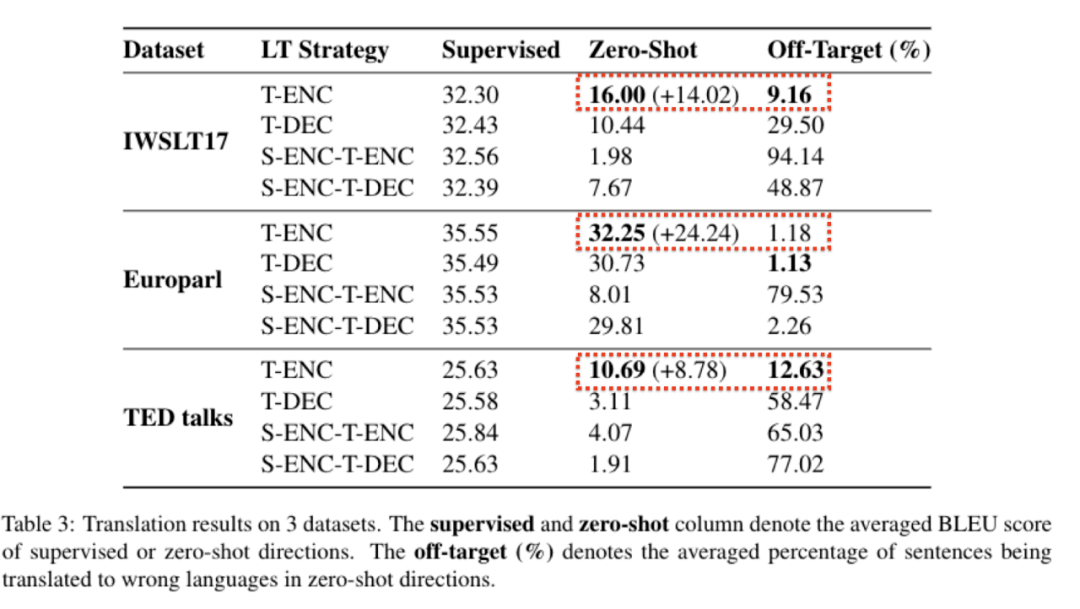

【Encoder|0语料下,如何通过「贴标签」获得更好的多语言翻译效果】表 3 实验结果

文章图片

如表 3 所示 , 可以看到:

1. 对于不同的语言标签 , 不同的数据集 , 在有监督的方向上 , 模型的表现基本一致 。

2. 在 Zero-shot 方向上:

a. 不同的语言标签对模型的性能有着很大的影响 , 并且 , T-ENC 的表现在三种数据集上一致地超过了其他三种标签:在 IWSLT17 上超过了 14.02 个 BLEU , 在 Euporal 上超过了 24.24 个 BLEU , 在 TED talks 上超过了 8.78 个 BLEU 。

b. 不同语言标签导致的 off-target 的比例也不相同(off-target 是指翻译到语言 X 时 , 却翻译成另一个语言的情况) , 基本上 T-ENC 的 off-target 的比例都要比别的小 , 这一点和模型在 zero-shot 上的性能基本一致 。

分析

那么是什么原因导致了这种现象?这篇文章试图从三个方面解释这个现象并在 TED 数据集上做了实验:

1. 在目标语言相同的情况下 , 语言标签的添加方式是否影响了不同语言的句子经过 Encoder 之后的表示的一致性?

2. T-ENC 可以获得相对于其他方法更小的 off-target 比例 , 是不是由于在预测的时候 , 它的 attention 注意力机制能够更好地注意到语言标签?

3. 意思相同的不同语言的句子 , 在翻译模型的每一层的相似性如何?

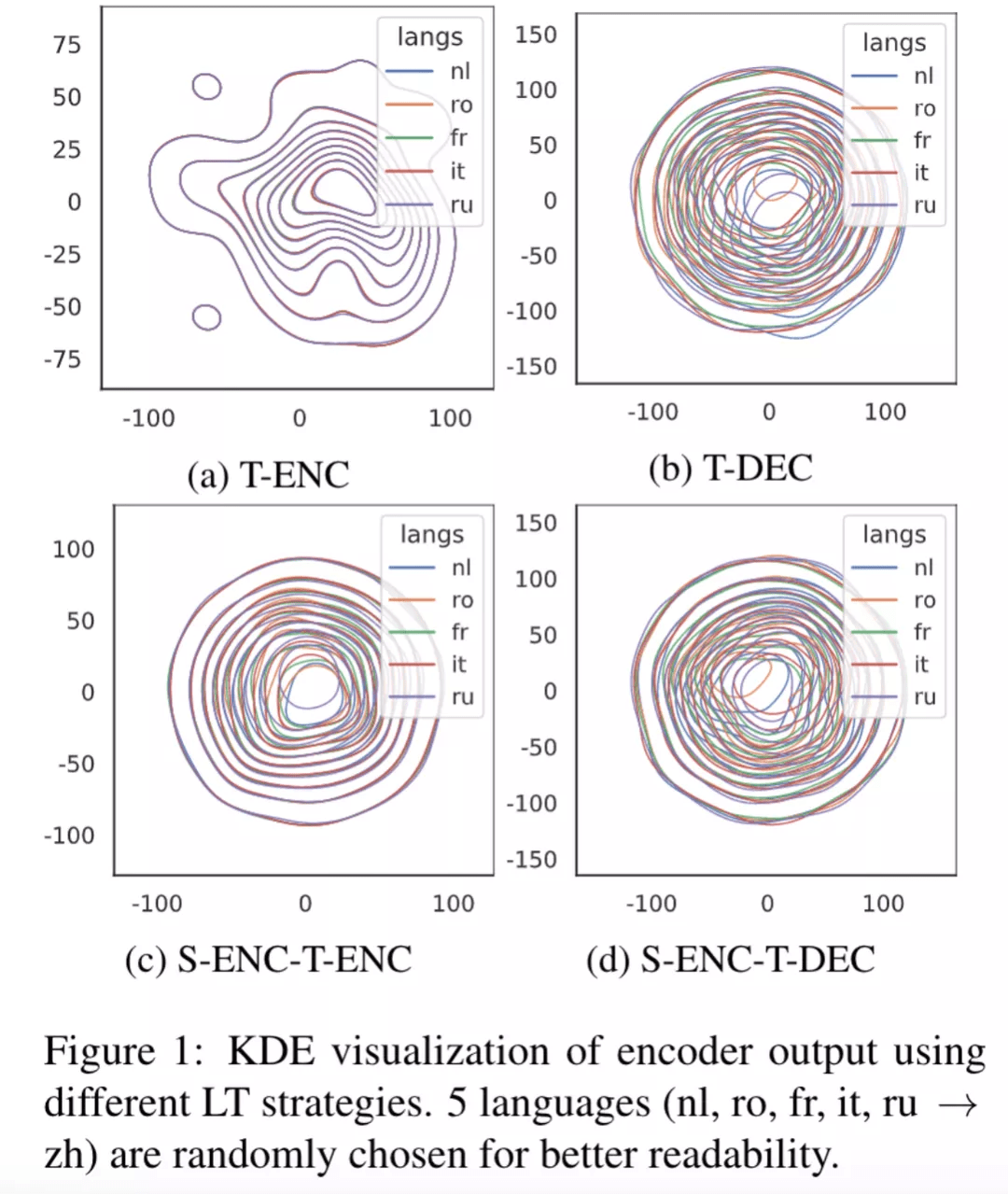

Encoder 的表示的一致性

文章图片

上图是通过对 Encoder 的输出使用 t-SNE 降维 , 之后使用 kde 画出来的分布图 , 展示了不同语言的句子在目标语言相同的情况下的分布 , 可以发现 T-ENC 不同语言之间的 Encoder 表示分布更加一致 。 这表明 , T-ENC 能够帮助模型学习到语言无关的 Encoder 表示 。

缓解 off-target 的问题

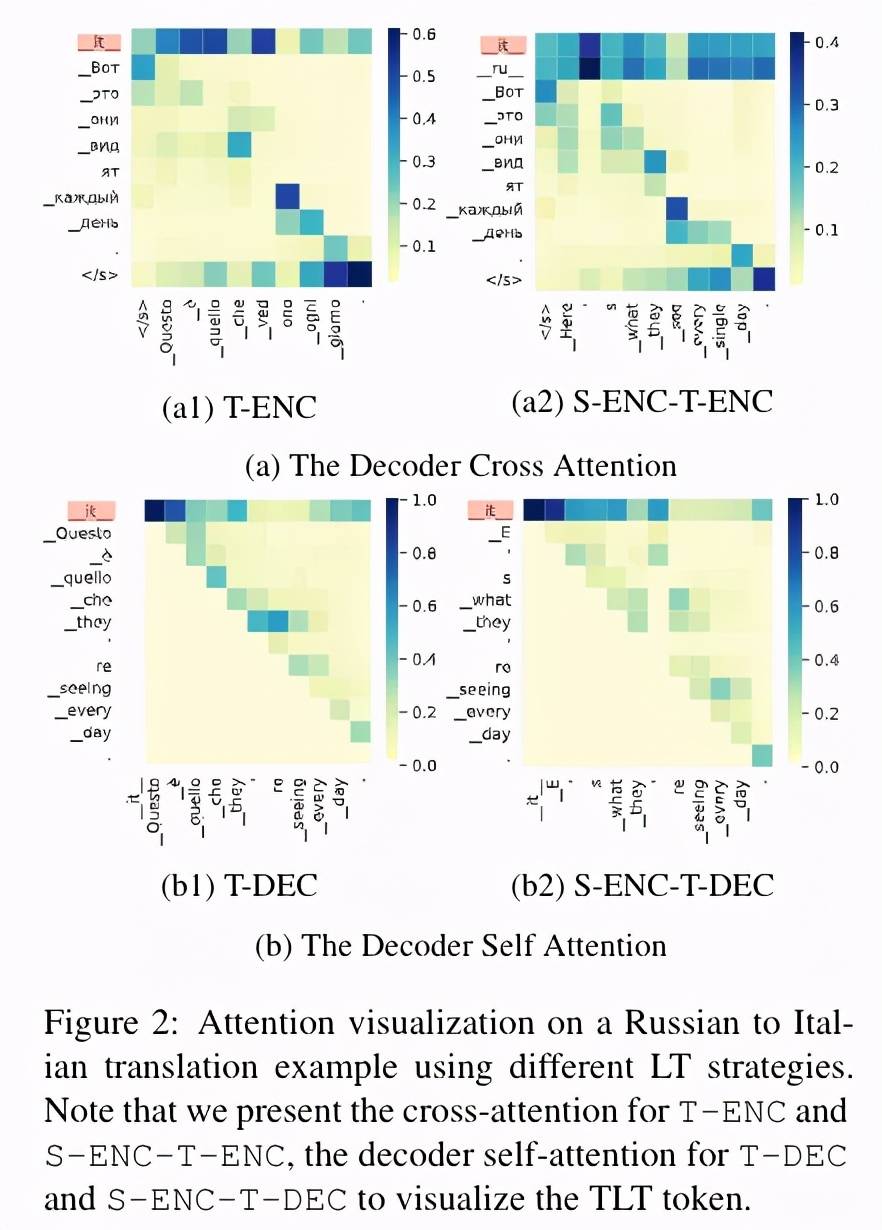

文章图片

上图通过一个 case study 展示了从一个俄语句子翻译到意大利语句子时 , 不同的语言标签下 , 模型的 attention 对意大利语标签的 “关注” 程度 , 显然使用 T-ENC 时 , 模型对意大利语标签的关注程度最高 , 这可以一定程度上解释为什么 T-ENC 拥有最小的 off-target 比例 。

不同层的相似性

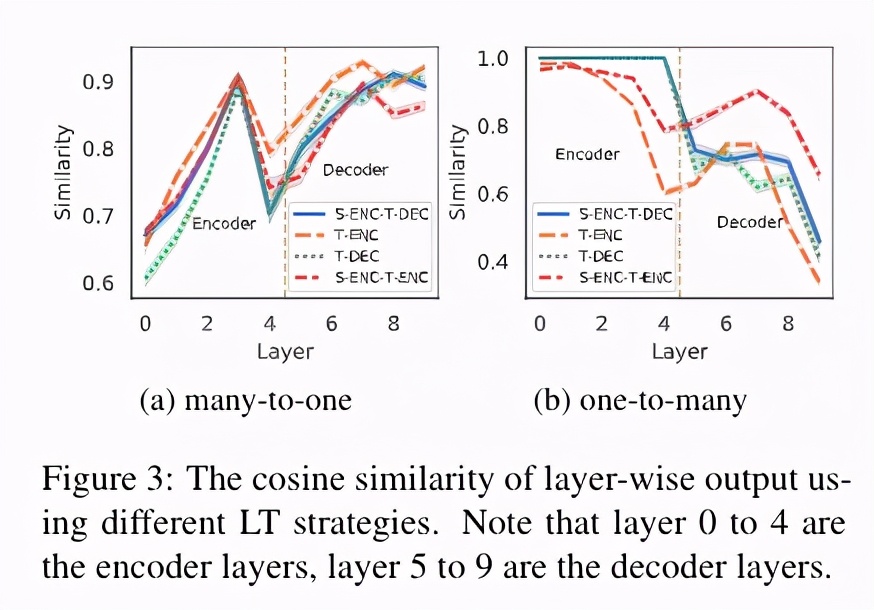

文章图片

上图的子图 a 展示了 , 从除了英语和俄语外的 18 个语言翻译到俄语的时候 , 意思相同的句子在不同语言之间的表示的相似性 , 可以看到 T-ENC 的相似性曲线一直在其他的语言标签之上 , 这表明在目标语言相同的时候 , T-ENC 各层的表示相比于其他的方法都有更好的一致性 。

上图的子图 b 展示了 , 从俄语翻译到除了英语和俄语外的 18 个语言翻译的时候 , 同一个俄语句子在不同目标语言下的相似性 , 可以看到 T-ENC 的相似性曲线几乎一直在其他的语言标签下方 , 这表明 , 当目标语言不同的时候 , T-ENC 能够更好的生成目标语言相关的表示 。

总结

该研究发现了不同语言标签对多语言 Zero-shot 翻译的巨大影响 , 并在数据相差很大的三个不同的数据集上进行了实验 , 验证了不同语言标签对多语言 Zero-shot 翻译确实存在巨大影响 , 并且表明 T-ENC 在 Zero-shot 上优于其他语言标签 。 同时该研究还分析了不同语言标签对模型在预测时表示的影响 , 发现 T-ENC 能够更好地得到与目标语言相关而与源语言无关的表示:

1. T-ENC 能使不同源语言句子经过 Encoder 的表示更一致 。

2. T-ENC 的注意力机制能够更好的注意到目标语言的语言标签 。

3. T-ENC 在不同层的表示相对于其他方法与目标语言的相关性更强 。

参考文献

[1] Wu L, Cheng S, Wang M, et al. Language Tags Matter for Zero-Shot Neural Machine Translation[J]. arXiv preprint arXiv:2106.07930, 2021.

[2] Johnson M, Schuster M, Le Q V, et al. Google’s multilingual neural machine translation system: Enabling zero-shot translation[J]. Transactions of the Association for Computational Linguistics, 2017, 5: 339-351.

推荐阅读

- 区块|面向2030:影响数据存储产业的十大应用(下):新兴应用

- 下架|APK Installer 和 WSATools 同时躺枪:冒牌应用登陆微软应用商店

- 原神|《原神》「飞彩镌流年」2.4 版本预下载已开启

- 技术|聚光科技旗下临床质谱仪获批医疗器械注册证

- 最新消息|CES线下回归受阻:受奥密克戎肆虐影响

- 泡芙|传下去

- IT|以色列正式批准开放第四剂新冠疫苗接种 限免疫力低下人群

- 硬件|一个时代落幕 佳能:1DX3将会是旗下最后一款旗舰单反

- 转向|时代落幕,佳能:1DX3 将会是旗下最后一款旗舰单反

- 主控|英韧科技:致态 TiPro 7000 SSD 采用旗下主控