欢迎关注“新浪科技”的微信订阅号:techsina

文/周继凤

来源:深燃(ID:shenrancaijing)

深燃(shenrancaijing)原创

悲剧再次发生了 。

8月14日晚 , 名为“美一好”的公众号发布讣告称 , 8月12日下午2时 , 年仅31岁的创业者、上善若水投资管理公司创始人林文钦(昵称“萌剑客”) , 驾驶蔚来ES8汽车启用自动驾驶功能(NOP领航状态)后 , 在沈海高速涵江段发生交通事故 , 不幸逝世 。

据《科创板日报》报道 , 林文钦的好友郑先生称:“蔚来工作人员告诉我们 , 事发时 , 这辆蔚来正处于NOP状态 。 ”而蔚来内部人士回应称:“NOP领航辅助不是自动驾驶 , 后续有调查结果会向外界同步信息 。 ”

事件发生后 , 网络上掀起了有关自动驾驶技术的讨论 。 不少网友指出 , 车企为了商业利益 , 在宣传时将“辅助”驾驶与“自动”驾驶的概念进行混淆, 让用户过于信任和依赖这套系统 , 导致驾驶员很容易在开车时掉以轻心从而酿成惨剧 。 在蔚来这起事故之前 , 已经发生不少类似的安全事故 。

几乎同一时间 , 美国国家公路交通安全管理局(NHTSA)宣布 , 由于发生多起特斯拉汽车与停放的紧急车辆相撞的事故 , 该局已经开始对特斯拉的Autopilot自动辅助驾驶系统展开正式调查 。

对于一名汽车用户而言 , “辅助”驾驶与“自动”驾驶的概念功能 , 本应该是最基本的认知常识 。 可悲的是 , 自动驾驶行业里的玩家长期以来都在夸大宣传 , 忽悠用户 。

蔚来事件引起全网关注后 , 行业里大佬也纷纷站出来表达自己的观点 , 有提议我们应该重新定义自动驾驶概念的 , 也有安利自家自动驾驶技术的 , 但少有大佬反思和反省 。

自动驾驶行业发展了这么多年 , 这一次 , 安全问题以及“过度宣传”问题 , 终于被摆到台面上来了——以生命为代价 。

被滥用的自动驾驶

不止是这次悲剧的主人公 , 在全行业的鼓吹下 , 大量的消费者正在接受甚至依赖自动辅助驾驶功能 。

卢米是一名特斯拉车主 , 他平日里跑高速都会选择开启自动辅助驾驶 , 在他看来 , 自动辅助驾驶的体验很好 。

车主张鹭也发现了自动辅助驾驶的好处 。 “平日里开车 , 我只用手握方向盘 , 刹车和油门就不用踩了 , 系统会自动跟车 , 自动转弯 , 非常方便 。 ”甚至有几次 , 张鹭感觉自动驾驶救了他的命 。 他回忆 , 特斯拉的自动驾驶有一些主动预警措施 , 比如在车道偏离、接近追尾时 , 关键时刻会给他提醒 。

但是 , 已经逐渐习惯并且依赖这一套系统的消费者们 , 其实并不清楚自己开启的是怎样一套系统 , 以及这套系统是否存在风险 。

很多时候 , 他们依据名字来判断 。

目前 , 特斯拉针对自动驾驶推出了不同的软件包 , 其中 , 基础标配的功能被称作基础辅助驾驶功能(即AP) , 更高阶的软件包FSD , 被称为完全自动驾驶 。 由于特斯拉直接把更高阶的自动驾驶软件包取名为完全自动驾驶 , 不少车主直接把特斯拉FSD等同于自动驾驶技术 。

一名特斯拉车主坦言:“我其实分不清具体什么是自动驾驶 , 什么是自动辅助驾驶 。 但是有朋友推荐说 , 可以开启一下AP , 效果挺好 , 我就跟着一起用了起来 。 ”

人们也不知道 , 在所谓的自动辅助驾驶模式下 , 究竟什么可做什么不可做 。

经朋友推荐开启自动辅助驾驶功能的特斯拉车主王盛 , 如今只要是跑通勤上高速或者上环线都会开启自动驾驶 。 他有时候会分心处理一些公务 , 有时候还会接接电话 。

不止是国内 , 美国安全保险研究所在2020年的一项调查显示 , 有48%的司机错误认为 , 只要开启了特斯拉的“Autopilot”功能 , 不掌控方向盘也是安全的 。

一些人太信任自动辅助驾驶系统 , 以为开车时完全可以解放双手双脚 。

不少车主在网络上分享了抖机灵的做法 , 比如把矿泉水瓶、橘子绑在方向盘上迷惑系统 , 让系统误认为是驾驶员的手放在方向盘上 。 8月份 , 甚至有车主上传了一段自己使用辅助驾驶系统躺着开理想ONE的视频 , 一度引发全网热议 。

在现代社会 , 信任能更快地达成交易 , 但对于自动辅助驾驶来说 , 过度信任 , 有时候却会送命 。 早在蔚来这起致命事故发生之前 , 因为驾驶员过于信任自动辅助驾驶系统 , 已经酿成了多起悲剧 。

2016年 , 美国佛州的一辆特斯拉Model S在Autopilot状态下与正在转弯的白色半挂卡车发生碰撞 , 特斯拉驾驶员不幸身亡;2019年 , 一辆特斯拉Model 3在Autopilot状态下以110公里/小时的时速径直撞向了一辆正在缓慢横穿马路的白色拖挂卡车……

美国国家公路交通安全管理局(NHTSA)在调查后发现 , 自2018年1月以来 , 特斯拉自动驾驶系统已导致11起事故 , 致17人受伤 , 1人死亡 。 且这11起事故中有4起发生在今年 。

被夸大的自动驾驶

自动驾驶的诞生源自这样一个逻辑 , 人类驾驶员会犯很多错误 , 而自动驾驶汽车犯错的概率相对于人类要小很多 , 会让驾驶变得更加安全 。 为什么原本是为了让人类驾驶更安全的系统 , 如今成为了马路杀手?

这其实不仅仅是一个技术问题 。

我们从自动驾驶的分级说起 。

当下车企所宣传的“无人驾驶”、“自动驾驶” , 其实都是L2级别的自动辅助驾驶 。

根据SAE(美国汽车工程师学会)的分类 , 自动驾驶可以分为L0-L5级六个阶段 。 其中L0代表无自动辅助功能;L1-L2为驾驶辅助系统 , 驾驶员是车辆操作的主体;L3-L4为有条件的自动驾驶系统;只有到了L5才是真正的无人驾驶 。

这其中最重要的分界线是L2级别 。

L2及以下级别是自动驾驶的初级水平 , 这个区间的自动驾驶技术不具备“全自动驾驶能力” , 是始终需要人类监管的驾驶辅助系统——事故主要责任人始终是人类驾驶员 。

按照常规 , 一名驾驶员理应知道自己购买的车归属于什么自动驾驶级别 。 如果是在L2级自动辅助驾驶系统中 , 作为完全责任主体的驾驶员 , 则更应该明确认识到L2级自动辅助驾驶系统的风险 。

但很多车企都在不遗余力地模糊L2这一界限 , 夸大自己的自动驾驶技术 。

很长一段时间 , 特斯拉将Autopilot(高级辅助驾驶系统) , 当成“自动驾驶”对外宣传 , 直到发生多次安全事故 , 才不得不改口 。 而即便现在 , 特斯拉最高阶的软件包FSD , 仍被称为完全自动驾驶 。

至于国内 , 蔚来副总裁沈斐曾在微博中表示 , 车主们使用其自动辅助驾驶功能时可以“放心地边吃东西边开车”(相关内容现已删除) 。

车企很清楚 , 如果直接表明自己是L3、L4级别的自动驾驶 , 那么一旦发生事故 , 责任方就会归于自己 。 于是 , 他们在宣传时打一些擦边球 。

【|“自动”驾驶?别忽悠了】比如 , 4月16日 , 威马正式亮相了第三款量产车型W6 。 在官方宣传中 , 威马反复强调W6是“20万级国内首款无人驾驶量产车型”、“国内首款L4级别无人驾驶量产车” 。

但实际上 , 威马W6仅仅在停车这个场景上 , 实现了L4级别无人驾驶 。 但很多消费者误以为“威马的所有出行场景都实现了L4级别无人驾驶” , “威马的W6是唯一实现了L4级别无人驾驶的量产车 。 ”

这些夸大宣传提高了企业的曝光度 , 但在巨大的信息不对称下 , 消费者很有可被误导 , 误以为企业已经推出全自动驾驶技术 。

著名自动驾驶公司Waymo曾放弃将自动驾驶称为“self driving” , 更名为“autonomous driving” 。 Waymo的逻辑是:“精确的语言很重要 , 可以挽救生命 。 ”

反过来 , 我们可以套用一下Waymo的逻辑——车企们正在用模糊的语言把越来越多的人推向悬崖 。

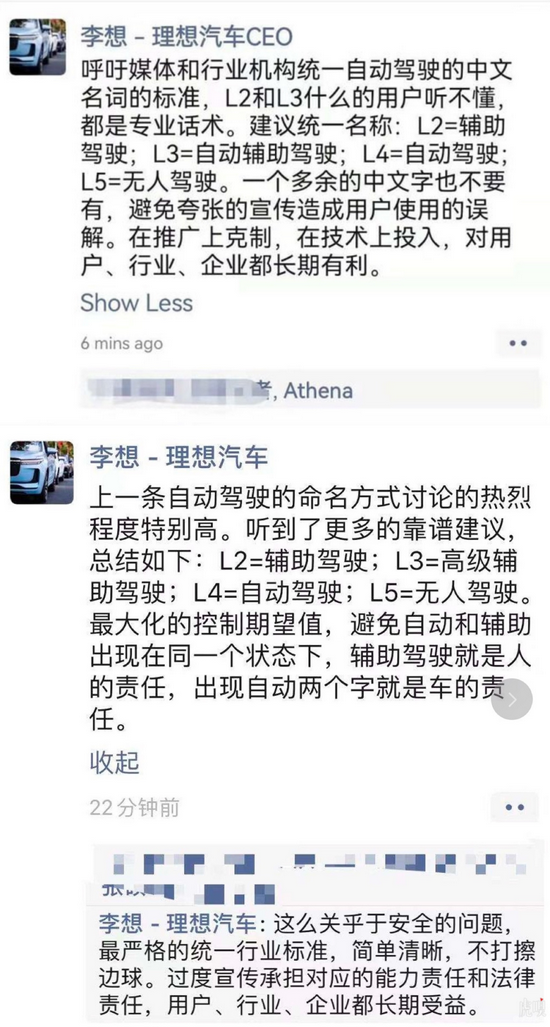

8月16日晚间 , 理想汽车创始人李想在朋友圈发文称 , L2 、L3一类的专业话术 , 用户容易混淆且听不懂 , 建议统一名称为L2=辅助驾驶;L3=高级辅助驾驶;L4=自动驾驶;L5=无人驾驶 , 一个多余的中文字也不要有 。

“最大化的控制期望值 , 避免自动和辅助出现在同一个状态下 , 辅助驾驶就是人的责任 , 出现自动两个字就是车的责任 。 ”他表示 。

文章图片

图1/2

图片来源 / 李想朋友圈

再说回来 , 即便是L2级别的辅助驾驶 , 也不是100%安全 。 在当下 , L2级别的自动驾驶辅助系统主要配备毫米波雷达以及视觉识别(摄像头) , 从而感知环境 。 其中 , 毫米波雷达对于前方完全静止的物体 , 有一定几率无法识别 。 而视觉识别是按照深度学习的逻辑来运行的 , 也永远无法达到100%的准确率 。

也就是说 , 面对复杂的路况 , 自动辅助驾驶的识别无法做到100%精准 。

对于驾驶员来说 , 在使用自动辅助驾驶功能时 , 永远需要保持警惕以备不时之需 。 作为系统的提供方 , 车企有责任有义务将自动辅助驾驶的功能及使用范围明确 , 并确保教会用户正确的操作方法 。

但就目前来看 , 在风险提醒上 , 各大车企做得相当敷衍 。 有媒体指出 , 蔚来NOP在去年10月更新上线 , 自动辅助驾驶功能推出或升级时 , 蔚来对车主的线上安全提醒都是非强制性的 。

蔚来的这种行为就相当于 , 我把说明书摆在这儿 , 你愿不愿意看或者看不看得懂 , 都和我没关系 。

自动驾驶大跃进

很长一段时间 , 以上提到的这些潜在风险 , 都被自动驾驶行业的光环掩盖了 。

近些年 , 自动驾驶行业蓬勃兴盛 。

资本与行业玩家合力打造了一个看上去颇具颠覆性的出行故事 , 这个出行梦的核心就是自动驾驶技术 。 中国智能网联汽车创新中心预测 , 2020年至2025年 , 可以实现部分自动化或有条件自动化的智能网联汽车销量 , 占当年汽车总销量的比例将超过50% 。

以特斯拉为代表的汽车制造商 , 加速了这一进程 。

2015年 , 特斯拉第一次通过OTA的方式为Model S推送了Autopilot辅助驾驶系统 。 特斯拉车主们一觉醒来 , 发现自己的车突然获得了一些自动辅助驾驶功能 , 比如 , 在高速路上特斯拉可以自动保持车道、自动根据路况加减速等等 。

靠着特斯拉的带动 , 越来越多安装着自动驾驶辅助系统的智能车上路 。 如今 , 一辆电动车如果没有搭载自动辅助驾驶 , 似乎不能够称之为智能车 。

投资人开始意识到 , 卖车卖硬件或许不是最重要的 , 自动驾驶等软件服务才是最具想象力的环节 。

而跨界造车也让自动驾驶上下游产业链火爆了起来 。 仅今年6月的第一周 , 就有3家自动驾驶公司相继宣布获得融资 , 总计融资超过32亿元 。

整个市场变得大胆且激进 。 马斯克一度放话:“我们已经非常接近L5自动驾驶了 。 ”为了搏出位、吸引投资人的目光 , 不少车企对外宣称已经实现L3、L4级别自动驾驶 。

文章图片

图2/2

来源/视觉中国

一位业内人士曾指出 , 已经量产的车企 , 很多完全没有自研能力 , 只能转头选择向博世、Mobileye等厂商采购成熟的自动驾驶方案 。 但这不影响车企们将之包装成自己的研发能力 。

7月初的世界人工智能大会上 , 原华为智能驾驶产品线总裁兼首席架构师苏菁曾面对特斯拉的高事故率 , 痛斥其为“杀人” 。

一位用户在看完最近的报道后感叹:自动驾驶技术走向成熟的道路也是一段无数用户亲身试错的血泪史 。

一位业内人士指出:“为了保证安全 , 技术层面以外 , 法律法规也需要适配自动驾驶的边界 。 ”

值得关注的好消息是 , 终于有相关的文件出台了 。 8月12日 , 工信部印发了《关于加强智能网联汽车生产企业及产品准入管理的意见》 ,其中明确了车企的告知义务 。 即车企针对自家的驾驶辅助和自动驾驶功能 , 需要明确告知车辆功能、性能限制、驾驶员职责 , 功能激活和退出条件等等 。

但在操作层面 , 还有更多细微的问题需要解决 。

国外有可参考的案例 。 2020年 , 美国高速公路安全保险协会IIHS发布了一系列ADAS功能的指导方针 。 其中 , IIHS建议 , 自动化系统能够提升安全的关键就是确保司机需要始终参与车辆的操作 。

当下 , 车企们防止司机分神的系统仅有两类 。 一是像特斯拉和一些主流车企采用的方向盘压力检测 , 如果系统检测到司机的双手离开方向盘达到一定时长后 , 便会分段执行警告、强制解除辅助驾驶状态、刹车等动作 。 另一种是安装面向驾驶员的摄像头来监控驾驶员的面部是否一直面向道路 。

IIHS指出 , 这些都不是万无一失的方法 。 该机构建议 , 还应该加入检测方向盘是否被手动调整 , 调整了多少角度以及驾驶员注意力监控 。 这或许是一些更为实际的指导方法 。

*题图及文中部分配图来源于Unspalsh 。

(声明:本文仅代表作者观点 , 不代表新浪网立场 。 )

推荐阅读

- 快报|“他,是能成就导师的学生”

- 技术|“2”类医械有重大进展:神经介入产品井喷、基因测序弯道超车

- bug|这款小工具让你的Win10用上“Win11亚克力半透明菜单”

- 重大进展|“2”类医械有重大进展:神经介入产品井喷、基因测序弯道超车

- 历史|科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 空间|(科技)科普:詹姆斯·韦布空间望远镜——探索宇宙历史的“深空巨镜”

- 精度|将建模速率提升10倍,消费级3D扫描仪Magic Swift在2021高交会大显“身手”

- 四平|智慧城市“奥斯卡”揭晓!祝贺柯桥客户荣获2021世界智慧城市治理大奖

- |南安市司法局“加减乘除” 打造最优法治营商环境

- ASUS|华硕预热ROG Flow Z13:称其是“全球最强悍的游戏平板”