概念验证和 A/B 测试只不过是迈向生产的一小块垫脚石 , 称不上伟大的成就 。 每一位数据科学家和机器学习工程师都应该尽快将他们的机器学习模型投入生产 。 一个沙盒模型即便再伟大 , 也远不如一个普通的生产模型 。

基础设施

现在是 2021 年 , IT 基础设施不应再成为阻碍因素 。 不久前 , 软件已经通过云 API、基础设施即代码、Kubeflow 等抽象化的方式 , 吞噬了基础设施 。

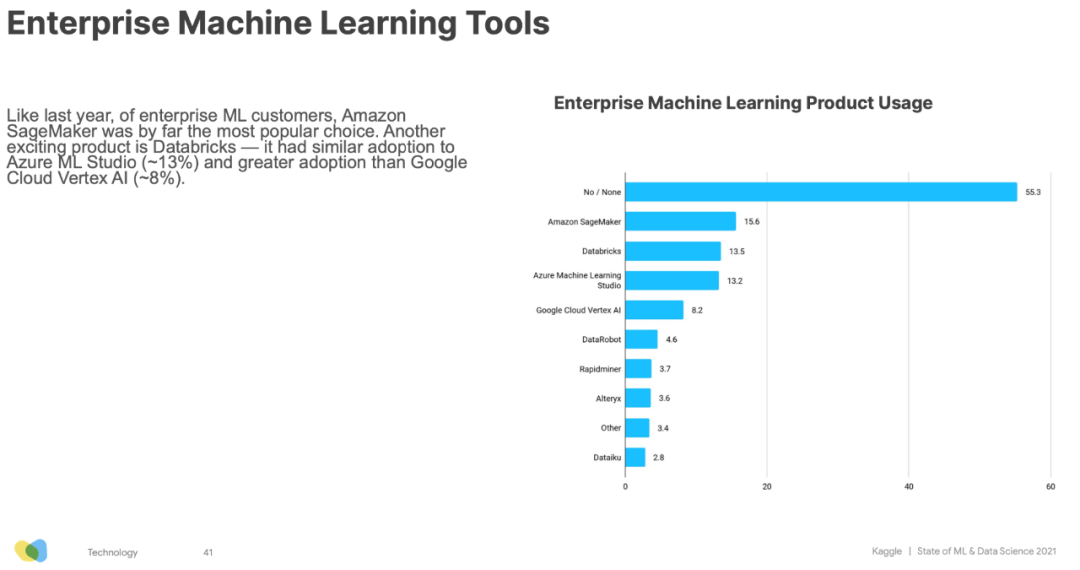

如今 , 机器学习基础设施也在迅速地发展 。 根据 Kaggle 的调查 , 75%的公司都选择使用云服务 , 超过 45% 的企业使用机器学习平台 , 其中Amazon SageMaker、Databricks 和 Azure ML Studio 位居前三 。

文章图片

有了机器学习运维 , 软件定义的基础设施和平台 , 我们就可以很容易地将想法从沙盒带入生产 。 回到开头的几个问题 , 你需要的是更多精通机器学习的软件和开发运维工程师 , 而不是更多的数据科学家 。

Transformer

人工智能状况报告表示:“Transformer 架构的应用已经远远超出了自然语言处理 , 正在成为通用的机器学习架构 。 ”例如 , 最近的模型 , 如 Google 的Vision Transformer 是一种无卷积 Transformer 架构 , 还有 CoAtNet 结合了 Transformer 与卷积 , 为 ImageNet 的图像分类设定了新的基准 , 同时训练所需的计算资源也更少 。

另外 , Transformer 在音频(例如语音识别)以及点云(一种用于模拟自动驾驶 3D 环境的技术)方面的表现也很出色 。

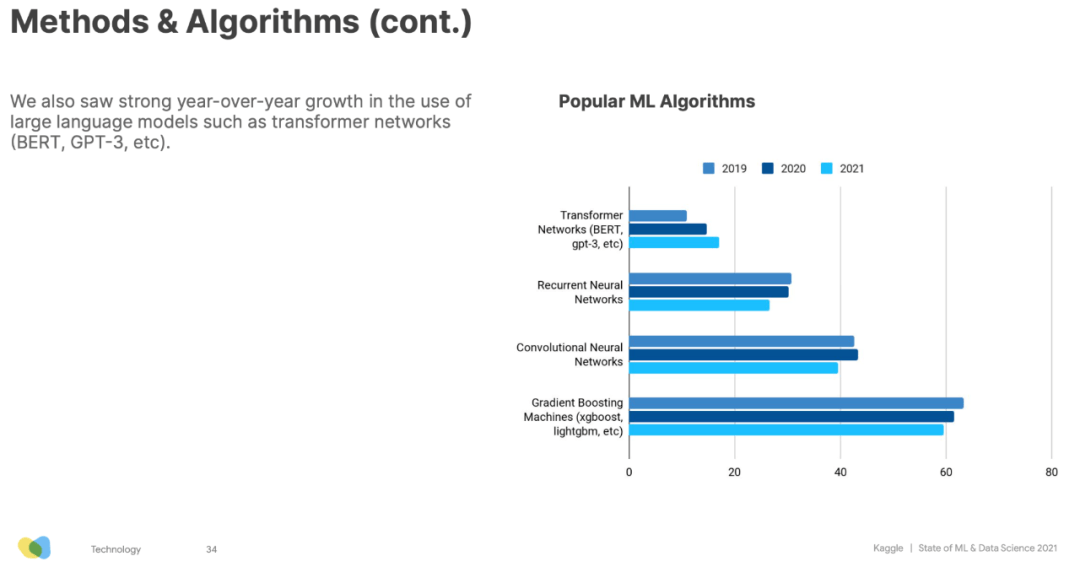

Kaggle的调查结果也表明 Transformer 的兴起 。 该框架的使用量逐年增长 , 而 RNN、CNN 和梯度提升算法正在衰退 。

文章图片

除了提高准确性之外 , Transformers 还在不断改善迁移学习 , 不仅能够节省训练时间和计算成本 , 而且还能更快地交付业务价值 。

随着 Transformers 的发展 , 机器学习的世界正在由“从零构建和训练深度学习模型”逐步转变为“选择一个现成的模型 , 然后利用数据进行微调即可使用 。 ”

从很多方面来说 , 这是一件好事 。最先进的技术在不断进步 , 几乎没有人能跟上该领域无情的步伐 。 还记得之前提到的 Google Vision Transformer 模型吗?你想试试看这个模型吗?在Hugging Face 的帮助下 , 尝试该模型非常简单 。

还记得 Big Science 项目推出了最新的零样本文本生成模型吗?如今 , 你可以通过Hugging Face , 尝试 16,000 多个模型和1,600 多个数据集 , 此外还可以使用推理、AutoNLP、延迟优化和硬件加速等工具 。

HuggingFace 的目标是提高机器学习的易用性和效率 , 无论你是初学者还是专家 , 都可以轻松地使用各种机器学习模型 。

推荐阅读

- 代码|GGV纪源资本连投三轮,这家无代码公司想让运营流程变简单

- Apple|新专利显示 苹果计划用光学传感器取代手表的数码表冠

- 最新消息|年终奖计税优惠政策将延续 年前年后到手或差上万元

- IT|研究表明奥密克戎正在取代德尔塔 潜伏期更短更趋常态化

- 葡萄|金印联携手葡萄城,低代码技术实现“万物皆可集成”

- 葡萄|中恒五金携手葡萄城:10年软件开发经验,凭借活字格低代码平台再创业

- Microsoft|Mesa D3D12最新代码中已添加对SSBOs的支持

- 人物|程序员被辞退报复公司 写代码转账553笔

- 检测|华人科学家研发心肌细胞动作电位检测工具,或取代心脏检测膜片钳技术

- 代码|腾讯云微搭低代码负责人王倩:低代码将成为数字化转型中坚力量