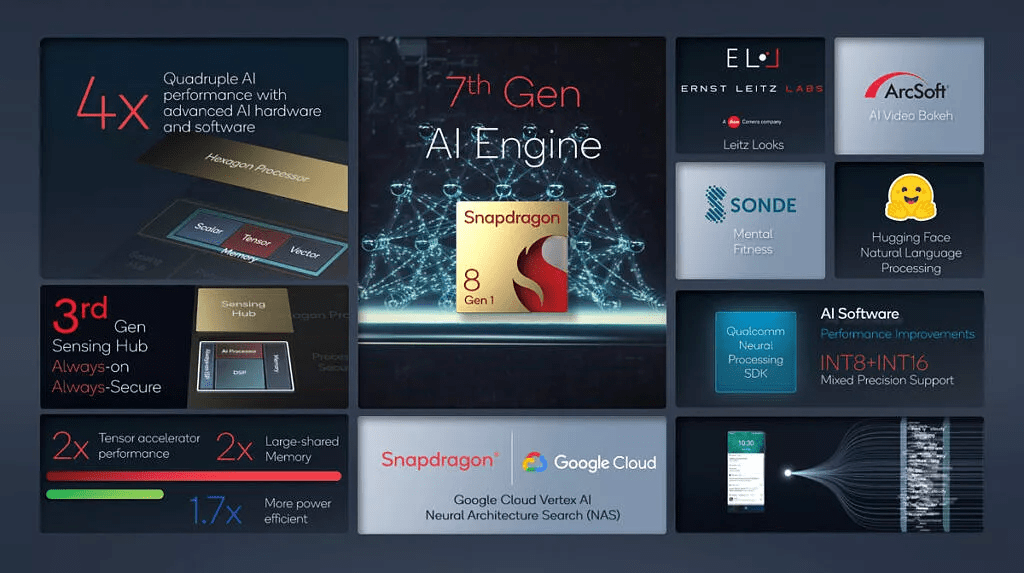

在应用广泛的一些 AI 模型上 , 如 inceptionv3、mobilenet_v2、Resnet50、VDSR 等 , 推理速度比前代 AI 引擎快 4 倍 , 同时 AI 运算能效比前代提升了 1.7 倍 。

第 7 代 AI 引擎能够实现如此量级的提升 , 很大程度上得益于新一代的 AI 软件:除了 Hexagon 处理器张量计算性能翻倍 , 共享内存翻倍以外 , 其 AI 软件性能也提升了 2 倍 , 现在支持了 INT8 + INT16 的混合精度计算 。

文章图片

更大的内存意味着芯片可以运行更大、更深的神经网络 , 而更高的精度则可以让算法推理的结果更加准确 。 开发工具上 , 新的神经网络处理 SDK 更新了算子支持 , Qualcomm AI Engine Direct 可直接接入移动端深度学习框架 TensorFlow Lite 和 Android NN API , 方便开发者将自己的 AI 模型更快地应用在移动端 。

用手机完成台式机的任务

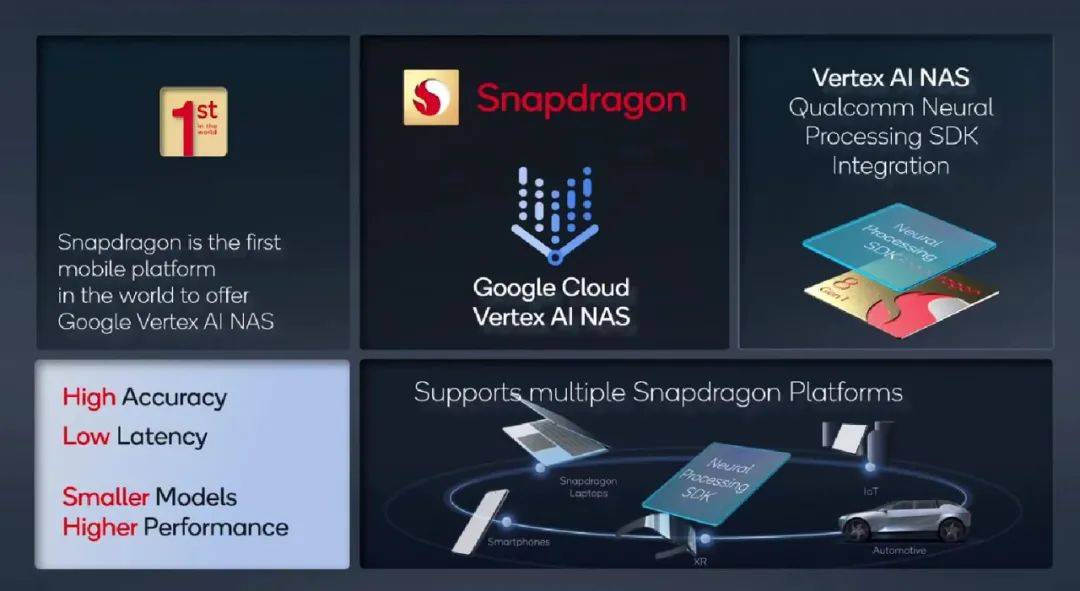

新的 AI 技术层出不穷 , 要如何把机器学习模型塞进手机呢?对于工程师们来说这是一个非常有挑战性的工作 , 使用 AI 技术自动来完成是一个很有前景的方向 。 高通和谷歌合作 , 将神经网络架构搜索(NAS)引入了骁龙平台 , 并已集成进第 7 代高通 AI 引擎 。

正如 AutoML 的思路 , 高通提供的 NAS 工具 Neual Processing SDK 可以将硬件配置、工作需求(如帧数、准确度)作为参数输入 , 由 AI 算法帮助工程师快速实现深度学习模型的最优设计 。

AI 可以从最基础层面开始 , 根据初始网络搜索并进行优化构建符合移动端硬件的模型 。 它能够考虑时延、网络规模、精度、功耗等目标 , 让模型在手机上运行得更快 , 而开发者的工作时间也可以从数月缩短到数周 。

文章图片

骁龙是全球首个支持 Google Cloud Vertex AI NAS 的移动平台 。 此前 , 高通有关提炼最佳神经网络架构的研究 DONNA 还被人工智能学术顶会 ICCV 2021 接收 。 高通希望在未来让 NAS 功能帮助多端部署工作 , 让 AI 模型快速部署至手机、笔记本电脑、VR 设备和汽车上 。

除了以上提到的技术和用例之外 , 骁龙 8 的 AI 引擎还能够实现哪些黑科技?比如 , 高通表示他们在与 Sonde Health 合作 , 开发一种基于音频识别的诊断技术 , 让手机只需要倾听你的声音就可以判断是否有抑郁、哮喘等健康问题 。

当然还有游戏画面中的超分辨率技术:

文章图片

通过利用历史帧数据和 GPU 优化运动估计 , Adreno 图像运动引擎可以让一些游戏的画面以双倍帧率运行 , 同时保持近乎相同的功耗 。

推荐阅读

- 平板|消息称 vivo 平板明年上半年推出:骁龙 870,四边等宽全面屏设计

- 手机|一加10 Pro现身跑分库:高通骁龙8 Gen 1+12GB内存

- 高通骁|一加 10 Pro 现身 Geekbench:搭载高通骁龙 8,运行安卓 12 系统

- 骁龙|骁龙8旗舰驯龙大战一触即发,“大师”和“高手”谁更厉害?

- 市场|三星可折叠手机今年销量突破 800 万部,是去年的四倍

- 科研机构|人工智能点燃哈尔滨高质量发展新引擎

- 双高|荣耀 Magic V 折叠屏曝光:搭载骁龙 8 Gen1,90Hz+120Hz双高刷屏

- 散热|小米12 Pro拆解出炉:豪华散热镇压骁龙8 Gen1、采用超薄屏下指纹

- 包装|辣榜 | 骁龙 888 Plus:摩托罗拉 edge S30 顶配版 2399 元预售

- Fast-LCD|玩出梦想推出旗下首款 VR 一体机 YVR DK1,搭载骁龙 XR2 芯片