定义|时间走向二维,基于文本的视频时间定位新方法兼顾速度与精度( 三 )

通过多尺度二维时间邻近网络定位

有了视频的稀疏二维特征图(图 2 中蓝色立方体)和文本特征(图 2 中黄色立方体) , 该研究将其进行融合 , 获得融合的稀疏二维特征图(图 2 中绿色立方体) 。 该研究再根据不同的时间尺度 , 将单一尺度的稀疏二维特征图 , 转化成一组稀疏的多尺度二维特征图 。 对于每个尺度的二维特征图 , 该研究使用一系列的 gated convolution 对每个片段和其邻近片段的关系进行建模 , 并通过一个全联接层获得各尺度中各片段最终的得分 。

训练和测试

在训练过程中 , 每一个尺度都会有一个对应的损失函数 , 该研究将二元交互熵 (Binary Cross Entropy) 作为模型的损失函数 , 同时使用一个经过线性变换的 IoU (intersection over union)的值作为损失函数中的标签 。 该研究将所有的损失函数加在一起作为整个模型的损失函数 。

在测试时 , 该研究根据特征的位置 , 得到每个片段的得分 , 并根据 NMS 对其进行筛选 。 如果一个片段存在于多个得分图中 , 那么选取最高的得分作为其得分 。

实验结果

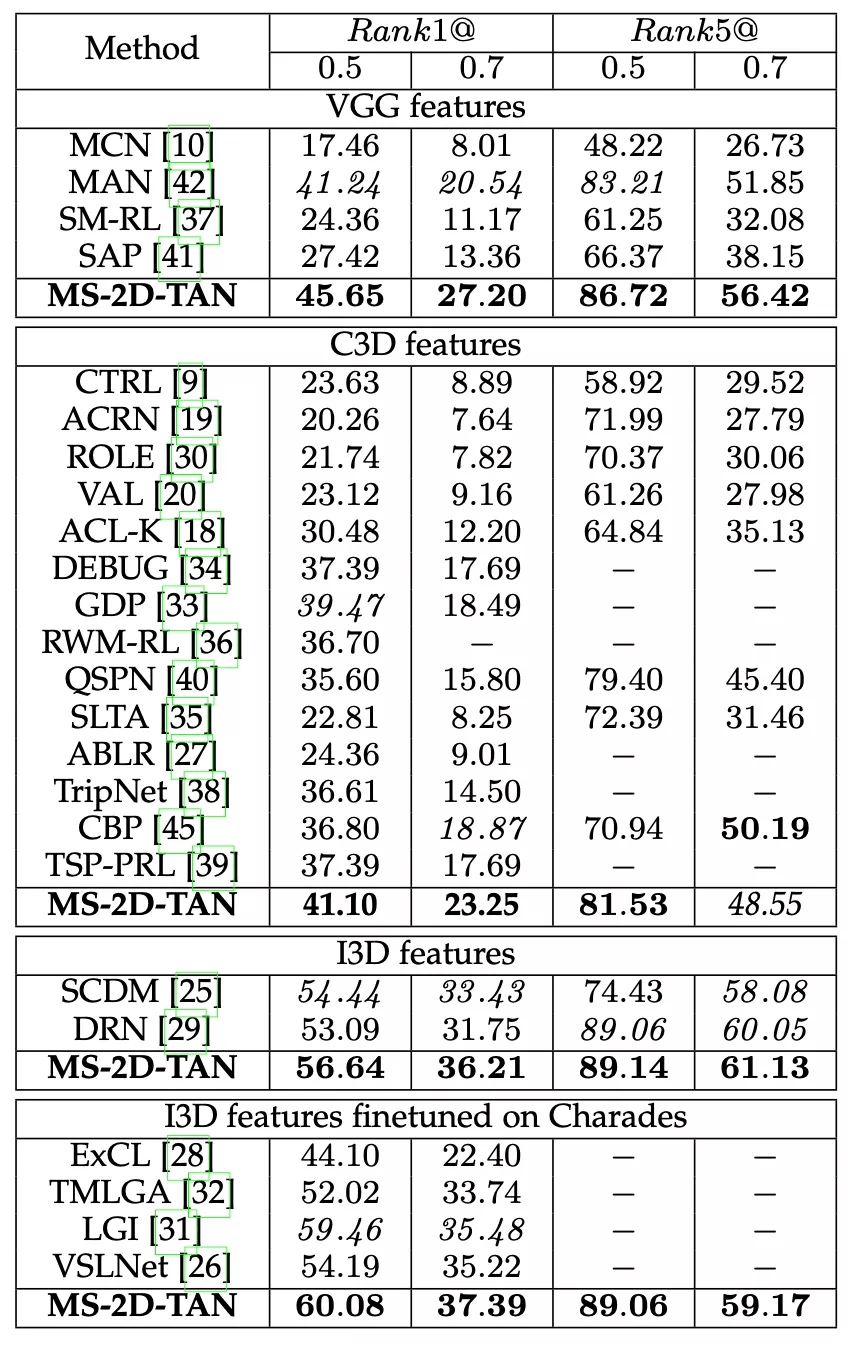

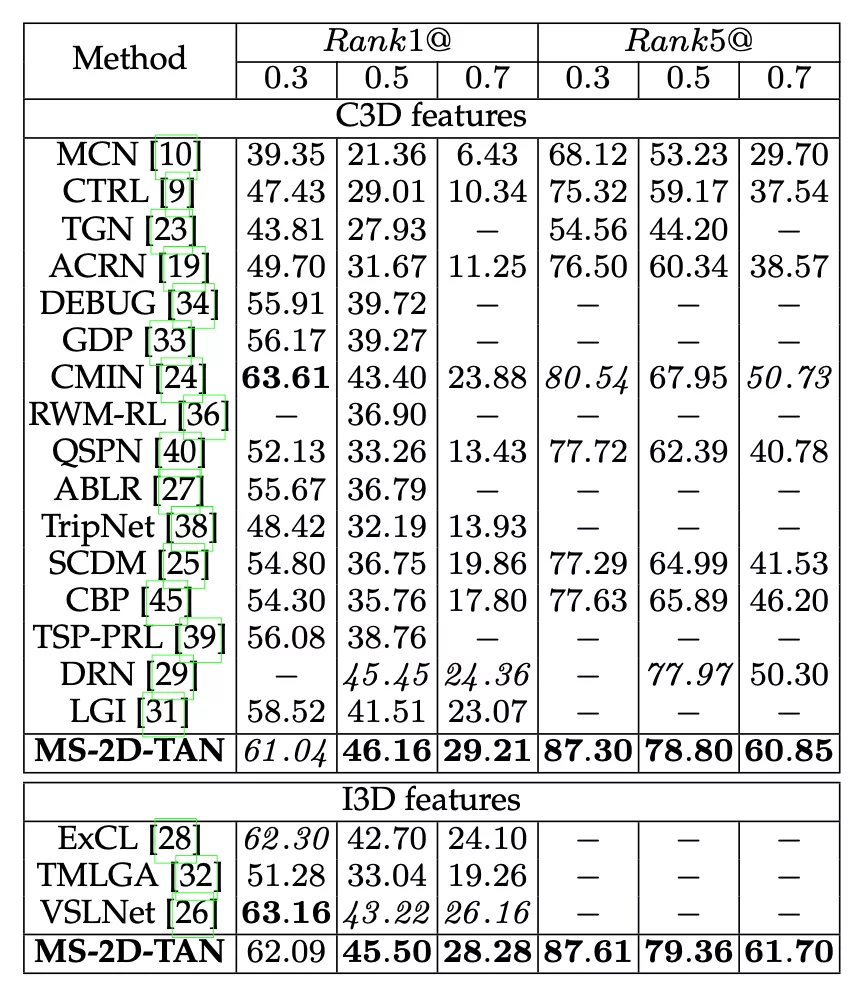

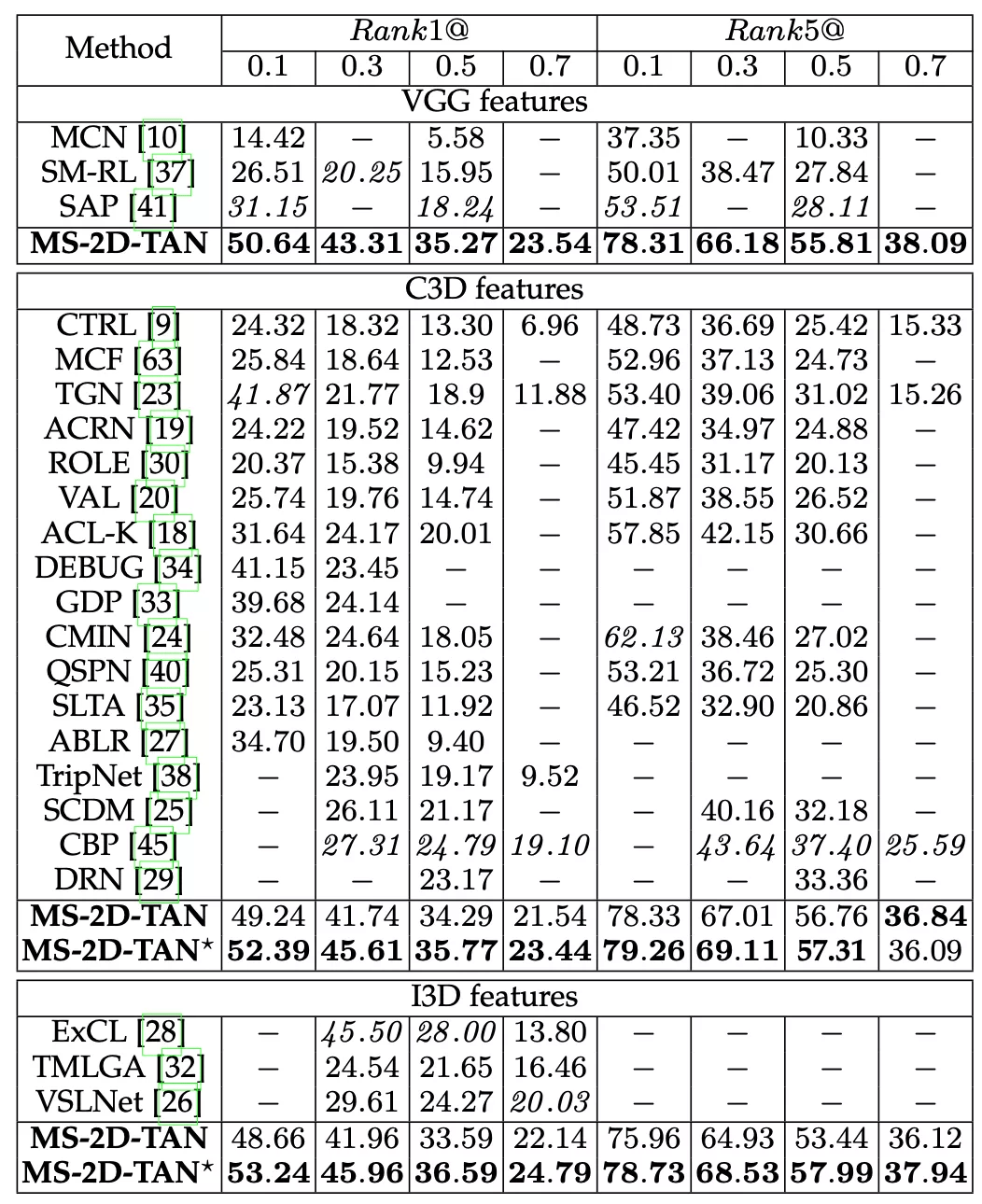

该研究在 Charades-STA [2], ActivityNet Captions [3] 和 TACoS [4] 三个数据集上评测 。 实验结果如表 1-3 所示 。 为了公平对比 , 该研究使用了和前人方法相同的视频和文本特征 , 且所有模型的超参保持一致 。 从实验结果中 , 无论使用哪种特征 , 该研究提出的 MS-2D-TAN 方法均能获得前两位的成绩 。 而在某些数据集上 , 进一步调整超参可以获得更好的性能 , 如表 3 的 MS-2D-TAN* 。

文章图片

表 1 Charades-STA 的实验结果

文章图片

表 2 ActivityNet Captions 的实验结果

文章图片

表 3 TACoS 的实验结果

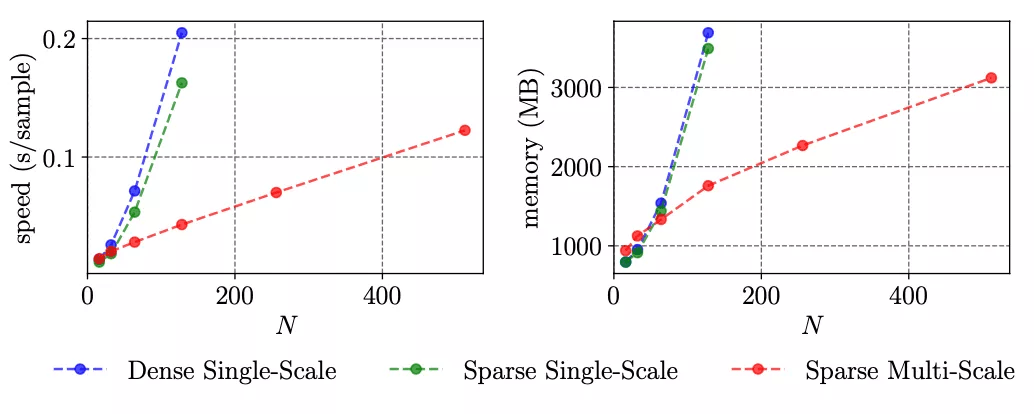

时间和内存的开销

该研究还对比了时间和内存的开销 。 图 3 中对比了稠密单尺度二维特征图 , 稀疏单尺度二维特征图 [1] 以及本文提出的稀疏多尺度二维特征图 。 可以发现在当视频长度较长时 , 使用稀疏多尺度二维特征图可以大幅减少时间和内存的开销 。 在图 4 中该研究也与其他方法在 TACoS 上进行了对比 。 当研究人员使用一个隐层参数量较小的模型 MS-2D-TAN (Small) 时, 该研究的方法可以在保证速度和内存开销稍小的前提下 , 比其他方法获得更高的精度 。 而使用较大参数量的 MS-2D-TAN 可以进一步提高精度 。

推荐阅读

- 时间|Alphabet量子公司横空出世!Sandbox将与谷歌、DeepMind成姊妹

- 时间|天津战“疫”:逆境中的光芒

- 新浪科技|无法知道时间的情况下,在岩洞连续生活40天是种怎样的体验?

- 硬件|全志科技:12nm CPU相关产品正处在研发阶段 目前暂无详细时间表

- 重载|「以高质量论英雄」先进轨道交通装备产业链 引领大同制造走向世界

- 时间|折叠屏“一部到位”,荣耀已完成“基因重组”

- Google|谷歌大力游说欧盟 防止《数字市场法案》严重冲击业务

- 新浪数码|海信发布8K AI画质芯片:100%自主研发未来产品自己定义

- 社交|在新冠病例激增的情况下,Meta再次推迟重返办公室的时间

- 手机|荣耀Magic V重新定义折叠屏:首先是一部好用的主力机