【测试中多次撞上“假人”,特斯拉别再用自动驾驶来祸害人了】

文章图片

文章图片

特斯拉最新的一项自动驾驶测试又翻车了(为什么是又) , 一起来看看怎么回事 。

三次都撞上了模型

测试者当然不是特斯拉自己 , 而是一家名字叫做 Green Hills Software的嵌入式开发公司 。 这家公司的CEO “Dan O'Dowd”在去年的时候组织了一项活动 , 内容就是通过测试各种各样的软件 , 来确立他们是否安全 。 特斯拉的FSD自动驾驶系统这么出名 , 当然是要蹭一波热度了 。 结果也正如大多数人所料 , 还是有不少问题 。

为了测试FSD 系统 , 这家公司设置了一个模拟场景 , 他们先是将路面清理干净 , 打造成普通公路模样 , 以尽量避免其他因素会对测试造成干扰 。 随后 , 他们在路中间安放一个“儿童模型” , 作为测试的主角 。

测试开始 , 一位专业的司机驾驶着特斯拉Model 3从远处向“假人”驶来 。 汽车速度慢慢提升 , 来到40英里/时 。 进入测试车道 , 驾驶员打开FSD模式 , 自动驾驶开始接管人为操作 。 随后 , 在FSD系统的控制下 , 特斯拉Model 3似乎出现一些迟疑 , 速度降了下来 , 但这不妨碍它义无反顾地撞上“假人” 。

撞完后 , 特斯拉Model 3好像找回了感觉 , 重新加速并继续行驶 。 为了验证这不是偶然事件 , 测试组之后又做了两次相同的测试 , 结果FSD系统很稳定 , 回回都撞上了“假人” 。 这个测试结果 , 怕是要把马斯克脸都打“肿”了 , 毕竟后者在今年一月份的时候还在吹牛:特斯拉FSD系统从来没有引发任何一起事故 。

因为曝光FSD缺陷被开除

这件事让我想起了之前的一个倒霉蛋约翰·伯内尔(John Bernal) , 他是特斯拉的“前”员工 。 今年早些时候 , 他因为在视频网站发布了关于特斯拉Model 3 FSD系统的视频 , 惹得马斯克非常不高兴 , 结果就被开了 。

在视频中 , 他和朋友一块乘坐着特斯拉Model 3 , 只不过他们并没有人为驾驶 , 而是交给了FSD全自动驾驶系统 。 然后在某个路口右转的时候 , 他们眼睁睁看着特斯拉

这则视频的播放量不低 , 对FSD的名声造成了不小的影响 。 而在视频发布后不久 , 约翰·伯内尔就接到了被解雇的通知 。 有意思的是 , 在被解雇之前 , 他的上司还告诫过他不要发布不利于FSD系统的视频 。 看来当时约翰并没有把这些话听进去 。

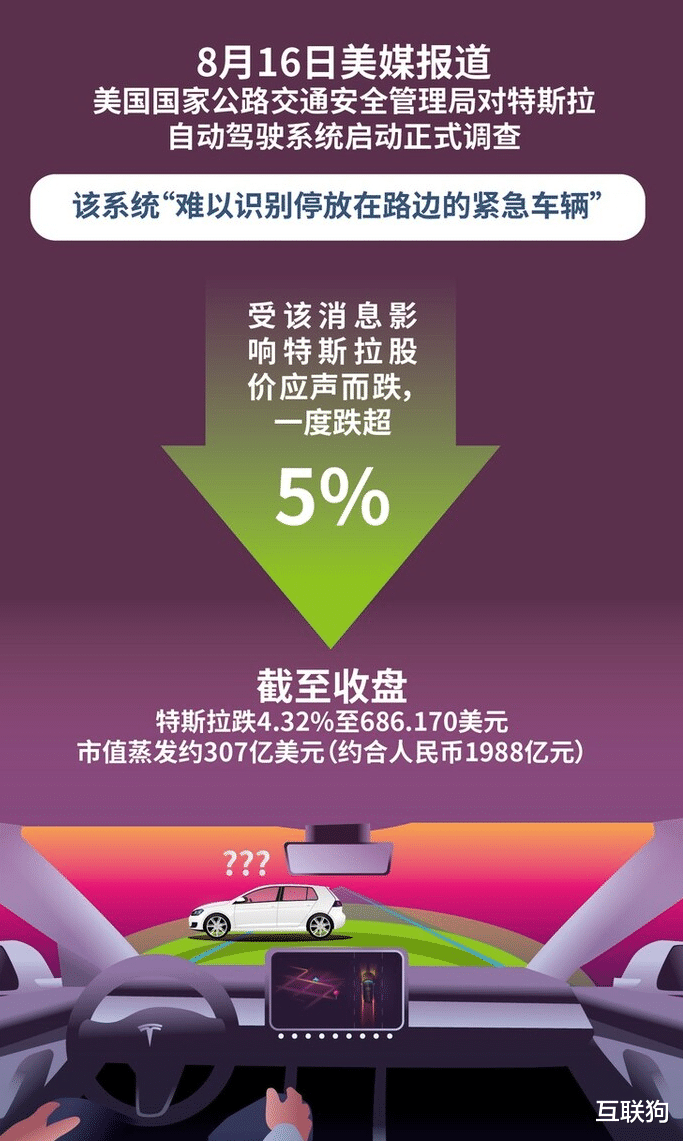

被投诉被调查

虽然马斯克一直嘴硬 , 但FSD系统早就被质疑过无数场次了 。 根据美媒报料 , 美公路交通安全管理部门已经接到了数十起FSD相关事故的投诉案件 。 七月份的时候 , 美相关部门还在调查马斯克是否在虚假宣传自己的自动驾驶系统 。 而在此之前 , 类似的调查已经进行过多次了 。

其实不止是美 , 我们 , 欧洲等各个地区 , 都质疑过马斯克故意夸大FSD自动驾驶系统的能力和水平 。 而这背后 , 有许许多多因为过度信任FSD系统而失去一切的人 。

最后 , 还是希望朋友们不要轻易相信马斯克和特斯拉的忽悠 , FSD系统这玩意 , 平常用用可能真没啥 , 但是它留给你犯错的机会也很可能只有一次 。 非要拼上一切去给自动驾驶系统试错 , 属实是没必要 。

推荐阅读

- 特斯拉“自燃率”为什么这么高?当车主拆开池后,终于发现了端倪

- 28217辆!国产特斯拉交付数据出炉:环比暴跌64.2%

- 有车主在林志颖车祸后转卖特斯拉订单,是害怕,还是别有原因?

- 为什么特斯拉自燃率这么高?车主将电池拆开:终于找到关键原因

- 去年全国新能源车火灾事故3000起!车主是在玩命?

- 碾压大众、本田、特斯拉,冲入世界500强的比亚迪卖爆了!

- 平均每天烧10辆,新能源车起火事故频发,开电车到底安不安全?

- 重要榜单公布,中国车企碾压美日德!比亚迪第二,前20中企占12

- 特斯拉和瑟尔早就找到了免费能源?却被禁止使用?有什么隐情?