|不要用自动驾驶考验人性

文章图片

图1/4

欢迎关注“新浪科技”的微信订阅号:techsina

文/李贤焕

来源:20社(ID:quancaijing_20she)

自动驾驶解放人类驾驶员 , 还有很长一段路要走 。 对于专业人士 , 这一直是常识 。 可惜 , 他们没有让用户也真正认清这一点 。

不久前 , 在北京亦庄试车场试乘百度Apollo自动驾驶出租车时 , 随车安全员忍不住对20社吐槽:监督它开车 , 比我自己开车累太多了 。 作为专业试车员 , 他的眼睛一刻也不敢离开前方的道路 。

安全员最重要的职责 , 就是保证车辆在行驶过程中的安全 。 过程中 , 车会自己开 , 但安全员双手要长时间保持在方向盘旁边 , 做好随时接管车辆的准备 , 多数情况下 , 安全员时刻保持同一个姿势 , 可能十几分钟、几十分钟才需要介入驾驶 , 但却需要持续保持注意力集中 。 预判可能的危险 。

【|不要用自动驾驶考验人性】这种挑战人性的工作当然不能靠自驱 。 他指了指面前一个摄像头 , 正是为了时刻监督他的工作 。

这是目前自动驾驶领域 , 人和机器的交互中的矛盾点:系统越智能 , 人就越不需要参与 , 但人越少参与 , 就越难集中注意力 。

当系统出问题 , 遇上了驾驶员不专注 , 意外就可能发生在双方都没介入时的控制盲区 。

8月14日 , 美一好品牌管理公司在其公众号上发布了一条消息 , 称两天前的8月12日下午2时 , 创始人林文钦驾驶着一辆蔚来ES8行驶在沈海高速上 , 在自动驾驶功能(NOP领航状态)模式下发生车祸 , 在距离莆田市不远的涵江段发生车祸 , 不幸去世 , 终年31岁 。

事故发生后 , 自动驾驶功能是否安全成为行业讨论话题 。 蔚来则在后续的回应中强调:NOP(Navigate on Pilot)领航辅助不是自动驾驶 。

目前市场上所有的车企开放的功能均属于辅助驾驶 , 根据之前案例 , 通常车主对最终的驾驶行为负责 。 但一位年轻车主离去 , 还是敲响了行业警钟:辅助驾驶安全吗?消费者能用好它吗?车企是不是还能做得更多?

文章图片

图2/4

图片:CFP

安全 , 还是不安全?

汽车行业是在上百年的技术进步和无数次事故当中 , 积累起如今的安全标准和工程经验 。 如今车祸虽然还是难以避免 , 但这几年在行业的剧烈变革当中 , 单一的事故也可能成为影响行业发展的节点 。

在自动驾驶领域 , 2018年3月 , Uber的一辆自动驾驶测试车辆在美国路测时发生严重交通事故 , 导致一名49岁的女性死亡 。 事故调查显示 , 车辆碰撞时它处于完全自动驾驶模式 , 安全员坐在驾驶位上玩手机 , 未及时进行人为干预 。

事件发生后 , Uber紧急暂停了道路测试 , 同时也为热得发烫的自动驾驶行业破了一盆冷水 , 行业和外界广泛认识到了自动驾驶技术面临的挑战 。 事故后 , 自动驾驶开始经历行业的第一次寒冬 。

类似的事情 , 蔚来也深有体会 。 2019年6月 , 因出现多起车辆自然事件 , 蔚来在调查后正式召回4803台ES8车辆 , 以消除安全隐患 。

召回带来的额外成本是一回事 , 后来李斌自己表示 , 起火事件直接影响了资本对新能源行业的信心 , 融资四处碰壁 。

那段时间的李斌 , 被称为2019 最惨的人 , 而蔚来融资不顺 , 也让小鹏、理想汽车等一票友商难以通过常规融资渠道找钱 。

如今 , Uber卖掉了整个自动驾驶部门 , 正式退出了赛道 , 迈过了寒冬的自动驾驶行业已经走到了新阶段 。 熬过了最艰难的2019 , 走出了泥潭的蔚来也成为新造车里的明星代表 。

在此次事故前 , 类似的交通事故发生了不止一次 , 涉及到的车企也不止蔚来一家 。

以至于在行业人士看来 , 尤其是静止停放的工程车、白色卡车 , 是辅助驾驶系统的典型“杀手” 。

2018年1月 , 一辆特斯拉在美国加州以Autopilot模式下撞上了一辆消防车;2019年 , 一辆特斯拉撞上停靠状态下的警车;2020年6月 , 一辆特斯拉Model 3撞上一辆侧翻的白色货车 。

今年1月 , 一辆蔚来ES8在一个高速公路上 , 在NOP模式下撞上了一辆停在快车道的五菱宏光 , 前后两车均变形严重 , 所幸没有人员伤亡 。

蔚来汽车在车主手册上明确写道 , “领航辅助”是一个舒适性功能 , 而非防碰撞功能 。 当本车与前车相对车速大于50公里/小时时 , 如前车静止或缓行 , “领航辅助”存在无法刹停的风险 。

从技术角度理解 , 类似的通过摄像头、毫米波雷达作为传感器的辅助驾驶系统 , 很大一部分也都存在类似的风险 。

此次车主不幸丧生 , 敲响了行业的警钟:普通车主是不是真的意识到了辅助驾驶系统的风险?

自动驾驶、辅助驾驶作为一项面市没有太久的技术 , 产品功能仍在持续更新和完善当中 , 公众的理解很难说得上成熟 。

文章图片

图3/4

李想发文

8月16日 , 理想汽车创始人兼CEO李想在朋友圈发文 , 呼吁媒体和行业机构统一自动驾驶的中文名词的标准 , 避免夸张的宣传造成用户使用的误解 。

他表示 , 最大化的控制期望值 , 避免自动和辅助出现在同一个状态下 , 辅助驾驶就是人的责任 , 出现自动两个字就是车的责任 。 “在推广上克制 , 在技术上投入 , 对用户、行业、企业都长期有利 。 ”

前不久刚投资了哪吒汽车入局造车领域的周鸿祎也公开表示 , 人工智能不是营销话术 , 没有那么神奇 , 自动驾驶、无人驾驶还有很多路要走 , 很多坑要填 , 不能为了营销误导用户 。 ”

两人的发言 , 都指向了行业在推广自动/辅助驾驶技术的过程中 , 车企存在过度营销的现象 , 和公众的对话并不充分 。

按照分类的话 , 我们在市面上所能买到的车 , 搭载的驾驶系统都属于:辅助驾驶系统 。

但如果所有人都只说“辅助驾驶” , 听起来确实好像没那么厉害 。 一方面 , 车企不断引入AP、FSD、NOP这样的英文缩写 , 把自家技术区别与市面上别家的产品 , 同时 , 不断把L2、L2.5、L2.5+的技术定义交给消费者 。

消费者认知不断复杂化 , 最终的结果就是让更多人云里雾里地认识到某家技术好像真的比较厉害 。

但过度营销的风险也随之而来 , 而风险的背后 , 可能就是事故 , 可能就是生命 。

这一点上 , 特斯拉最为典型 。 行业普遍认为 , 特斯拉在辅助驾驶技术上领跑汽车行业 。 但把这个饼画得又大又圆 , 也是马斯克的臭毛病 。

特斯拉把自己的驾驶系统称为AutoPilot(自动驾驶) , 甚至还有FSD(完全自动驾驶能力) 。 特斯拉一系列致死事故后 , 马斯克才终于改口 , 表示不该将特斯拉的Autopilot解读为自动驾驶 。

巧合的是 , 特斯拉也因辅助驾驶安全问题被调查 。 北京时间16日晚 , 美国国家公路交通安全管理局(NHTSA)发布文件称 , 由于发生多起特斯拉与停放的紧急车辆相撞事故 , 已经开始对特斯拉Autopilot正式展开调查 。 NHTSA表示 , 自2018年1月起 , 已确认特斯拉发生了11起相关事故 , 造成17人受伤 , 1人死亡 。

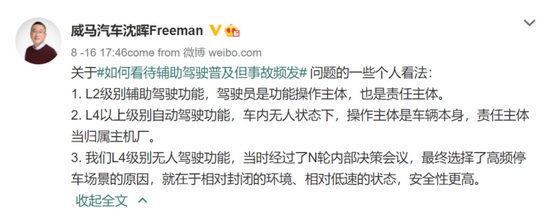

在李想、周鸿祎下场之后 , 这场争论还在继续 , 威马CEO沈晖也跳了出来 , 提出“三点个人意见”的同时 , 还顺手带出了自家“L4级别无人驾驶功能” 。 仅看这三个人自说自话的样子 , 共识也许不会来的这么快 , 不过行业里对于“自动驾驶”能力的过度宣传 , 或许能得到改善 。

文章图片

图4/4

沈晖发文

“有人敢吹 , 有人敢信”

从蔚来和一众新势力造车开始 , 自动驾驶就是各家的宣传重点 。

虽然所有人都不会期待真正的自动驾驶能够在短期实现 , 然后拿掉油门、方向盘 , 人类从此不需要驾照 。

但参考特斯拉的发展经历 , 在部分路况下让机器接管 , 是可行的 。 早在2017年底 , 蔚来首款量产车型ES8发布 , 当时的李斌就重点介绍了蔚来的自动辅助驾驶系统NIO Pilot 。

饼可以先画 , 功能再一点一点慢慢实现 ,

随后蔚来是采取硬件预装 , 然后再逐步升级软件 , 实现具体功能 。 2018年加入自动紧急刹车功能;2019年6月 , NIO Pilot在更新中新增了7项功能 , 包括高速自动辅助驾驶、拥堵自动辅助驾驶、转向灯控制变道、道路交通标识识别、车道保持功能、前侧来车预警、自动泊车辅助系统 。

2020年 , NIO Pilot系统新增自动紧急制动(AEB)、自动辅助导航驾驶功能(NOA)等功能 , 以及今年的全自动泊车、车辆近距离召唤等等功能 , 都是在辅助驾驶的范围内 , 不断丰富具体场景和功能 , 提升智能化程度 。

发现问题了吗 , 所有这些技术名称 , 都是将自动和辅助放在了一起 , 实质上在面向大众时很容易混淆彼此 。

而行业在不断强调“智能”“自动”的同时 , 不仅传递了过分乐观的表态 , 同时也混淆了自动驾驶和辅助驾驶的区别 。

公司说:这是自动驾驶 。 车主:好的 , 意思就是车会自己开 。

公司说:这是辅助驾驶 。 车主犹豫一下:好吧 , 还算是我开 , 系统就是帮我个忙 。

然后又有公司说:这是自动辅助驾驶 。 车主:???

比如 , 在林文钦的生前朋友圈和讣告里 , 出现的字样都是“自动驾驶” 。 而事实上 , 市面上所有的驾驶系统都属于辅助驾驶系统的范围 。

此外 , 虽然在蔚来车主手册中有写道 , “领航辅助”Beta 版本为公开测试版本 , 功能尚处于持续优化阶段:驾驶员双手不能离开方向盘、视线不能离开行驶道路 。

功能很强大 , 故事很性感 , 但车主真的关注和理解到说明书上的一系列风险提示和责任条款吗?未必 。

比如2019年8月蔚来副总裁沈斐在微博上发布了一段小视频 , 表示蔚来自动辅助驾驶系统越来越上瘾 , 1点半会议结束 , 在自动辅助驾驶帮助下 , 放心地边吃东西边开车 。

在不断强调辅助驾驶能力的同时 , 自动驾驶与辅助驾驶的区别 , 在各种花哨的解释下开始模糊 。

全国乘用车市场信息联席会秘书长崔东树认为 , 目前业内常用的L0-L5的分类标准 , 是在技术路线层面的分类 , 但这并并不等于是产品标准 。

产品标准应该简单分为两类 , 第一种就是以人驾驶为核心的车辆 , 车辆的功能为人服务 , 但驾驶员仍为驾驶行为负责 。 第二种是以系统驾驶为核心 。 即人不参与到驾驶当中 , 责任就在于系统 。

目前 , 这一领域法规已经在完善当中 。 8月12日 , 工信部发布《工业和信息化部关于加强智能网联汽车生产企业及产品准入管理的意见》 , 其中提出 , 生产具有驾驶辅助和自动驾驶功能的车辆时 , 应当明确告知车辆功能及性能限制、驾驶员职责、人机交互设备指示信息、功能激活及退出方法和条件等信息 。

《意见》明确企业应当建立自查机制 , 发现产品存在数据安全、网络安全、在线升级安全、驾驶辅助和自动驾驶安全等严重问题的 , 应当依法依规立即停止相关产品的生产、销售 , 采取措施进行整改 , 并及时向相关部门报告 。

克服人性的弱点

人开车还是机器开车 , 从技术角度很容易划分 , 即系统介入状态下是机器开车 , 退出状态下由人完全掌控 。 但实际应用里并不容易划分 。

辅助驾驶可以控制方向——接管了方向盘 , 可以控制加减速——接管了油门和刹车 。 但辅助驾驶模式依然要求驾驶员保持全程注意力 , 要求驾驶员眼睛和脑子时刻在线 , 这并不容易 。

一般来说 , 越智能的驾驶系统 , 越能应对更多的场景 , 具体的使用感受体现为车辆可以在更长的时间里自己跑 , 不会时不时就退出辅助驾驶模式 , 动不动就把驾驶员喊回来接管方向盘和油门 。

矛盾就产生了 。 从驾驶行为上来说 , 长时间固定的驾驶行为会造成驾驶员精神处于抑制状态 , 缺少刺激产生疲劳 , 反应时间变长 , 遇到突发情况 , 更难及时反应 。

比如我们都知道高速公路通常是有一定的弯道 , 除了因为地形原因不一定能修得笔直 , 这也是让驾驶员保持专注的方法 。 弯道要求驾驶员一直小幅度操作方向盘 , 让驾驶员时刻注意到路况 。

所以 , 辅助驾驶一边通过接管车辆 , 卸下驾驶员的负担 , 另一头也难以避免的增加了驾驶员分心的可能性 。

当机器出现误判 , 驾驶员同时又没有关注路面情况时 , 事故就容易发生 。

但长时间不用操作 , 当然容易让驾驶员分心 。

2013年 , 自动驾驶领域的老大哥Waymo(当时为谷歌的自动驾驶部门)邀请了一批内部员工参与自动驾驶测试 , 开始时大家精神集中 , 不久后就出现了员工在车上睡着的情况 , 有的员工甚至化起了妆 。 这项测试随即被叫停 , 当时的CEO John Krafcik表示 , 当你把这个系统开发得越好 , 人们就越容易过度信赖它 。

资深汽车工程师朱玉龙在一段分享中表示 , 当使用的人越来越多 , 仅仅是教育消费者保持注意力可能是没有用的 。 只要车主觉得辅助驾驶系统好用 , 就会越用越多 , 开始时可能车主会喝个水、吃点东西 , 后面就可能开始出现打盹、睡觉的现象 。

前华为自动驾驶负责人苏箐曾在人工智能大会上提到 , 用户在面对新技术时 , 最开始倾向于完全不信任 , 而在试用并感到满意后会完全信任 , 而事故往往从这个阶段开始发生 。

人和机器在这时候就出现了循环监督的情况 。 要保证辅助驾驶安全 , 需要驾驶员集中精力 , 要让无聊的驾驶员集中精力 , 还需要一套系统持续监督驾驶员 。

朱玉龙表示 , 要尽可能保证安全 , 还有一个环节是通过摄像头等传感器 , 检测车主是否在认真开车 , 即目前的DMS系统 , 车企有责任在辅助驾驶系统里 , 搭配足够的传感器和算法 , 在发现分心的第一时间提醒车主 , 让其保持注意力 。

这点亦有法规支持 , 工信部发布的《关于加强智能网联汽车生产企业及产品准入管理的意见》也表示 , 企业生产具有组合驾驶辅助功能的汽车产品的 , 应采取脱手检测等技术措施 , 保障驾驶员始终在执行相应的动态驾驶任务 。

推荐阅读

- 功能|小米 Watch S1图赏:商务气质新系列,稳步入场不急切

- 年轻人|人生缺少的不是运气,而是少了这些高质量订阅号

- 年轻人|呼叫全城玩家,魔都首发「表情包地铁」启程,2022蓝不倒!

- 最新消息|中围石油回应被看成中国石油:手续合法 我们看不错

- 测试|北京:自动驾驶测试里程突破365万公里

- 华依|中信证券:惯性导航有望成为L3及以上自动驾驶的标配产品

- 爆发|中信证券:自动驾驶渐行渐近,惯性导航刚需爆发

- Apple|法官称苹果零售店搜包和解协议虽不完美,但可继续进行

- Insight|太卷了!太不容易了!

- 视点·观察|科技行业都在谈论“元宇宙”,可是它还不存在