机器之心报道

机器之心编辑部

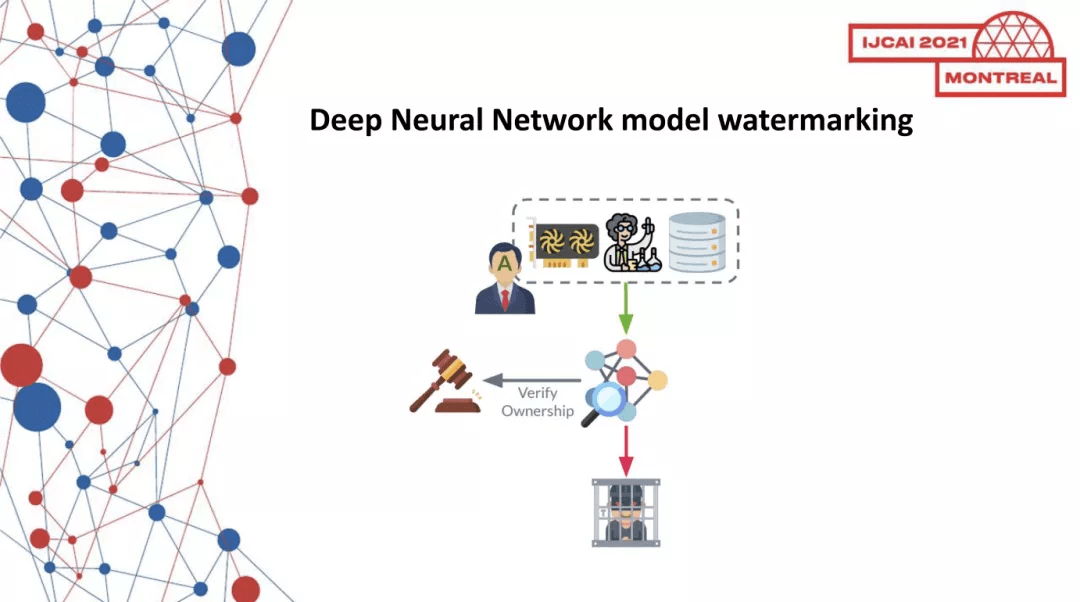

在刚刚结束的 IJCAI 2021 大会上 , 「深度学习模型知识产权保护国际研讨会(DeepIPR-IJCAI’21)」正式举行 , 这场研讨会由微众银行、马来亚大学、香港科技大学、上海交通大学共同主办 。

文章图片

机器学习 , 尤其是深度神经网络(DNN)技术 , 近年来在诸多领域取得了巨大成功 , 许多科技公司都将神经网络模型部署在商业产品中 , 提高效益 。 训练先进的神经网络模型需要大规模数据集、庞大的计算资源和设计者的智慧 。 这具体体现在:(1)深度学习模型应用的训练模型规模巨大 , 以 GPT-3 为例 , 其预训练所用的数据量达到 45TB , 训练费用超过 1200 万美元 , 有着极高的经济成本(2)深度学习模型在训练部署到工业应用场景过程中(比如智慧金融 , 智慧医疗应用) , 需要引入金融、医疗等领域专有先验知识 , 因此在模型设计过程就需要引入专家的知识和经验来订制模型 , 这体现了人脑力的知识产权 。 (3)深度学习模型的训练过程 , 需要特定领域的海量数据作为训练资源 , 存在数据本身价值和知识属性 。 以上属性决定了经过训练的深度学习模型具有很高的商业价值和知识属性 , 必须将其纳入合法所有者(即创建它的一方)的知识产权 。 因此 , 从技术上迫切需要保护深度神经网络(DNN)模型不被非法复制、重新分发或滥用 。

文章图片

深度学习模型知识产权保护问题 , 是一个跨学科的综合性议题 , 涉及计算机安全 , 人工智能理论与方法、知识产权保护、法律等诸多方面 。 深度学习模型的盗用、非法复制、分发等 , 攻击者可以采用技术手段或者非技术手段;但要确认盗用且声明模型所有权 , 则是完全从技术端来提取证据 , 以便从法规的角度来认证模型所有权 。 具体而言 , (1)从计算机安全角度出发 , 技术手段需要采取密码学可信的协议 , 来保证模型的知识产权验证和发布过程是严密可信的;(2)从人工智能理论方法角度出发 , 模型的所有权认证技术需要保证不牺牲模型可用性前提下 , 提供可靠且鲁棒的知识产权保护方法;(3)在法规层面 , 从技术端对模型所有权提取证据之后 , 这些证据能成为模型所有权的依据 。 最终监管方要通过法规的保护 , 来裁定模型所有者的知识产权 , 这需要相关法规来指导如何从技术判据 , 来判定模型所有权 。 据笔者所知 , 目前尚未有相关的立法具体到深度学习模型知识这一子领域 , 模型知识产权保护不仅需要科技工作者的参与 , 也需要知识产权保护领域工作者的关注和努力 。

本次研讨会定位于深度神经网络知识产权保护研究的前沿 , 展示研究机构及高校实验室在此领域进行的最前沿的工作 。 分别来自德国、芬兰、马来西亚和中国的 8 位学者 , 就深度学习模型知识产权保护问题 , 从算法、协议、安全等多个角度出发 , 分享了他们对模型知识产权保护的思考和工作 。

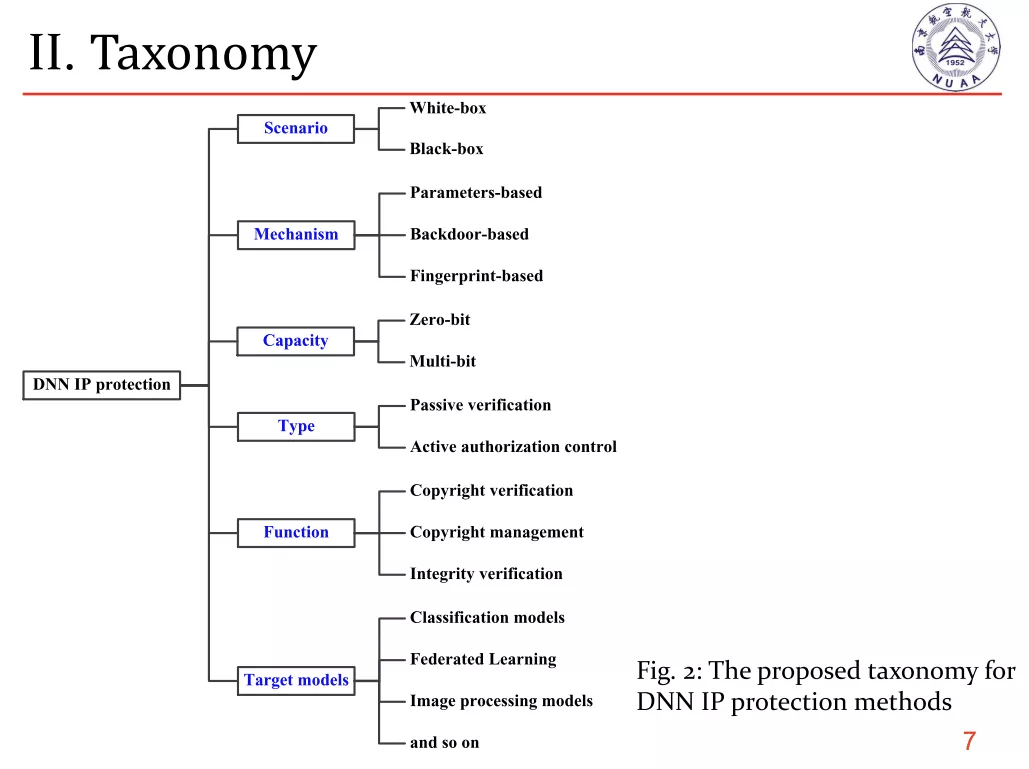

在 Talk 1 中 , 南京航空航天大学的薛明富老师带来了《DNN Intellectual Property Protection: Taxonomy, Attacks and Evaluations》的主题讲座 , 他对深度学习模型保护方法进行了分类性的总结 , 从模型场景、保护机制、保护能力、目标模型等维度 , 对模型知识产权保护研究进行了梳理 , 并且总结了针对已有的方法 , 存在的攻击和挑战 , 并给出了系统评估的相关建议 。 这场讲座为模型保护领域总结了研究现状和发展脉络 。

文章图片

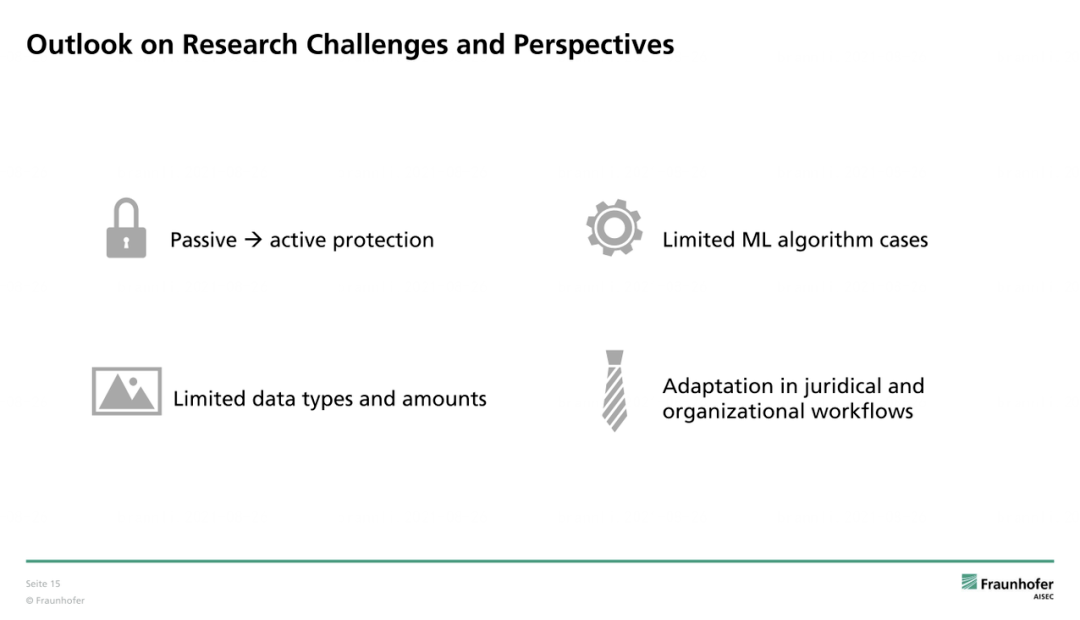

来自德国 Fraunhofer AISEC 研究院的 Franziska Boenisch , 同样针对神经网络水印技术分享了视角下的模型知识产权保护的综述研究工作 。 Franziska 从神经网络水印技术的需求、算法应用、威胁模型等角度回顾了现有的研究工作 , 以神经网络水印技术的可用性、鲁棒性、可靠性、完整性等要求为主线 , 串联回顾了已有的模型水印研究 , 指出了现有的研究存在几大待解决的问题 , 包括缺乏主动保护机制 , 算法数据类型案例有限和司法保障和技术研究并轨 。

文章图片

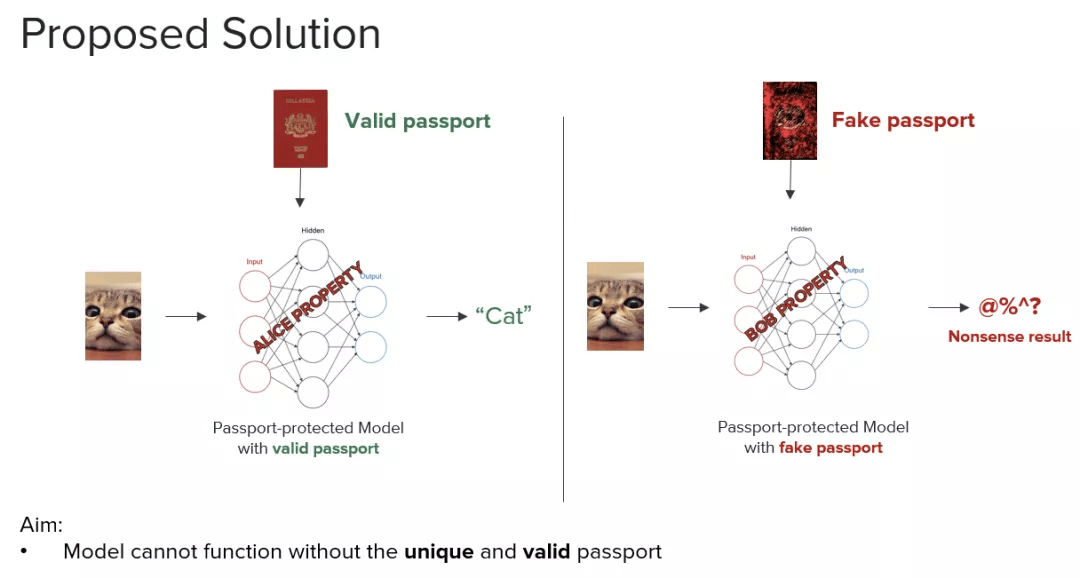

作为深度学习模型知识产权保护的资深研究者 , 毕业自马来亚大学以及微众银行 AI 项目组算法研究员 Kam Woh Ng 分享了他所提出的用数字护照保护模型知识产权的方法 。 Kam Woh Ng 分析了神经网络模型知识产权保护的相关研究的最新进展后发现 , 一种旨在通过伪造水印来对所有权验证产生疑问的模糊攻击 , 对多种基于水印的 DNN 所有权验证方法对 DNN 的知识产权保护构成了严重威胁 。

针对上述安全漏洞 , Kam Woh Ng 提出了一种新颖的基于数字护照的 DNN 所有权验证方案 , 该方案既对网络剪枝及微调等修改具有鲁棒性 , 又能够抵御模糊攻击 。 嵌入数字护照的关键在于 , 以一种巧妙的方式设计和训练 DNN 模型 , 从而使原 DNN 的工作性能在使用伪造护照时大大降低 。 也就是说 , 真正的数字护照不仅可以依据预定义的数字签名来进行验证 , 而且还可以根据 DNN 模型的工作性能来认定 。 Kam Woh Ng 详细分享如何使用数字护照保护 DNN 以及抵御模糊攻击 。

文章图片

Kam Woh Ng 的 Passport 模型保护方法提供了一大类通用的模型保护思路 , 在本次研讨会中 , 还有其他研究者也分享了模型水印方法具体应用在图像生成、图像概述等模型中的工作 。

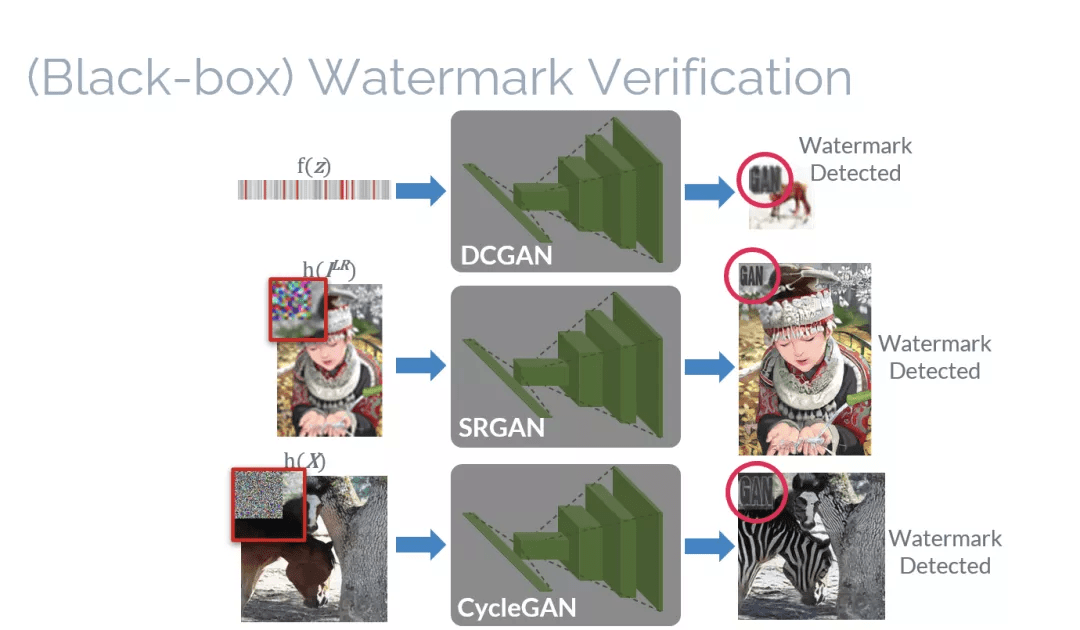

来自马来西亚马来亚大学的 Ding Sheng Ong , 针对图像生成深度学习模型 , 分享了题为《Protecting Intellectual Property of Generative Adversarial Networks From Ambiguity Attacks(GAN 的知识产权保护方法)》的讲座 。

虽然目前已有用于卷积神经网络(CNN)的 IPR 保护方法 , 但是却不能直接使用在生成对抗网络(GANs)——另一种被广泛用于生成逼真图像的深度学习模型 。 因此 , 本文提出了一种基于黑盒与白盒的 GAN 模型 IPR 保护方法 。 实验结果表明 , 本方法并不会损害 GAN 本来的性能(如图像生成、图像超分辨率以及样式转换) 。 本方法也能够抵御去除嵌入的水印(removal)和模糊(ambiguity)攻击 。 分享中解说了如何基于黑盒与白盒的方式保护对抗生成网络(GANs) , 以及如何抵御各种水印攻击 。

文章图片

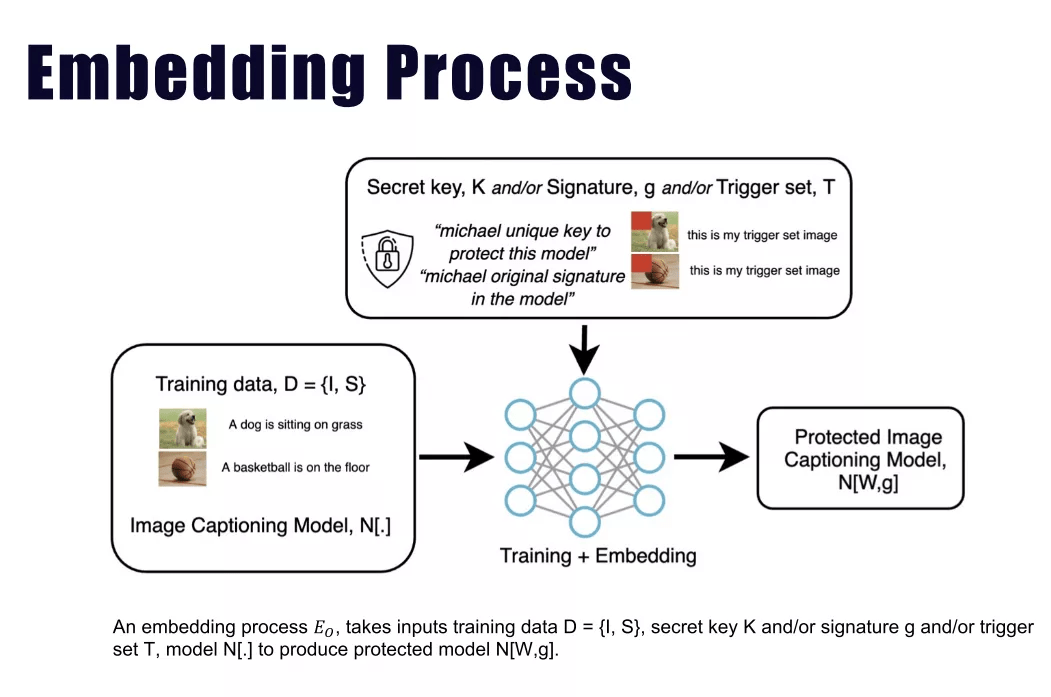

来自马来西亚马来亚大学的 Jian Han Lim, 针对图像标注(image caption)神经网络模型 , 带来了题为《Protect, Show, Attend and Tell: Empower Image Captioning Model with Ownership Protection》的分享 。 Jian Han Lim 指出 , 现有的深度神经网络知识产权 (IPR) 保护通常 i) 仅专注于图像分类任务 , 以及 ii) 遵循标准的数字水印框架 , 该框架通常用于保护多媒体和视频内容的所有权 。 Jian Han Lim 论证了当前的数字水印框架不足以保护通常被视为人工智能前沿之一的图像标注任务 。 作为补充 , 本文研究并提出了在循环神经网络中的两种不同签名水印嵌入方案 。 从理论和经验的角度来看 , 其证明伪造的密钥会产生无法使用的图像标注模型 , 从而阻止了侵权的违规行为 。 该工作是第一个对图像字幕任务提出所有权保护的工作 。 此外 , 大量实验表明 , 所提出的方法不会影响 Flickr30k 和 MS-COCO 数据集上所有通用字幕指标的原始图像标注任务性能 , 同时它能够承受去除攻击和歧义攻击 。

文章图片

针对深度学习常见任务和模型 , 已有上述所示多种神经网络保护算法案例提供算法支撑 。 那么如何设计可行的通信协议 , 指导模型所有权验证的实际执行?

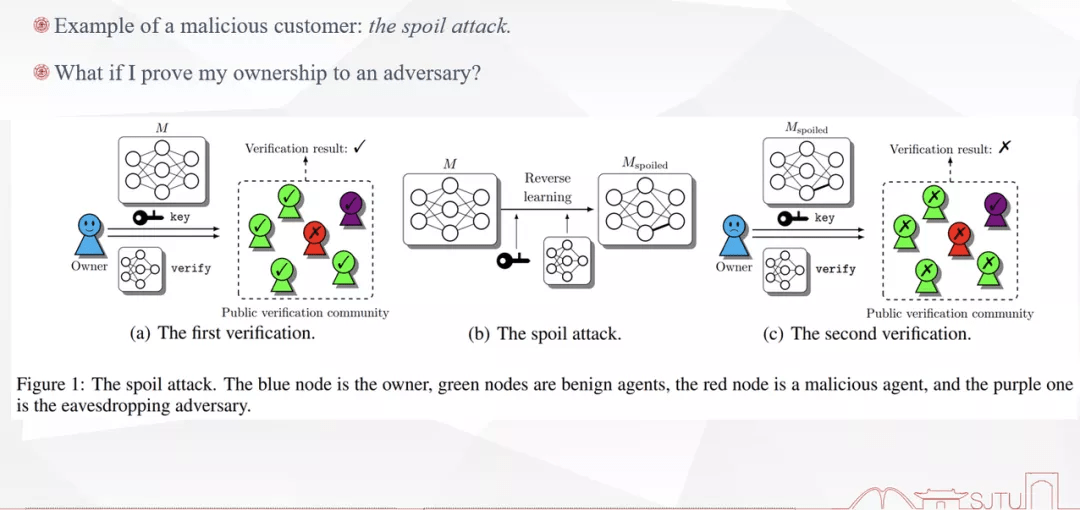

来自上海交通大学的李方圻针对模型所有权验证的场景、协议和前景进行了题为《Regulating Ownership Verification for Deep Neural Networks: Scenarios, Protocols, and Prospects》的分享 。

李方圻介绍说 , 随着深度神经网络的广泛应用 , 将其作为知识产权加以保护的必要性变得显而易见 , 研究者已经提出了许多水印方案来识别深度神经网络的所有者并验证所有权 。 然而 , 大多数研究都专注于水印嵌入而不是可证明验证的协议 , 为了弥合这些建议与现实世界需求之间的差距 , 李方圻介绍了三种场景下的深度学习模型知识产权保护:所有权证明、联邦学习和知识产权转移 , 展示了已建立的密码原语和人工智能设置之间的结合 , 这可以构成实用且可证明的机器学习安全性的基础 。

文章图片

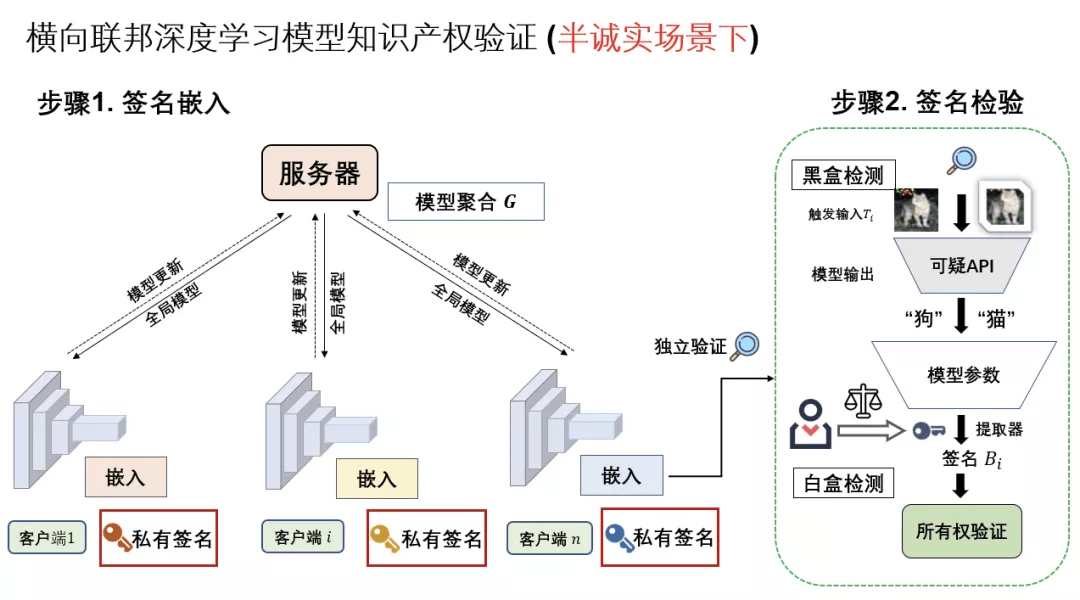

已有的深度学习模型知识产权保护方法主要着眼于深度神经网络水印的算法实践和鲁棒性挑战 , 目前没有把模型水印算法实践到分布式神经网络训练的研究 。 来自上海交通大学以及微众银行 AI 项目组的李博闻带来了题为《联邦深度学习模型所有权保护》的讲座:考虑一个不完全信任的联邦学习系统中 , 假定各参与方能够按照联邦法则来进行模型更新和协同训练 , 但彼此不泄露私有本地数据和私密签名 。 在这种设定下 , 李博闻阐述了一种新颖的联合深度神经网络 (FedDNN) 所有权验证方案 , 该方案允许嵌入和验证所有权签名 , 以声明 FedDNN 模型的合法知识产权 (IPR) , 以防模型被非法复制、重新分发或滥用 . 嵌入式所有权签名的有效性在理论上是通过证明的条件来证明的 , 在这种条件下 , 签名可以被多个客户端嵌入和检测 , 而无需公开私人签名 。

文章图片

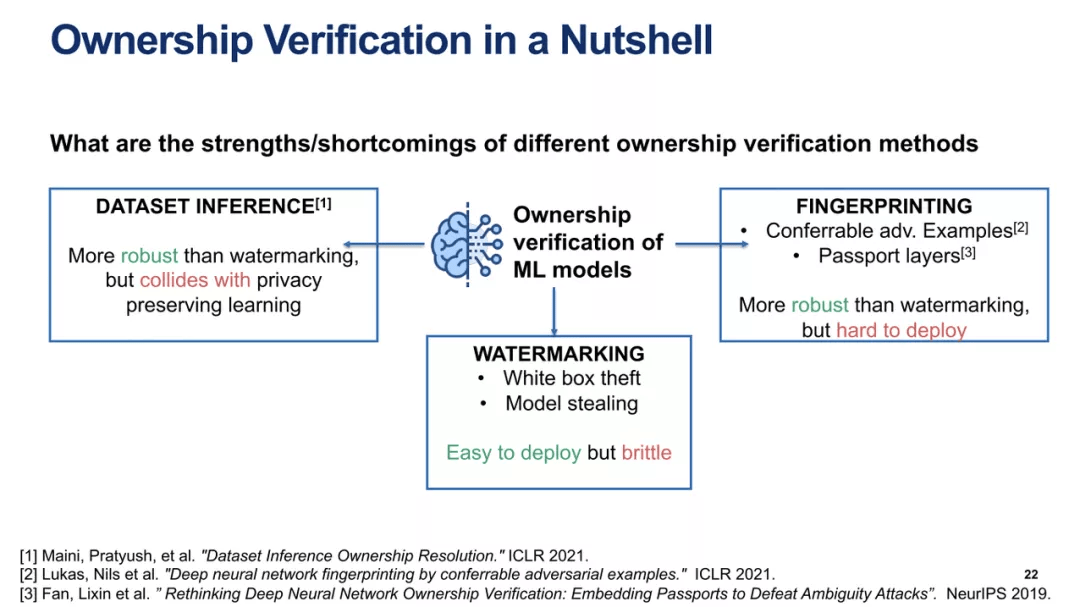

最后 , 来自芬兰 Aalto 大学的 Buse Atli 带来了题为《Model Stealing and Ownership Verification of Deep Neural Networks》的综合性分享 。 最近的一些工作表明 , 从技术的层面 , 人们暂时无法完全阻止深度学习模型窃取攻击 , 不同的模型窃取检测预防机制要么无法对抗强大的敌手 , 要么对模型性能和良性用户的效用产生负面影响 。 因此 , 模型所有者可以通过证明被盗模型的所有权来减少此类攻击的动机 , 而不是防止模型被窃取本身 。 已经提出的各种模型水印方案被广泛用于可靠的所有权验证 , 水印深度神经网络(DNN)引起了学术界相当大的研究兴趣(尤其是在图像分类方面) , 因为深度学习模型水印易于部署并且对模型性能的影响可以忽略不计 。 并且 , 学术界针对 DNN 水印技术提出了许多不同的攻击方法 , 从而对其鲁棒性提出了质疑 。

在本次演讲中 , Buse 介绍了针对不同模型窃取攻击、动态对抗性水印 (DAWN) 作为对模型窃取的威慑以及联邦学习中模型水印技术 (WAFFLE) 的相关工作 , 以根据不同的安全和隐私要求对这些方法进行分析 。

文章图片

聚集顶尖学者 , 关注深度学习模型知识产权保护领域 , DeepIPR-IJCAI’21已成为全球模型保护领域最前沿的学术动态窗口 。 以科技手段解决时代难题 , 多位行业领军者的干货分享 , 一定能够成为当下时代模型知识产权保护领域最有力的助推器 。

讲座视频回顾及更多信息可查看研讨会官网或者B站

- 官网:http://federated-learning.org/DeepIPR-IJCAI-2021/

- B站:https://www.bilibili.com/video/BV1PP4y1W7nS

推荐阅读

- MateBook|深度解析:华为MateBook X Pro 2022的七大独家创新技术

- 问答|紧追B站加码知识类内容,抖音上线“学习频道”

- Siamese|一个框架统一Siamese自监督学习,清华、商汤提出简洁、有效梯度形式,

- 技术|探秘AI智慧之旅,科大讯飞AI学习机研学游第一期圆满落幕

- 人物|最有深度的8个公众号,你关注了吗

- 材料|别在玩吃鸡,小学生都开始学习3d打印技术了

- 字节跳动|抖音上线学习频道,为知识内容增加一级入口

- 数据|抖音上线学习频道,位于一级入口

- 国际|特奖得主任队长,清华夺冠NeurIPS 2021国际深度元学习挑战赛

- 深度|小米真无线降噪耳机 3 Pro 新年特别版即将发布,带来全新配色等