switch是一种我们在java、c等语言编程时经常用到的分支处理结构 , 主要的作用就是判断变量的取值并将程序代码送入不同的分支 , 这种设计在当时的环境下非常的精妙 , 但是在当前最新的移动SOC环境下运行 , 却会带来很多意想不到的坑 。

出于涉与之前密的原因一样 , 真实的代码不能公开 , 我们先来看以下这段代码:

public class Main {

public static void main(String[] args) {

long now=System.currentTimeMillis();

int max=100,min=0;

long a=0;

long b=0;

long c=0;

for(int j=0;j<10000000;j++){

int ran=(int)(Math.random()*(max-min)+min);

switch(ran){

case 0:

a++;

break;

case 1:

a++;

break;

default:

c++;

}

}

long diff=System.currentTimeMillis()-now;

System.out.println("a is "+a+"b is "+b+"c is "+c);

}

}

其中随机数其实是一个rpc远程调用的返回 , 但是这段代码总是莫名其妙的卡顿 , 为了复现这个卡顿 , 定位到这个代码段也是通过友盟U-APM的卡顿分析找到的 , 想复现这个卡顿只需要我们再稍微把max范围由调整为5 。

public class Main {

public static void main(String[] args) {

long now=System.currentTimeMillis();

int max=5,min=0;

long a=0;

long b=0;

long c=0;

for(int j=0;j<10000000;j++){

int ran=(int)(Math.random()*(max-min)+min);

switch(ran){

case 0:

a++;

break;

case 1:

a++;

break;

default:

c++;

}

}

long diff=System.currentTimeMillis()-now;

System.out.println("a is "+a+"b is "+b+"c is "+c);

}

}

那么运行时间就会有30%的下降 , 不过从我们分析的情况来看 , 代码一平均每个随机数有97%的概念要行2次判断才能跳转到最终的分支 , 总体的判断语句执行期望为2*0.97+1*0.03约等于2 , 而代码二有30%的概念只需要1次判断就可以跳转到最终分支 , 总体的判断执行期望也就是0.3*1+0.6*2=1.5,但是代码二却反比代码一还慢30% 。 也就是说在代码逻辑完全没变只是返回值范围的概率密度做一下调整 , 就会使程序的运行效率大大下降 , 要解释这个问题要从指令流水线说起 。

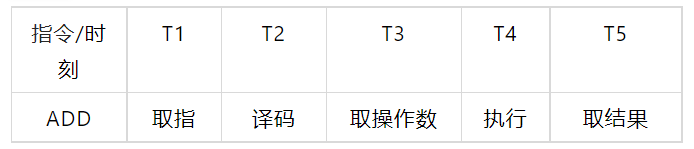

指令流水线原理 我们知道CPU的每个动作都需要用晶体震荡而触发 , 以加法ADD指令为例 , 想完成这个执行指令需要取指、译码、取操作数、执行以及取操作结果等若干步骤 , 而每个步骤都需要一次晶体震荡才能推进 , 因此在流水线技术出现之前执行一条指令至少需要5到6次晶体震荡周期才能完成

文章图片

为了缩短指令执行的晶体震荡周期 , 芯片设计人员参考了工厂流水线机制的提出了指令流水线的想法 , 由于取指、译码这些模块其实在芯片内部都是独立的 , 完成可以在同一时刻并发执行 , 那么只要将多条指令的不同步骤放在同一时刻执行 , 比如指令1取指 , 指令2译码 , 指令3取操作数等等 , 就可以大幅提高CPU执行效率:

推荐阅读

- 产品|产品科研和品牌输出为基准点,雷炎科技建造品牌服务终端能力

- 峰会|TalkingData T11 2021 数据智能峰会线上举办,探寻赋能增长之道

- CBNData|超四成消费者追求家的安全感,家居向全屋智能进阶 |CBNData报告

- 华为|华为墨水屏平板曝光:支持智慧识屏一键接续,超级终端流转文章

- 控制|Azure Database for MySQL Flexible Server上线

- 手机|展锐第二代5G芯片平台实现终端量产,搭载手机明年上市

- 哈曼卡顿|联想 17 英寸 ThinkBook Plus 更多渲染图曝光,运行 Win11

- 哈曼卡顿|明晚发 小米12/Pro带你提前看 | 一加10Pro开启预约

- 智能汽车|22个月,数据驱动“新型终端”驶上新赛道

- 硬件|全国首家终端快充行业协会正式成立