模型|经逆向工程,Transformer「翻译」成数学框架 | 25位学者撰文( 二 )

文章图片

论文地址:https://transformer-circuits.pub/2021/framework/index.html#acknowledgments

该研究发现 , 通过以一种新的但数学上等效的方式概念化 transformer 操作 , 我们能够理解这些小模型并深入了解它们的内部运作方式 。 值得注意的是 , 研究发现特定的注意头 , 本文称之为归纳头(induction heads) , 可以在这些小模型中解释上下文学习 , 而且这些注意力头只在至少有两个注意层的模型中发展 。 此外 , 该研究还介绍了这些注意力头对特定数据进行操作的一些示例 。

各章节内容概览

为了探索逆向工程 transformers 面临哪些挑战 , 研究者对几个 attention-only 的 toy 模型进行了逆向功能 。

首先是零层 transformers 模型的二元统计 。 研究者发现 , 二元表可以直接通过权重访问 。

文章图片

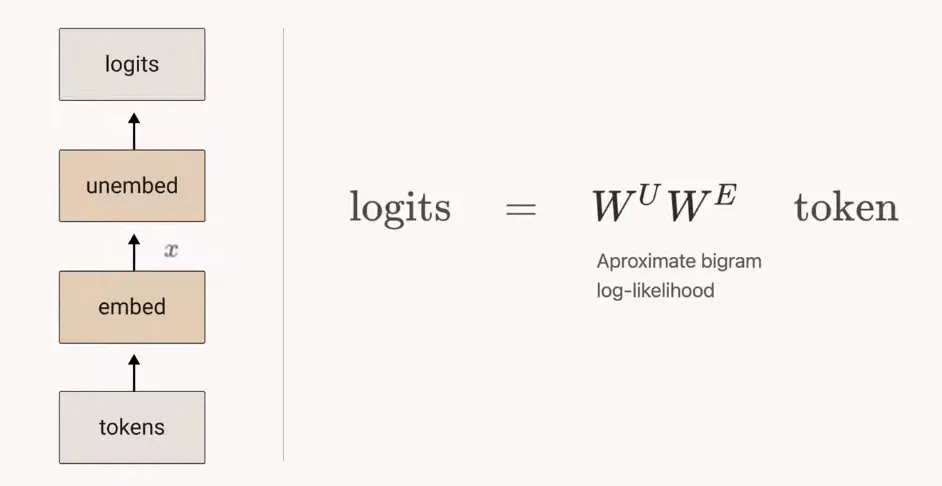

在讨论更复杂的模型之前 , 考虑零层(zero layer)transformer 很有用 。 这类模型接受一个 token , 嵌入 , 再取消嵌入 , 以生成预测下一个 token 的 logits

由于这类模型无法从其他 tokens 传输信息 , 因此只能从当前 token 预测下一个 token 。 这意味着 , W_UW_E 的最优行为是近似二元对数似然 。

文章图片

零层 attention-only transformers 模型 。

其次 , 单层 attention-only transformers 是二元和 skip 三元模型的集合 。 同零层 transformers 一样 , 二元和 skip 三元表可以直接通过权重访问 , 无需运行模型 。 这些 skip 三元模型的表达能力惊人 , 包括实现一种非常简单的上下文内学习 。

对于单层 attention-only transformers 模型 , 有哪些路径扩展(path expansion)技巧呢?研究者提供了一些 。

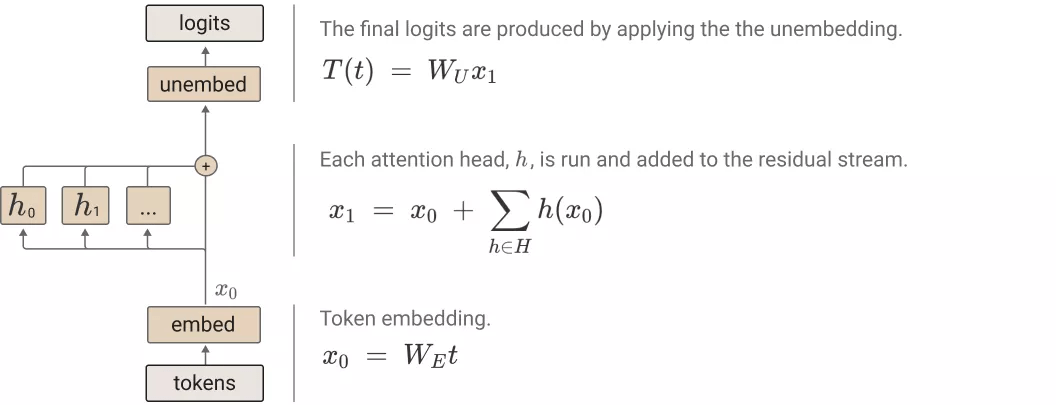

如下图所示 , 单层 attention-only transformers 由一个 token 嵌入组成 , 后接一个注意力层(单独应用注意力头) , 最后是解除嵌入:

文章图片

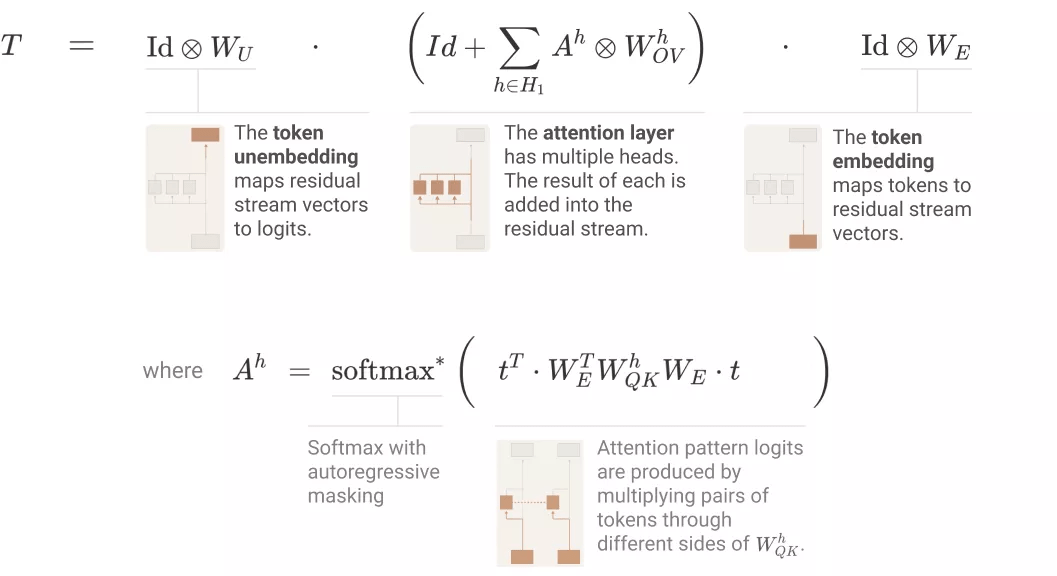

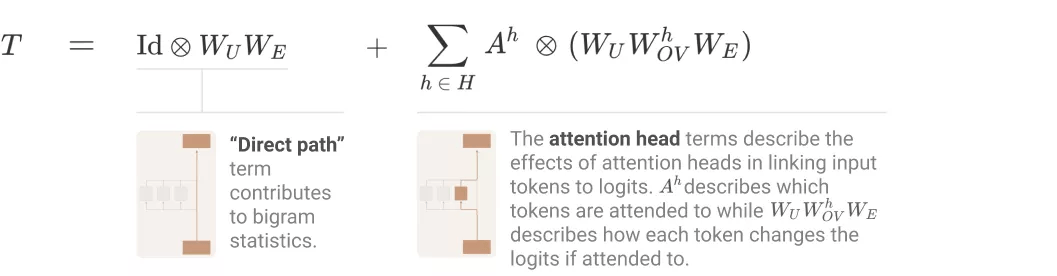

使用之前得到的张量标记(tensor notation)和注意力头的替代表征 , 研究者可以将 transformer 表征为三个项的乘积 , 具体如下图所示:

文章图片

研究者采用的核心技巧是简单地扩展乘积 , 即将乘积(每个项对应一个层)转换为一个和 , 其中每个项对应一个端到端路径 。 他们表示 , 每个端到端路径项都易于理解 , 可以独立地进行推理 , 并能够叠加组合创建模型行为 。

推荐阅读

- 21世纪经济报道|地方政府跑步入局元宇宙 谁能建立先发优势?

- 中新经纬|反向带货还是饥饿营销,瑞幸李国庆互怼伤害了谁?

- 物流|市占率全球第一,引领行业变革,深圳这个独角兽企业分享经验

- 代码|周鸿祎:不理解35岁被职场抛弃,中国人35岁就老了?程序员年纪越大经验越丰富

- 新浪科技|视频|李东生获十大经济年度人物,眼眶湿润 几近哽咽落泪

- 新浪科技综合|中国学者找到新生儿黄疸与空气污染的关系 建预测模型

- 澎湃新闻|“漠河舞厅”商标被经销公司抢注,当前状态为“等待实质审查”

- 科技|华数集团战略合作部·华数传媒网络余浙东总经理参观云针科技

- 21世纪经济报道|荣耀推出首个高端折叠屏手机,京东方、沃特股份亮明合作关系

- 幽门螺旋杆菌|“抗幽牙膏”坑人的“生意经”