机器之心报道

编辑:小舟、力元

当提供更多数据时 , 人们不会做出更好的决定 , 那么为什么假设 AI 会呢?随着人工智能技术的兴起 , AI 中存在的问题也被逐步暴露出来 。 AI 做出的决策与人类最佳决策仍然存在差异 , 并且往往包含一些偏见 。 那么问题出在哪里呢?近日在一篇文章中 , 作者 Marianne Bellotti 阐明了相关原因 , 并提出了自己对 AI 设计原则的看法 。 我们来看一下文章的具体内容 。

越来越多的数据

据专家指出 , 数据科学家花费大约 80%的时间来清洗数据 , 实现由人工智能驱动的集中式决策的关键是打破各项工作之间的壁垒 , 并为人工智能模型创建可互操作的流程 。 在目前的 AI 领域 , 即使花费大量的时间和经济成本 , 也仍然无法实现像人类大脑一样 , 更接近全局水平的态势感知 。 随着数据科学和人工智能的发展 , 构建 AI 模型所需的数据量也在增加 。

自动驾驶公司投资上百亿美元仍然没有实现完全的自动驾驶 , 社交媒体公司投入数十亿美元试图利用 AI 清理不良信息 , 却仍然严重依赖人工清理平台 。

AI 目前尚没有做出最佳决策的能力 。 此外 , 人们在构建 AI 模型时并没有完全消除人为偏见 , 而是试图从越来越多的数据中构建「完美」的 AI 模型 , 但这些数据参差不齐 。

决策与数据的相关性

当试图找到一个难题的解决方案时 , 首先应该将事情分解开来:在做哪些假设?这些假设如何构建需要解决的问题?如果这些假设不同 , 会解决不同的问题吗?想要解决的问题和方案结果有什么关联?对于 AI 来说 , 显然将更好的决策作为结果是非常重要的 。 假设访问更多数据是决策者做出更好决策的关键 , 而更好的决策意味着更少的负面影响 , 那么整体态势感知也非常重要 。

在现实生活中 , 决策者往往为了节约成本而进行优化决策 。 但决策毕竟是根据结果来判断好坏的 , 在正确分析的基础上还需要一点运气 。 在结果出来之前 , 即使是在绝佳数据支持下最仔细、最彻底构建的策略也无法保证决策的绝对正确 。

因此 , 做决策的过程不应该是对数据的客观分析 , 而是利益相关者之间针对风险和优先级的容忍度做出的积极协商 。 数据没有用于提供洞察力 , 而是用作了保护利益相关者免受影响的盾牌 , 完美的信息往往是通过增加噪声水平而降低了决策质量 。

文章图片

这似乎令人难以置信 , 完美的信息不是应该自动改进决策过程吗?实际上 , 更多的信息可能会改变决策背后的组织策略 。 人工智能可以正确识别内容 , 但基于该内容做出的决策会在很大程度上受到用户和组织的规范及期望的影响 。

改进团队决策的最佳途径不是获取更多数据 , 而是改善利益相关者之间的沟通 。 但是人们真的需要花费数十亿美元来清洗数据或增加数据量才能从人工智能中获益吗?

设计不佳的 AI 可能导致巨大的安全风险

当前 , 人们评价数据质量的方式具有误导性 。 「干净(clean)」的数据似乎就是一种准确、无偏见、可复用的数据 。 但实际上 , 干净与准确不同 , 准确与可操作不同 。 数据存在这三个方面的问题就可能严重影响人工智能模型的性能 , 干扰其结果的质量 。 数据中可能存在的问题有很多种 , 有些比较明显 , 例如数据不正确、已损坏或数据格式不标准 。 有些问题则更加微妙 , 例如数据是在特定环境下获取的 , 然后被不恰当地复用;对于模型来说数据处于错误的粒度级别;数据没有标准化 , 导致相同的事实以不同的方式表示或描述 。

使用单一数据源解决上述任何一个问题都会非常困难 , 如果程序攻击者试图向大型系统中注入不良数据以破坏模型 , 那么要解决上述所有问题实际上是不可能的 。 人们无法忽视的一点是:AI 在创造新机会的同时也带来了新的脆弱性 。 人工智能带来了新的攻击与被攻击方法 。 AI 可能会产生新一代攻击工具 , 例如卫星数据干扰欺骗(location spoofing) 。 通过破坏数据来蒙蔽或误导 AI 系统的技术和 AI 技术正在一起被开发 。

文章图片

当前的 AI 系统完全依赖数据的质量 , 因此 AI 存在缺陷不是因为技术不成熟 , 而是因为 AI 最初就被设计为这种容易受到攻击的形式 。 因此在这种情况下 , 人工智能系统必须被设计成能够灵活应对不良数据的模型 。 那么如果改变这种设计以降低 AI 的被攻击风险呢?这就需要让 AI「反脆弱」 。

什么是反脆弱 AI?

「反脆弱」是指 AI 系统不仅可以在遭遇故障后恢复 , 而且在经历过故障后会变得更强大、更有效 。 基于实际改善决策的因素构建 AI 系统将为反脆弱人工智能创造机会 。 现有的认知科学研究表明:良好的决策是主动阐明假设、构建假设检验以验证假设、以及在利益相关者之间建立清晰的沟通渠道的产物 。

许多引发「人为错误」的认知偏差都是上述三方面出现问题的结果:当人们没有清楚地阐明假设时就会使用在实际条件下并不合适的解决方案;当人们不检验假设时 , 他们就无法根据不断变化的条件调整正确的决策;当操作人员之间无法有效地共享信息时 , 就会失去发现不断变化的条件和挑战假设的机会 , 对每个人都不利 。

AI 很容易受到不良数据的影响 , 因为目前的研究过分强调了它在分类和识别方面的应用 , 低估了它在建议和情境化方面的应用 。 但 AI 所做的决策是很容易被破坏的 。

设计反脆弱型 AI 很难 , 因为将算法分析的输出作为结论与将其视为建议或提示之间存在着很大的差异 。 决策者可能会为了节省成本而将人工智能的输出作为结论 。 这是目前在应用人工智能时已经存在的灾难性错误 。

与此同时 , 医学领域的 AI 系统之所以能够提高决策质量 , 是因为许多诊断并没有单一的正确答案 。 在医学诊断中 , 任何一组症状都有一系列不同概率的可能病因 。 临床医生会在他的头脑中建立一个决策树 , 其中包含他能想到的所有可能病因 , 并设想排除某些可能病因的检验测试 。 医学诊断是一个「定义假设、检验测试、进一步缩小可能病因集」的循环过程 , 直到找到解决方案 。

【模型|数据越多,AI越智能?我们一直以来都想当然了】

文章图片

尽管数据不佳 , 但通过提示医生以添加其他可能病因的方式能够加快诊断过程 。 在这种情况下 , AI 能够改善医疗专业人员之间的沟通和知识共享 , 并在关键时刻获取患者的相关信息 。 相反 , 试图通过人工智能技术来区分肿瘤的良性和恶性 , 以超越医生的 AI 产品则一直受到不良数据问题的困扰 。

不良数据下的强大 AI

在利用人工智能这种前沿技术之前 , 研究者和开发者们首先应该思考如何定义要解决的问题 。 如果 AI 被用于改善决策 , 那么 AI 就应该引导决策者进行假设检验 , 而不是试图超越专家 。 如果让 AI 试图超越专家 , 那么它将变得完全依赖于数据的质量 , 从而产生一组程序攻击者能够轻松利用的漏洞 。

当 AI 不是被训练成专家 , 而是改善和支持人类的决策 , 那么 AI 就将对不良数据具有弹性并能够变得反脆弱 。 在这种情况下 AI 不做决定 , 相反 , 它帮助人们阐明决策背后的假设 , 将这些假设传达给人们 , 并在与这些假设相关的实际条件发生重大变化时提醒决策者 。 人工智能可以帮助决策者弄清楚什么状态是可能的 , 或者在什么条件下一些状态是可能的 。 这样的解决方案可以通过解决现有弱点来增强决策团队的整体能力 , 而不是因不良数据产生一些新的弱点 。

人工智能尚未「智能」

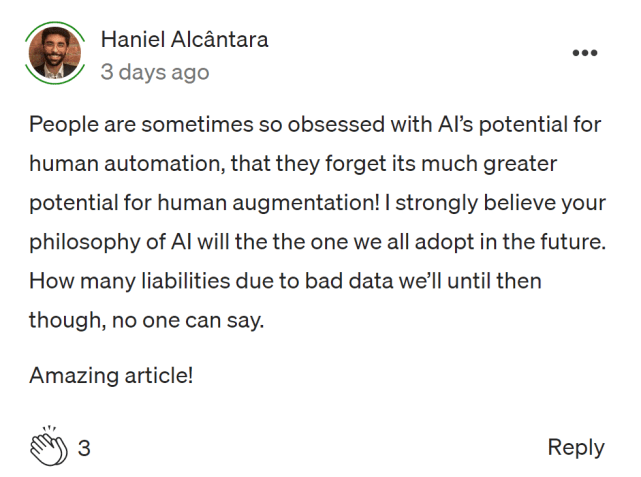

这篇文章发布后 , 许多网友表示赞同作者的观点 。

有网友表示:「这是我近年来读过 AI 主题最明智的文章之一 , 将让一些相关领域的工作者受益 。 」

文章图片

有人则提出了与作者类似的观点:「人们对人工智能在自动化人类工作方面如此着迷 , 以至于忘记了 AI 在辅助人类方面具有更大的潜力 。 」

文章图片

还有网友认为人工智能成功的关键并不是大量的数据 , 而是应该依赖从成功经验中获取的少量数据:

文章图片

此外 , 有网友表示:「人工智能与人类的『智能』无关 , 它实际上只是计算机化的信息 , 仍然需要人们对其进行解析 。 」

文章图片

看来人工智能与真正的完全自治化还有很大的距离 。 对此 , 你有什么看法?

推荐阅读

- 区块|面向2030:影响数据存储产业的十大应用(下):新兴应用

- 选型|数据架构选型必读:2021上半年数据库产品技术解析

- 殊荣|蝉联殊荣!数梦工场荣获DAMA2021数据治理三项大奖

- 数据|数智安防时代 东芝硬盘助力智慧安防新赛道

- 平台|数梦工场助力北京市中小企业公共服务平台用数据驱动业务创新

- 数据|中标 | 数梦工场以数字新动能助力科技优鄂

- 建设|数据赋能业务,数梦工场助力湖北省智慧应急“十四五”开局

- 市民|大数据、人工智能带来城市新变化 科技赋能深化文明成效

- 趋势|[转]从“智能湖仓”升级看数据平台架构未来方向

- 数据|天问一号火星离子与中性粒子分析仪首个成果面世