文章图片

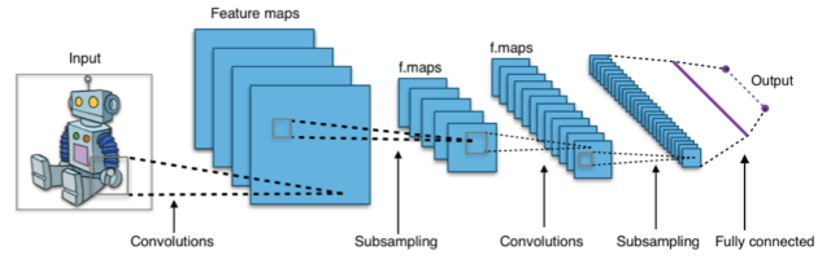

人工神经网络(Artificial Neural Networks)通常由层组成 , 具有许多此类层的网络称为深度学习网络 。 神经网络是机器学习的一种形式 , 是计算机根据经验调整其行为的过程 , 在今天用于自动驾驶、人脸识别等领域 。

康奈尔大学的神经生物学家Thomas Cleland曾说 , 神经形态计算(Neuromorphic Computing)“将成为摇滚明星” , “它不会把一切都做得更好 , 但它将完全拥有计算领域的一小部分” 。

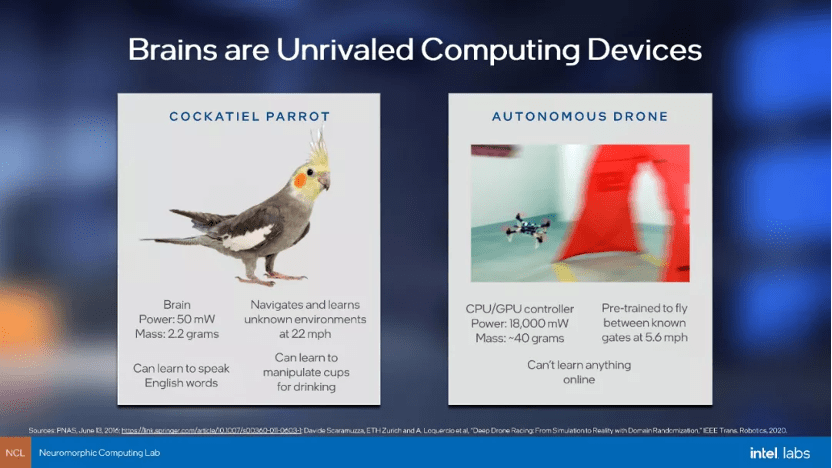

然而模仿大脑的计算成本非常高 , 人脑有数十亿个神经元和数万亿个突触 , 即使模拟一小块大脑也可能需要对每块输入进行数百万次计算 。 运行所有这些小计算并不适合必须一次处理一条指令的经典计算架构(CPU) , 而今天常用的图形处理单元(GPU)仍然没有像大脑那样有效地执行深度学习——人类的大脑可以一边驾驶汽车 , 一边谈论自动驾驶的未来 , 但使用的瓦数比灯泡还少 。

文章图片

常规计算机架构与神经形态架构的对比

于是 , 解决神经形态计算问题的芯片出现了 。 最初是在20世纪80年代 , 工程师Carver Mead创造了术语“神经形态处理器”(neuromorphic processors)来描述以基于大脑的松散方式运行的计算机芯片 , 为这个领域奠定了基础 。

神经形态芯片如何运行?

Loihi芯片包含通过通信网络连接的128个独立内核 , 每个独立内核中都有大量单独的“神经元”或执行单元 , 每一个神经元都可以接收来自任何其他神经元脉冲形式的输入——同一核心中的邻居、同一芯片上不同核心中的一个单元或完全来自另一个芯片 。 随着时间的推移 , 神经元会整合它接收到的尖峰信号(Spiking Signals , 神经元通过跨突触相互发送尖峰信号进行交流) , 并根据其编程的行为来确定何时将自己的尖峰信号发送到与其连接的任何神经元 。

所有尖峰信号都是异步发生的 。 在设定的时间间隔内 , 同一芯片上的嵌入式x86内核会强制同步 。 届时 , 神经元将重新计算其各种连接的权重——本质上 , 是决定对所有向其发送信号的单个神经元给予多少关注 。

具体运行过程是 , 芯片上的部分执行单元充当树突 , 部分基于从过去行为得出的权重处理来自通信网络的传入信号 , 以确定活动何时超过临界阈值 , 并在超过时触发其自身的峰值 。 然后执行单元的“轴突”查找它与哪些其他执行单元进行通信 , 并向每个执行单元发送一个尖峰信号 。

与普通处理器不同 , 神经形态芯片没有外部RAM(Random-access memory , 随机存储器) , 而是每个神经元都有自己专用的小型内存 , 这包括它分配给来自不同神经元的输入的权重 , 最近活动的缓存 , 以及发送尖峰信号的所有其他神经元的列表 。

推荐阅读

- Intel|英特尔放出i9-12900K平台PCIe 5.0 SSD演示 突破13GB/s传输速率

- 编码|飞利浦发布 Fidelio T1 真无线降噪耳机:圈铁三单元,1699 元起

- Intel|英特尔全新第12代原装散热器实测 i5-12400最高温度73℃

- Intel|英特尔正为Linux 5.17准备PFRUT:升级系统固件无需重启

- 业绩|用Mac业绩说话!苹果摆脱英特尔,被市场证明是成功的一步

- Apple|苹果放弃英特尔的决定在今年得到了回报

- Intel|SK海力士完成接管英特尔闪存业务及国内工厂

- Intel|干翻RTX 3070Ti:曝英特尔DG2系列独显将于明年3月发售

- IT|美疾控中心发布报告称已有75艘邮轮暴发新冠疫情

- Intel|英特尔酷睿i5-1250P跑分曝光 性能超AMD Ryzen 9 5980HX