AI|像谷歌地球一样用卫星图片重建洛杉矶3D模型 港中大团队提出CityNeRF

看到下面这张动图,你会想到什么?是Google地球,还是苹果自带的3D地图?其实都不是,它是用卫星和航拍图片直接渲染生成的洛杉矶 。很难想象,如此精细的城市3D模型,竟然是用几张不同角度和高度的2D图片重建的 。

文章图片

这项研究来自香港中文大学多媒体实验室团队,叫做 CityNeRF 。

说到这里,有人应该想到了这两年大热的“神经辐射场”(NeRF),它可以用多张角度照片重建3D对象,性能出色 。量子位之前对此进行了相关报道和解读 。

文章图片

NeRF虽然恢复室内场景效果惊艳,但是直接用到城市级的卫星地图上,却面临着巨大的挑战 。

首先是拍摄相机有很大的运动自由度 。随着相机的上升,场景中的地物外观越来越粗糙,几何细节越来越少,纹理分辨率越来越低 。

同时,随着空间覆盖范围的扩大,来自外围区域的新对象会加入到视图中 。

文章图片

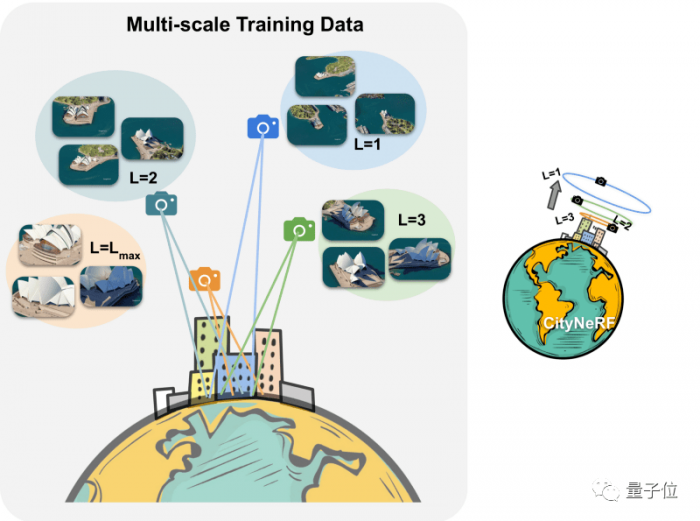

相机在这个一系列场景中,产生了具有不同细节级别和空间覆盖范围的多尺度数据 。

文章图片

如果使用原来的NeRF渲染,那么生成的远景往往不完整,周边场景区域存在伪影,近景总是具有模糊的纹理和形状 。

文章图片

什么原理?

【AI|像谷歌地球一样用卫星图片重建洛杉矶3D模型 港中大团队提出CityNeRF】针对上述问题,作者提出了采用多阶段渐进式学习范式的CityNeRF 。

作者根据相机距离将整个训练数据集划分为预定义数量的尺度 。从最远的尺度开始,每个训练阶段逐渐将训练集扩大一个更近的尺度,并同步增长模型 。

通过这种方式,CityNeRF可以稳健地学习跨场景所有尺度的表示层次结构 。

CityNeRF引入了两个特殊的设计:

1、具有残差块结构的生长模型:

在每个训练阶段附加一个额外的块来扩展模型 。每个块都有自己的输出head,用于预测连续阶段之间的颜色和密度残差,促使块在近距离观察中关注新兴细节;

2、包容的多级数据监督:

每个块的输出head由从最远尺度到其对应尺度的图像联合监督 。

换句话说,最后一个块接受所有训练图像的监督,而最早的块只暴露于最粗尺度的图像 。通过这样的设计,每个块模块都能够充分利用其能力,在更近的视图中对复杂的细节进行建模,并保证尺度之间一致的渲染质量 。

推荐阅读

- 影像|iQOO 9 系列预热:首发三星 GN5 传感器,150° 鱼眼超广角

- Google|谷歌暂缓2021年12月更新推送 调查Pixel 6遇到的掉线断连问题

- 样儿|从太空看地球新年灯光秀啥样儿?快看!绝美风云卫星图来了

- IT|新航空图像拍摄系统Microballoon:可重复使用且成本更低

- 影像|听说今天雷总和苏炳添赛跑了?

- 地球|没有了人类,地球气候环境会怎样|澎湃问吧年度盘点(上)

- Tesla|马斯克也要效仿谷歌Facebook 为特斯拉设立控股母公司?

- 影像|京东零售集团CEO辛利军空降小米“跑进2022”活动直播间为米粉送福利

- 地球|马斯克否认“星链”占用地球空间轨道:能容纳数百亿颗卫星

- SpaceX|马斯克否认“星链”占用地球空间轨道:能容纳数百亿颗卫星