识别率|一群年轻人教“AI”学手语,目标是让千万聋人被“听见”( 六 )

意识到这一点 , 近年来各国推进的手语识别、翻译项目 , 大多采用计算机视觉的方法 , 利用摄像头收集数据、建立语料库 , 袁甜甜和她的团队也是如此 。 现阶段更常见的问题 , 一是收集的样本太少 , 数据集不够大 。 二是数据集建起来了 , 但没能对语料进行高质量筛选和标注 。 说白了 , 就是语料“不好使” 。

袁甜甜说 , 人工智能深度学习的过程 , 有点像教小孩学说话 , 一个单词先得全家上阵 , 翻来覆去地重复 , 次数够了 , 孩子才能建立印象 , “哦 , 这个单词叫妈妈 , 不管是从爸爸嘴里说出来 , 姥姥嘴里说出来 , 还是舅舅、阿姨说出来 , 都叫妈妈 。 ”同样的 , 要让机器识别一个手语句子 , 也要有足够多的人面对摄像头 , 以不同的风格重复打同一套动作 , 计算机才能“记住” 。

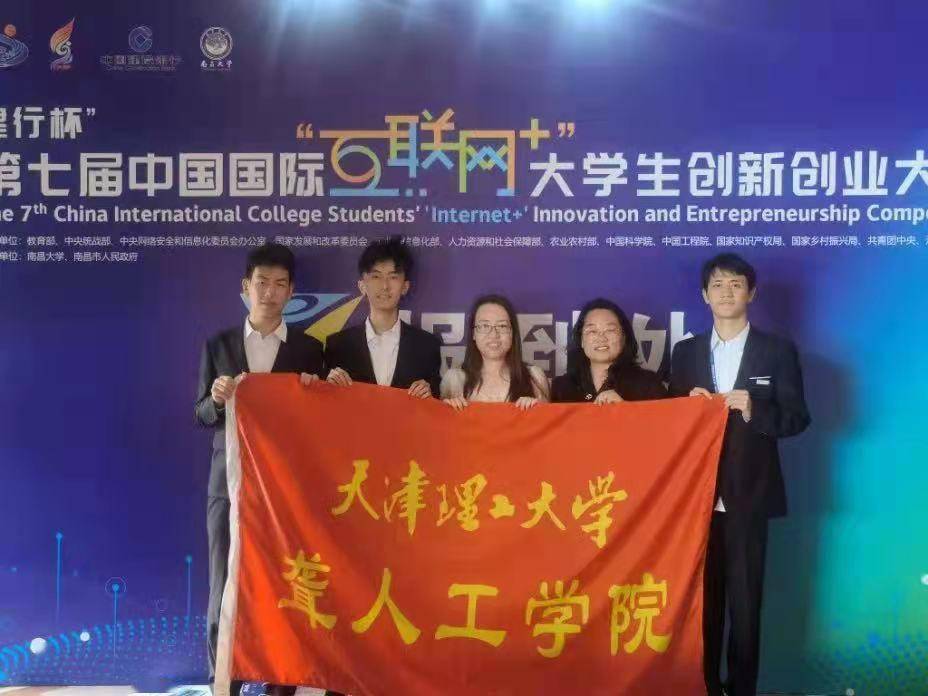

很多国外团队建立的手语数据集无法支持复杂场景下的手语翻译 , 一个直接的原因 , 就是无法找到足够多的人在自然状态下采集手语 。 “而我们的团队背靠聋人工学院 , 很多成员本身就是手语使用者 , 在自然手语的采集上有优势 。 ”袁甜甜说 。

“但是跟您实话实说 , 我们也建过‘不好使’的数据集 。 ”袁甜甜直接给团队2018年建立的手势汉语数据集下了定义 , “花了钱、费了功夫 , 最后挺失败的”——失败之处在于 , 那一次他们收集的语料是手势汉语而不是自然手语 。 手势汉语是按照健听人习惯的汉语语序 , 而不是手语语序连词成句的 。

“比如说 , ‘爱是我们共同的语言’ 。 这个句子用手势汉语来打的话 , 就是按顺序一个字一个字地比画 , ‘的’也有对应的手势 , 也要打出来 。 但聋人日常使用手语的时候 , 惯用的语序是:爱、我们、共同、语言、是 , ‘的’不用打 。 我这个‘半颤子’手语 , 讲课的时候也不会把‘的’‘了’都打出来 , 那不符合自然手语的表达习惯 。 ”袁甜甜解释 。

“你把手势汉语翻译得再精准也没用 , 聋人平时打的不是这个啊!”汲取了教训 , 这一次再建手语数据集 , 袁甜甜说 , 他们不求速成 , 只求每条语料都是原汁原味的自然手语 。 先按手语语序识别、再按口语习惯翻译 , 虽然多了一个技术环节 , 团队研发的难度也就长了一截 , 袁甜甜们却坚持要选择那条“难走但正确”的路径 。

“咱做这个研究 , 不想跟人吹我们的数据集有多大 , 也不想说我们发了多么高大上的论文 , 我们就一个目的:能用 。 ”袁甜甜斩钉截铁 , “这个系统出来了 , 聋人必须真的能用 。 ”

文章图片

推荐阅读

- IT|年轻人的第一台布加迪:纯电动折叠踏板车发布

- 本科生|“硬核”科技领域求贤若渴,上海与年轻人“一拍即合”

- 人物|董明珠:让想干事的年轻人有机会发挥 把不干事的人坚决干掉

- 轻工产业|工信部:到2025年轻工业年均增百项创新消费品

- 视点·观察|99元“代吃”一夜涨价8倍 肯德基泡泡玛特联手“收割”年轻人

- 年轻人|为什么年轻人总放不下深夜的手机?

- 手机输入法|百度输入法2021年度流行语出炉,年轻人们在用什么完成表达?

- 旗舰|真我 GT2 Pro,年轻人终于等来了可靠的旗舰机型

- 拳谱|1月7日:20~35岁的年轻人,最喜欢买什么?

- 新浪数码|三星Galaxy S21 FE 5G发布:更年轻的配色旗舰配置售价4599元