Siamese|一个框架统一Siamese自监督学习,清华、商汤提出简洁、有效梯度形式,( 三 )

文章图片

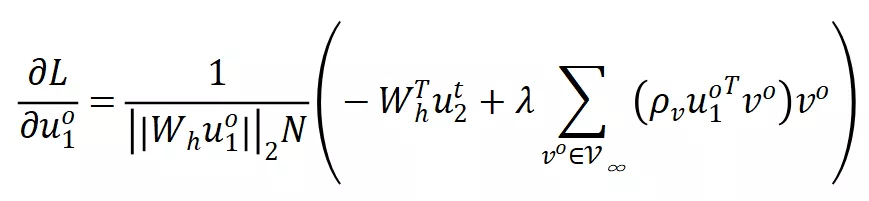

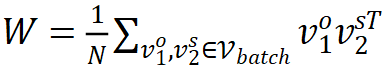

其中

文章图片

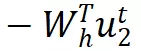

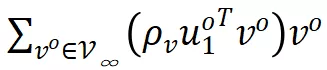

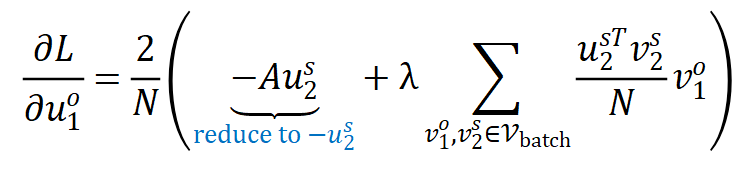

是 predictor 网络的解析解 。 可以看到 , 上式同样主要有两个部分:

文章图片

是正梯度 ,

文章图片

是负梯度 。

粗看起来这个结果非常反直觉:损失函数中没有使用负样本 , 但是梯度中却出现了负梯度 。 实际上 , 这些负样本来自于 predictor 在优化过程中学习到的信息 。 根据 DirectPred 的结论 , predictor 的特征空间会和相关性矩阵的特征空间逐渐对齐 , 因此 predictor 在训练过程中很可能会将相关性矩阵的信息编码到网络参数中 , 在反传时 , 这些信息就会以负样本的形式出现在梯度中 。

特征解耦方法

特征解耦方法旨在减小各特征维度之间的相关性来避免平凡解 。 由于不同工作采用的损失函数在形式上差异很大 , 作者对它们分别进行讨论 。

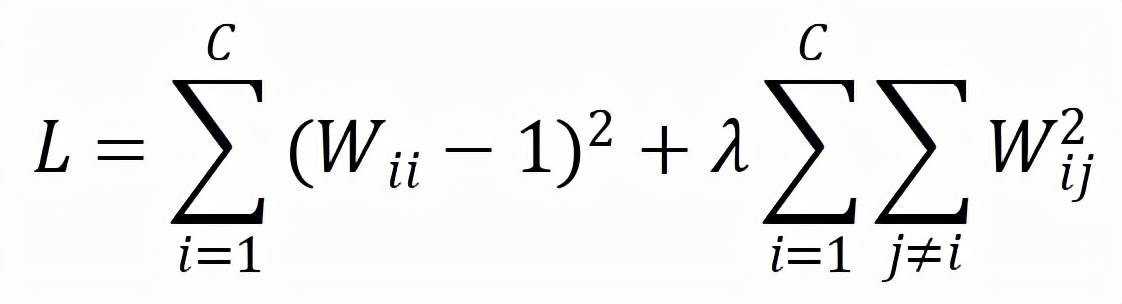

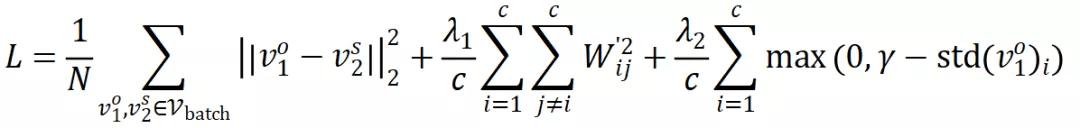

Barlow Twins 采取如下损失函数:

文章图片

其中

文章图片

是两个 augmented view 之间的相关性矩阵 。 该损失函数希望相关性矩阵上的对角线元素接近 1 , 而非对角线元素接近 0 。

该损失函数的梯度形式为:

文章图片

作者首先将第一项替换为

文章图片

, 同时 , 原始的 Barlow Twins 对特征采取了 batch normalization , 作者将其替换为

文章图片

normalization , 这些变换都不会影响到最终性能 。

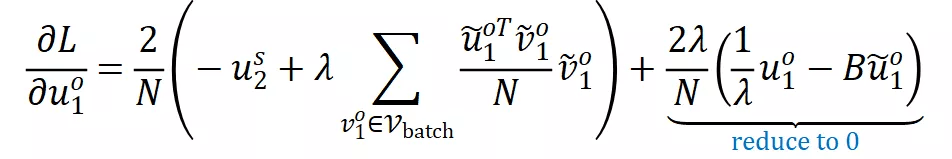

VICReg 在 Barlow Twins 的基础上做了一些改动 , 为了去掉加在特征上的 batch normalization , 它采取了如下损失函数:

文章图片

其对应的梯度形式为

文章图片

通过对特征施加

推荐阅读

- 市场资讯|“真·网红”马斯克:一个特斯拉哨子30万,大红内裤遭秒光

- 市场|刘作虎:一加达成了一个小目标

- 创事记|NFT距离元宇宙只差一个周杰伦

- 创事记|从主播开始谈一个购物需求

- 网络|白荣芳:荣耀为始 芳华绽放

- 教育|学科停船后的第一个寒假,“脑机接口”能否成为科技素质教育的后起之秀?

- 财年|小米、苹果怕不怕?索尼也要造车,还带来了一个大消息

- 新闻|一个人的生活品质,可以通过平时收藏的公众号显现出来

- 创事记|大厂难以沉下去的乡镇夫妻店,诞生了一个IPO

- IT|达拉斯希望成为福特下一个自动驾驶汽车工厂的所在地