从ADAS到自动驾驶 , 这条路应该怎么走?事实上 , 在过去的一个月时间里 , 特斯拉和Mobileye给出了两条不同的路径 。

特斯拉选择通过定制芯片来寻求在视觉人工智能能力上的持续提升 。 这款名为D1的服务器端定制芯片 , 用于高效训练Autopilot/FSD系统的机器学习算法 。 而Mobileye则推出了面向不同等级自动驾驶的硬件架构方案 , 同时自主研发部署下一代传感器 , 包括激光雷达和4D成像雷达 。

特斯拉首席执行官埃隆·马斯克在AI Day发布会上表示 , 提高用于训练公司神经网络的计算机系统的性能 , 将是自动驾驶技术进步的关键 。 “如果一个模型训练需要几天而不是几个小时 , 这就是技术的差距 。 ”

在此之前 , 特斯拉先后放弃了Mobileye和英伟达的第三方供应商芯片 , 转而自主设计了车端处理芯片 。 但由于没有更强大的数据训练平台 , 特斯拉一直以来需要倚重通过“用户测试”来发现问题 , 这在过去几年时间里带来了巨大的安全风险 。

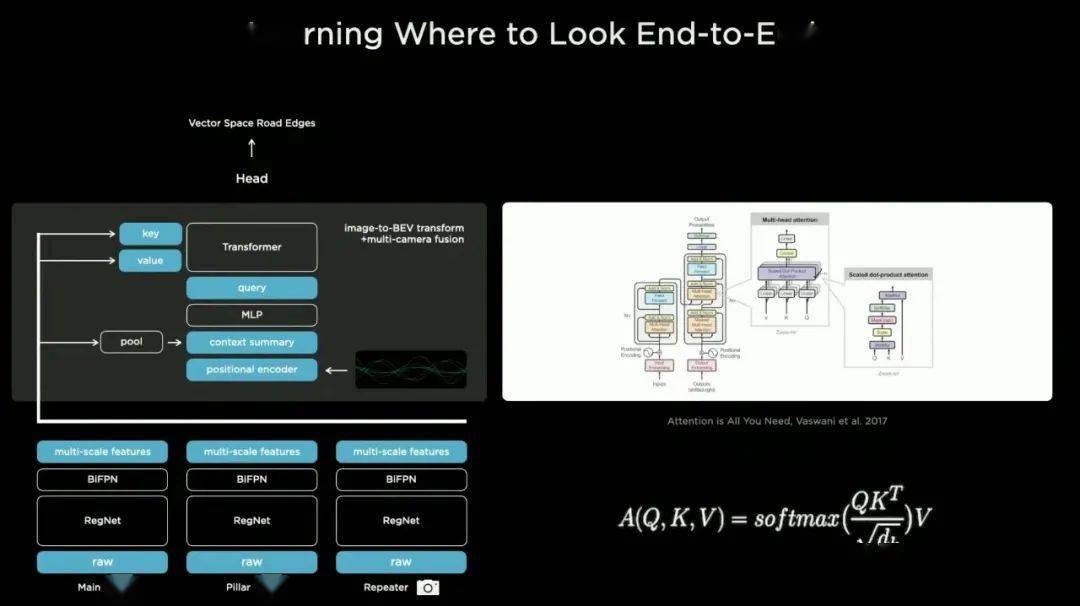

过去几年时间 , 辅助驾驶及自动驾驶初创公司都在使用神经网络来训练识别道路上的物体 , 但特斯拉更依赖这项技术 , 一个被称为“Transformer”的神经网络同时接收8个摄像头的数据输入 。

而Transformer模型最早是谷歌团队在2017年进行了应用 , 在目前自然语音处理(NLP)领域的应用非常广泛 。 而在计算机视觉领域的应用 , 同样优势明显 。

文章图片

比如 , Transformer模型摒弃了传统RNN中的循环结构 , 解决了RNN不能并行计算的限制 , 大大加快了模型训练的速度 。 同时 , 在CNN模型中 , 通过卷积计算两个位置之间的关联所需的操作次数是随距离增加的 , 而Transformer计算两个位置之间的关联所需的操作次数不随距离增加 。

更关键的是 , Transformer可以产生更具可解释性的模型 。 从上述这些优势中可以看出 , 特斯拉的目标是 , 解决模型训练的效率 , 同时对于系统做出的决策寻找更多可能的逻辑理解 。

到目前为止 , 与许多同行的策略不同 , 特斯拉没有使用激光雷达 。 相反 , 完全依赖于通过使用神经网络算法来解析来自摄像头的数据输入来解释场景 。 这需要更多的计算 , 必须根据摄像头的反馈来实时重建周围环境 。

此外 , 特斯拉也比其他公司收集了更多的真实数据用于训练 。 数据显示 , 特斯拉此前雇佣了1000名员工为这些采集的图像进行标记以帮助训练模型 。 正如特斯拉人工智能负责人安德烈·卡帕西所言 , “我们实际上是在从头开始打造系统 。 ”

不过 , 一些行业人士指出 , 特斯拉的方法有一个风险 , 那就是 , 在一定程度上增加更多的数据可能不会让系统变得更好 。 “这不是简单的增加更多数据的问题 。 ”

推荐阅读

- Tesla|最高涨幅21088元:特斯拉Model 3/Y入门车型价格调整

- 人物|马斯克谈特斯拉人形机器人:有性格 明年底或完成原型

- 方面|摩托罗拉 moto X30 推送 mr1 版更新:优化性能,新增大量功能

- Tesla|特斯拉新款Model S电池体积小能量密度高 外媒揭秘三大关键技术

- Tesla|特斯拉因两处安全缺陷召回近50万辆电动汽车 承诺免费修复

- IT|美律所对法拉第未来提起集体诉讼 涉嫌触犯证券法

- Tesla|特斯拉在美国召回约47.5万辆汽车 接近其去年全球交付总量

- Tesla|特斯拉回应“保费暴涨”:平均涨幅约10% 高性能车型不超20%

- Tesla|特斯拉Model Y保费何以一夜暴增80%?

- Tesla|网传特斯拉等新能源汽车保费上涨超50% 多家车险公司回应不实