文章图片

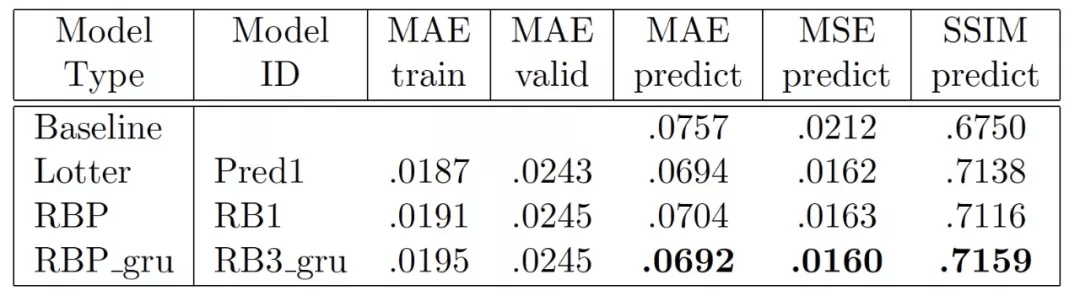

表 4. 使用 LSTM 的原始 PredNet 模型和使用 LSTM 和 GRU 的 RBP 模型的比较 。 两个模型的层损失函数权重都是[.5, .4, .2] 。 完整的模型规格可以通过查找表 3 中的模型 ID 找到 。

文章图片

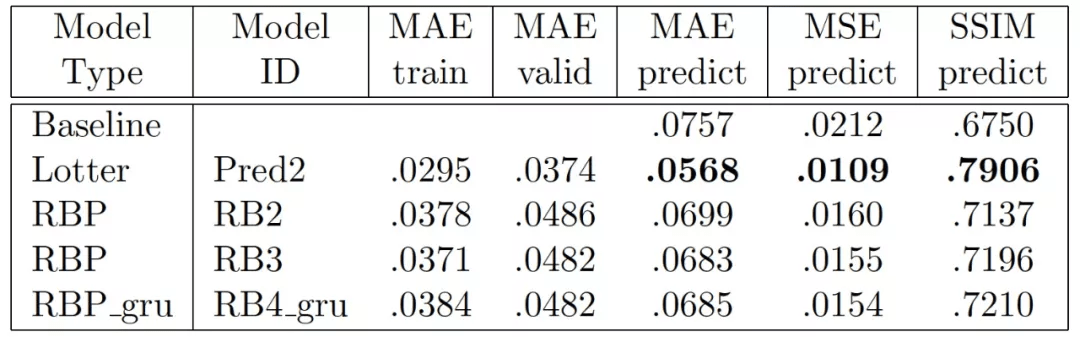

表 5. 原始 PredNet 模型和 RBP 三层模型的比较 。 两个模型的损失函数权重都是[1.0, .0, .0] 。 关于模型的更多信息可以通过在表 3 中查询模型 ID 找到

5、小结

我们在这篇文章中对经典预测编码模型和深度学习架构中的预测编码模型进行了简单回顾 。 预测编码模型使用自上而下的重构机制来预测感觉输入或其低级别的表征 , 经典预测编码模型遵循 RB 协议 。 深度学习架构的 PredNet 构建了一个误差驱动的表征层次 , 其中 ,上层表示的输入来自于前一层的预测误差 , 但 PredNet 并不满足 RB 协议 。 我们对文献 [1] 中提出的基于 RB 协议改进的 PredNet 也进行了介绍 。 由给出的实验结果分析可以 , 改进后的遵循 RB 协议的 RBP 模型确实提高了性能 。

从定义的角度出发分析 , 我们可以看出预测编码模型的目的是 “减少预测误差” 。 不过 , 如果只是通过减少预测误差来生成表征 , 那么我们是无法保证这些获取的表征对特定的任务是有效的 , 例如分类任务 。 正如文献[1] 的作者在文章最后问到的 , 指导构建高阶表征的残余误差是如何提高 PredNet 模型的学习能力的?预测误差触发了学习 , 但是否还需要什么来触发特征层次的学习?

在我们撰写这篇文章的过程中对与预测编码相关的文献进行了搜索 , 与深度学习各类论文相比 , 预测编码相关的研究论文数量还非常有限 。 正如我们在上文中提到的 , 能够真正意义上称为深度学习架构中的预测编码的模型目前也就只有 PredNet 以及基于 PredNet 进行改进的一些版本 。 笔者猜测 , 这可能与预测编码 “仅致力于减少预测误差” 有关 , 在一些专门的任务中表现可能并不亮眼 。 但是 , 这种高度模拟大脑工作机制的方法 / 模型能否在实际场景中获得较好的应用效果 , 有待后续深入的研究和探索 。

本文参考引用的文献:

[1] Hosseini M , Maida A . Hierarchical Predictive Coding Models in a Deep-Learning Framework[J]. 2020. https://arxiv.org/abs/2005.03230v1

[2] Huang Y , Rao R . Predictive coding[J]. Wiley Interdisciplinary Reviews Cognitive Science, 2011, 2(5):580-593. http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.651.127&rep=rep1&type=pdf

[3] Lotter W , Kreiman G , D Cox. Deep Predictive Coding Networks for Video Prediction and Unsupervised Learning. ICLR 2017. https://arxiv.org/pdf/1605.08104.pdf

推荐阅读

- MateBook|深度解析:华为MateBook X Pro 2022的七大独家创新技术

- 人物|最有深度的8个公众号,你关注了吗

- 国际|特奖得主任队长,清华夺冠NeurIPS 2021国际深度元学习挑战赛

- 人物|说到做到 俞敏洪首场带货直播卖啥?

- 深度|小米真无线降噪耳机 3 Pro 新年特别版即将发布,带来全新配色等

- 语音|声控智能家居控制系统,就是人与机器的深度交流

- 系列|小米 12 系列确认搭载骁龙 8 Gen 1,已经进行深度调教

- 空间|深度阅读|王赤:从孤独里找到一束光

- 深度|2021百度奖学金十强出炉:已累计投入2000万培养中国顶尖AI人才

- 巨头|国泰君安:折叠屏手机加速渗透 供应链深度受益