目前 , 英文场景已有一些针对结构化数据做预训练的探索(GAP , Grappa) , 但在中文场景该方向还处于空白状态 。

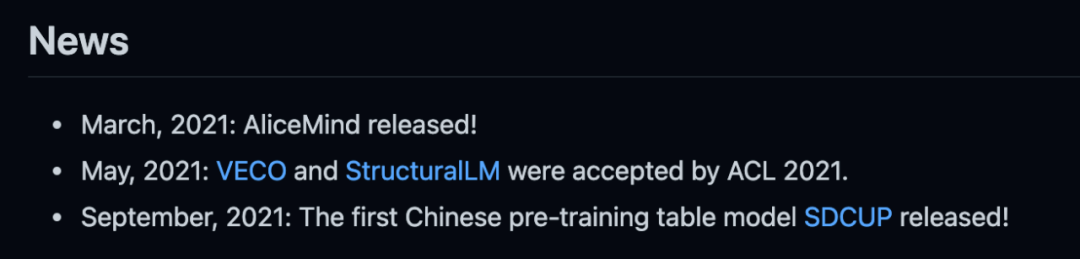

基于此 , 研究者所在的达摩院 Conversational AI 团队发布了中文首个表格预训练模型 SDCUP , 同时也是业界最大表格预训练模型(72 层 Transformer , 10 亿参数) , 在 WikiSQL、SQuALL 等多个学界 Benchmark 均取得 SOTA 效果 。

文章图片

项目地址:https://github.com/alibaba/AliceMind

预训练相关工作

和 BERT、GPT 等预训练语言模型不同 , 预训练表格模型旨在同时建模自然语言和结构化表格数据 , 在语言理解的维度希望能够将自然语言的语义 Grounding 至表格的结构内容当中 , 在语言生成的维度希望能够基于结构化数据生成流畅的文本 。

文章图片

目前谷歌、微软、亚马逊等公司都在加快对相关技术的布局 。 如下图所示 , 按照目标下游任务的不同 , 预训练表格模型可以分为三大类:单轮、多轮和生成 。

- 单轮模型旨在提升下游的 Text-to-SQL 语义解析任务 , 代表工作有耶鲁的 Grappa 和亚马逊的 GAP;

- 多轮模型旨在提升基于表格的对话式语义解析任务(CoSQL) , 代表工作有微软的 SCORE 和 Element AI 的 PICARD;

- 生成模型旨在提升 Table-to-Text 和 TableQA 的 Response Generation 生成的效果 , 代表工作有 Intel 的 TableNLG 和 HIT 的 TableGPT 。

表格问答相关工作

一个表格问答系统主要由三个模块组成 , 其中:

- 自然语言理解模块主要执行语义解析算法 , 将自然语言问句转为对应可执行的 SQL 语句;

- 对话管理模块执行多轮的状态跟踪和策略优化;

- 自然语言生成模块则根据解析出的 SQL 语句和 SQL 的执行结果生成对应的回复 。

推荐阅读

- 研究院|传统行业搭上数字化快车,施工现场变“智造工厂”

- 机器|戴森达人学院 | 戴森HP09空气净化暖风扇测评报告

- 美容|升级扩业 中家医·家庭医生医疗美容医院引爆广州

- 问答|紧追B站加码知识类内容,抖音上线“学习频道”

- 文化|【“用数赋智”系列宣讲】苏州工艺美术职业技术学院探索传统工艺的跨界创新

- IT|南非研究显示两剂强生新冠疫苗可大幅降低Omicron导致的住院

- 团队|深信院41项科研项目亮相高交会 11个项目获优秀产品奖

- 索尼|索尼推出两款无线低音炮、环绕音箱,适配家庭影院

- 生命科学学院|科技馆内感受科技魅力

- 互联网|首儿所互联网医院办公区启用 为患者提供就医便利